Im Jahr 2025 veröffentlichten Andreas Happe und Jürgen Cito von der TU Wien".Über die überraschende Wirksamkeit von LLMs für Penetrationstests" und enthüllt eine verblüffende Realität: Große Sprachmodelle (Large Language Models, LLMs) können mit menschlichen Experten mithalten - und sie manchmal sogar übertreffen - bei wichtigen Pentesting-Aufgaben wie der Mustererkennung, der Konstruktion von Angriffsketten und dem Umgang mit Unsicherheiten in dynamischen Umgebungen, und das alles bei kostengünstiger Skalierbarkeit.

Vor dem Hintergrund eskalierender Cyber-Bedrohungen, eines gravierenden Fachkräftemangels und zunehmend komplexer Unternehmensinfrastrukturen markiert dies eine neue Ära: eine Verlagerung von kommandozeilengesteuerter "schwarzer Magie" zu KI-unterstützte Sicherheitstests. Mit KI, die in das offensive Sicherheitstoolkit eingebettet ist, können Unternehmen die Testzyklen von Tagen auf Stunden verkürzen und fortgeschrittene Pentesting-Fähigkeiten in eine für jeden zugängliche Sicherheitsinfrastruktur verwandeln.

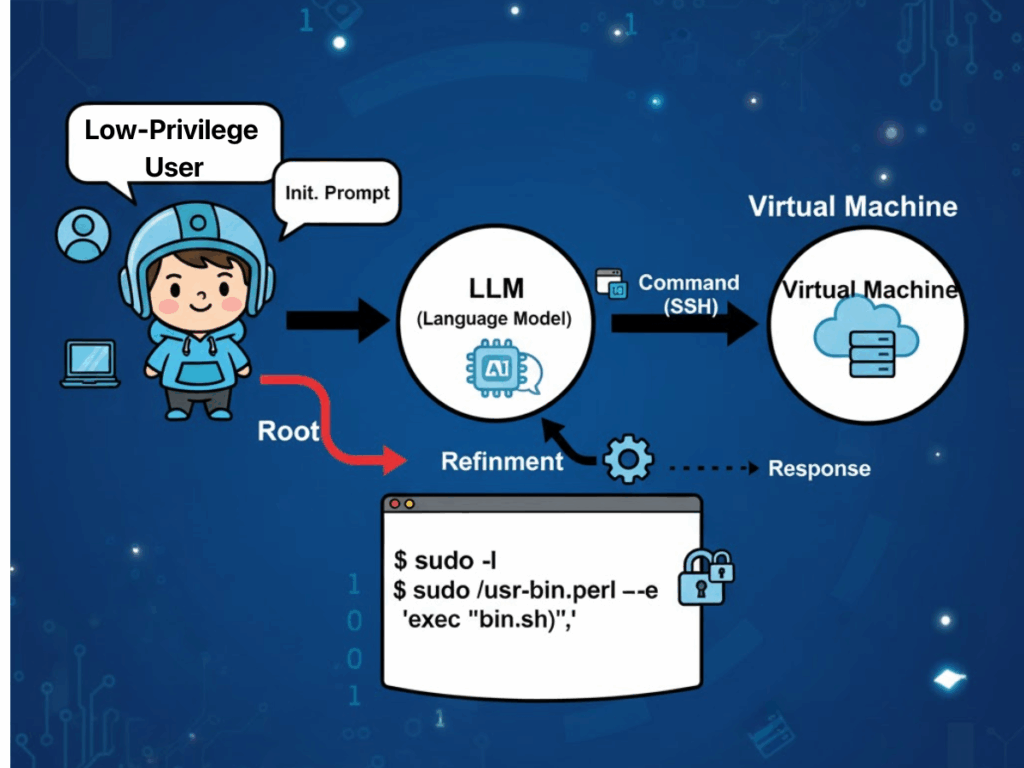

Wie werden LLMs bei Penetrationstests eingesetzt?

"Empirische Belege aus "Über die überraschende Wirksamkeit von LLMs für Penetrationstests" legt nahe, dass die operativen Merkmale von Large Language Models ungewöhnlich gut mit den realen Praktiken von Penetrationstestern übereinstimmen. Ein häufig genannter Faktor ist das Vorherrschen technologischer Monokulturen innerhalb der Unternehmensinfrastruktur. Diese Homogenität ermöglicht es LLMs, ihre außergewöhnlichen Fähigkeiten zur Mustererkennung zu nutzen, um wiederkehrende Sicherheitsfehlkonfigurationen und Schwachstellensignaturen zu identifizieren, die Beispiele aus ihren Trainingskorpora widerspiegeln. Infolgedessen können die Modelle Angriffsstrategien formulieren, die direkt auf bekannte Angriffspfade abgebildet werden, wodurch der von menschlichen Testern üblicherweise erforderliche Erkundungsaufwand minimiert wird.

Ein weiterer wesentlicher Vorteil liegt in der Fähigkeit von LLMs, Unsicherheiten in dynamischen und sich verändernden Zielumgebungen zu bewältigen. In mehrstufigen Penetrationsübungen synthetisiert das Modell kontinuierlich die beobachteten Bedingungen - wie z. B. die Reaktionen der Dienste, das Authentifizierungsverhalten oder partielle Fehlerzustände - zu einer sich entwickelnden "Weltsicht". Diese Darstellung dient als Grundlage für die anschließende Entscheidungsfindung und ermöglicht es dem Modell, fließend zwischen verschiedenen Taktiken zu wechseln und irrelevante oder veraltete Annahmen zu verwerfen, ohne die starren Verfahrensbeschränkungen, die regelbasierte Systeme belasten.

LLMs bieten auch Vorteile in Bezug auf Kosteneffizienz und Skalierbarkeit. Standardmodelle für allgemeine Zwecke haben bereits bewiesen, dass sie komplexe offensive Sicherheitsaufgaben bewältigen können, was den Bedarf an ressourcenintensivem Training für domänenspezifische Systeme verringert. Selbst dort, wo zusätzliches Kontextwissen erforderlich ist, können Techniken wie kontextbezogenes Lernen und Retrieval-Augmented Generation (RAG) die Fähigkeiten erweitern, ohne dass ein erneutes Training erforderlich ist, was den Einsatz in verschiedenen organisatorischen Umgebungen beschleunigt. Wichtig ist, dass diese Flexibilität nicht nur in akademischen Testumgebungen, sondern auch in produktionsnahen Szenarien zum Tragen kommt.

Schließlich steigert die in LLM-gesteuerte Workflows integrierte Automatisierung die Produktivität, indem sie die traditionelle Lücke zwischen Erkennung und Behebung schließt. Das Modell ist in der Lage, die Authentizität der anfänglichen Ergebnisse zu validieren, falsch-positive Ergebnisse herauszufiltern, die durch vorübergehende Netzwerkbedingungen oder Tool-Einschränkungen verursacht werden, und eine kontextabhängige Priorisierung anzuwenden, die die Abhilfemaßnahmen auf die Schwachstellen mit den größten Auswirkungen lenkt. Ein solcher End-to-End-Fluss - von der Erkundung über die Validierung bis hin zu umsetzbaren Berichten - verkürzt die Betriebszeiten von Tagen auf Stunden, während gleichzeitig ein Maß an Transparenz in der Argumentation und Methodik beibehalten wird, das für Audits und behördliche Überprüfungen förderlich ist.

Herausforderungen des LLM-basierten Pentesting

Diesen Vorteilen stehen jedoch erhebliche Herausforderungen gegenüber, die sich im betrieblichen Kontext ergeben.

Zuverlässigkeitsaspekte und Sicherheitsrisiken

Stabilität und Reproduzierbarkeit sind nach wie vor problematisch: Geringfügige Unterschiede zwischen den Modellversionen können zu Abweichungen bei der Verwendung von Werkzeugen oder der Angriffssequenzierung führen. Unter identischen Bedingungen können mehrere Durchläufe völlig unterschiedliche Angriffsketten ergeben, was die Konsistenz der Ergebnisse untergräbt und die Validierung erschwert. Bei dynamischen Tests ist die adaptive Strategie zwar eine Stärke, aber unzureichend eingeschränkte Modelle können vom beabsichtigten Aufgabenbereich abweichen und irrelevante oder sogar unsichere Aktionen ausführen, wenn die Leitplanken nicht durchgesetzt werden.

Kosten und Energieaufwand

Der Ressourcenverbrauch stellt eine weitere Einschränkung dar. Modelle mit hoher Kapazität erfordern eine wesentlich höhere Rechenleistung, wobei der Energieverbrauch bis zu siebzigmal höher ist als bei kleineren, aufgabenspezifischen Modellen. Für Unternehmen, die dauerhafte oder groß angelegte autonome Pentesting-Einsätze planen, bedeutet dies erhebliche Betriebskosten und Umweltauswirkungen. Die Automatisierung selbst ist zweischneidig: Die Priorisierungslogik eines Modells kann Erkenntnisse mit geringerer Priorität übersehen, die jedoch erhebliche latente Risiken darstellen, so dass eine qualifizierte menschliche Aufsicht erforderlich ist, um solche Auslassungen zu erkennen.

Datenschutz und digitale Souveränität

Datenschutz- und Compliance-Bedenken sind nach wie vor akut, vor allem, wenn Cloud-Inferenzen verwendet werden. Eingabedaten wie Konfigurationsdateien, urheberrechtlich geschützte Codesegmente oder Umgebungsdetails können über API an Drittanbieter übertragen werden, was die Gefahr von Verstößen bei der grenzüberschreitenden Datenübertragung birgt. Multinationale Unternehmen müssen die Produktivitätsvorteile der LLM-Integration mit der Realität abwägen, die sich aus den unterschiedlichen regionalen Compliance-Gesetzen ergibt.

Zweideutige Rechenschaftspflicht

Und schließlich ist die Verantwortlichkeit ungeklärt: Sollten KI-gesteuerte Tests versehentlich Produktionssysteme stören oder Datenverluste verursachen, bietet die derzeitige Rechtslage keine eindeutige Zuweisung der Verantwortung und setzt Unternehmen vertraglichen und regulatorischen Risiken sowie Reputationsrisiken aus.

Penligent.ai: Die KI-Red-Team-Revolution

Penligent.ai ist eine spezielle Antwort auf viele dieser Hürden. Beschrieben als die weltweit erste Agentischer AI-HackerDie Lösung geht über die Aufgaben von eigenständigen Scannern oder starren Automatisierungsskripten hinaus, indem sie Anweisungen in natürlicher Sprache interpretiert, komplexe Ziele in ausführbare Teilaufgaben zerlegt, aus einer integrierten Bibliothek von über 200 branchenüblichen Sicherheitstools auswählt und diese intelligent koordiniert, um validierte, nach Prioritäten geordnete Schwachstellenlisten zu erstellen, die von Anleitungen zur Behebung begleitet werden.

Die Transparenz ist in den Arbeitsablauf integriert: Die Benutzer können jeden Argumentationsschritt verfolgen, genau sehen, welches Tool aufgerufen wurde, und verstehen, warum bestimmte Schlussfolgerungen gezogen wurden und welche Maßnahmen folgen werden. Dieses Design stärkt das Vertrauen und erleichtert Audits und macht Penligent nicht nur zu einem Tool, sondern zu einem kollaborativen Red-Team-Partner, der von der individuellen Nutzung bis hin zum Unternehmenseinsatz skalierbar ist. Durch die Einbettung einer Compliance-bewussten Logik, die sich an Frameworks wie NIST TEVV und OWASP's Generative AI Red-Teaming Richtlinien orientiert, schließt Penligent die Lücke zwischen Automatisierungspotenzial und regulierter Praxis.

Beispielhafte Demonstration

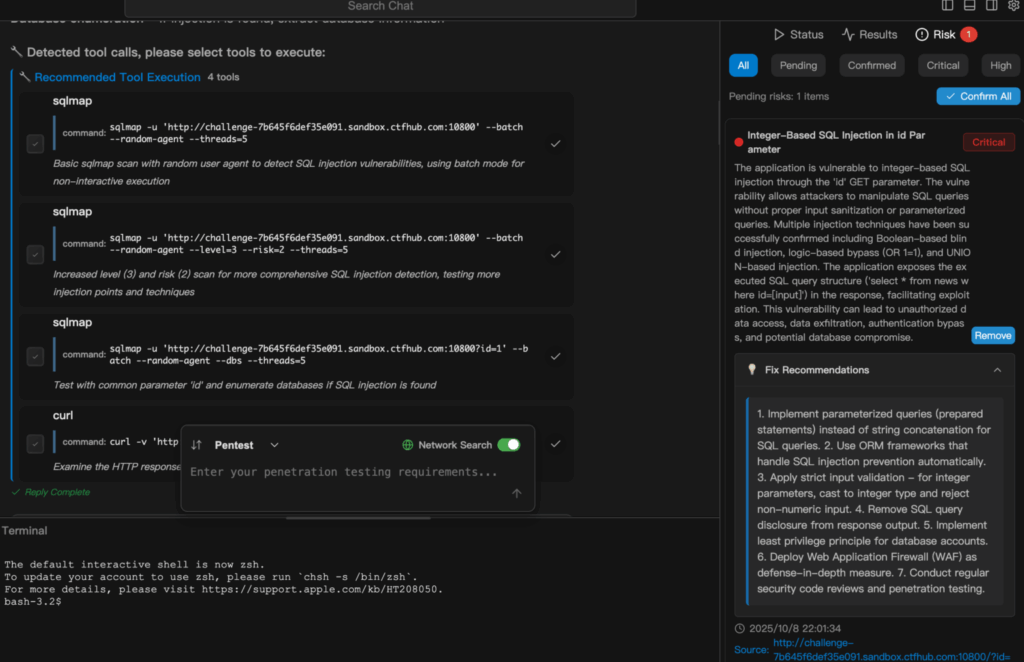

Der folgende Auszug beschreibt, wie Penligent.ai von einer einfachen Aufgabe in natürlicher Sprache zu einem vollständig ausgeführten und gemeldeten Sicherheitstest übergeht. Hier ist ein Beispiel für die Ausführung eines SQL-Injection-Scan in Penligent.

Schlussfolgerung

Von der akademischen Validierung der Fähigkeiten in "Über die überraschende Wirksamkeit von LLMs für Penetrationstests" zur operationellen Verfeinerung, die in Penligent.aiDie Entwicklung von KI-gestützter offensiver Sicherheit ist eindeutig: Die Tools reifen vom Proof-of-Concept zu produktionsreifen Plattformen. Für Cybersicherheitsexperten, Penetrationstester und KI-Sicherheitsenthusiasten ist dies weniger eine schrittweise Verbesserung als vielmehr ein Wechsel des zugrunde liegenden Paradigmas. Durch die Reduzierung der Zykluszeit, die Senkung der Eintrittsbarrieren, die Verbesserung der Transparenz und die Integration der Compliance von Anfang an, Penligent.ai ist ein Beispiel dafür, wie intelligente Automatisierung sowohl menschlichen Experten als auch Laien dabei helfen kann, die Systeme, von denen die moderne Wirtschaft abhängt, zu schützen - und zu testen.

Die Herausforderung besteht nun nicht darin, zu beweisen, dass diese Systeme funktionieren, sondern darin, sie verantwortungsvoll einzusetzen: Stabilität und Reproduzierbarkeit zu gewährleisten, Missbrauch einzudämmen, die Privatsphäre zu schützen und Rechenschaft abzulegen. Wenn es richtig gemacht wird, kann das KI-gestützte Pentesting nicht nur ein Wettbewerbsvorteil sein, sondern auch ein grundlegender Bestandteil der Sicherheitsvorkehrungen in einer Zeit, in der sich die Bedrohungen schneller als je zuvor entwickeln.