Resumen

Las secuencias de comandos en sitios cruzados (XSS) siguen siendo una de las vulnerabilidades web más frecuentes y peligrosas. Los modernos frameworks front-end, las SPA (aplicaciones de página única) y los ricos ecosistemas de scripts de terceros aumentan tanto las oportunidades como la complejidad. Este artículo combina la hoja de trucos para la prevención de XSS de OWASP con recientes investigaciones académicas y de la industria, formando una estrategia de defensa por capas: codificación contextual, sanitización HTML, rastreo dinámico de taint para DOM XSS, parsing-differential fuzzing, política de seguridad de contenidos (CSP) y controles de la cadena de suministro. Además, proponemos un diseño de escaneo XSS con un solo clic dentro de Penligent, con canalizaciones automatizadas, plantillas de exploración reutilizables, instrumentación en tiempo de ejecución y generación de informes. Este documento es adecuado para su inclusión directa en libros blancos de ingeniería o documentación de productos.

Motivación

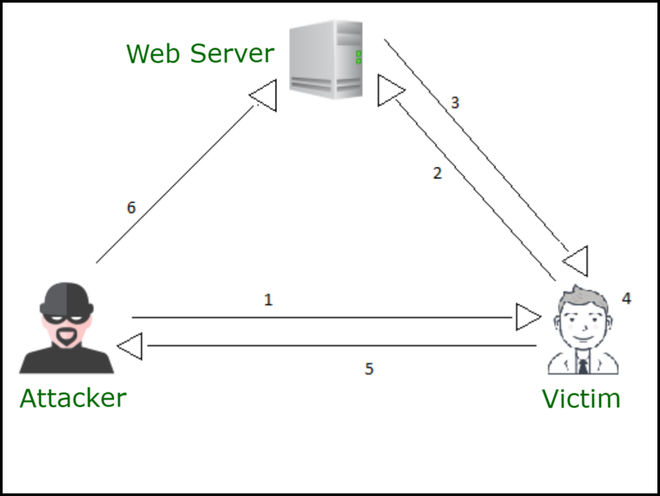

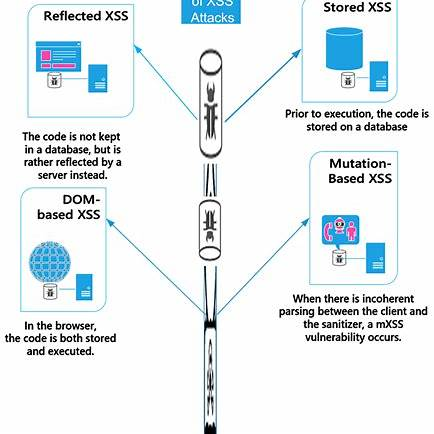

Las vulnerabilidades XSS permiten a los atacantes inyectar scripts ejecutables en páginas web por lo demás benignas, ejecutándose efectivamente en el navegador de la víctima bajo los privilegios del dominio del sitio. Estos ataques pueden filtrar datos sensibles (cookies, localStorage), realizar acciones no autorizadas o desfigurar el contenido. (Documentos web MDN)

A pesar de décadas de concienciación y técnicas de mitigación, el XSS sigue siendo un riesgo persistente. El aumento de la renderización del lado del cliente, los marcos dinámicos de JavaScript, los scripts de terceros y los sistemas de plantillas cada vez más complejos han hecho más difícil garantizar la corrección.

Objetivos de esta guía:

- Combine las reglas prácticas de la autorizada OWASP Cheat Sheet con investigaciones académicas y de ingeniería actualizadas.

- Ofrecer una arquitectura de defensa sólida y de varios niveles en lugar de una única bala de plata.

- Presentar un diseño concreto para que Penligent proporcione un Análisis XSS con un solo clic que tiende un puente entre la investigación y el producto.

Fundamentos: Codificación contextual y sumideros seguros

Un principio básico de la prevención de XSS es: no permitir nunca que datos brutos no fiables lleguen a un contexto ejecutable sin la codificación o limpieza adecuadas. La codificación debe ser apropiada al contexto (cuerpo HTML, atributo, literal JavaScript, CSS, o URL). Esta es la esencia de la hoja de trucos para la prevención de XSS de OWASP. (cheatsheetseries.owasp.org)

Reglas de codificación de la salida contextual

| Contexto | Ejemplo inseguro | Codificación segura / Mitigación |

|---|---|---|

| Contenido de texto HTML | <div>${userInput}</div> | Codificación de entidades HTML (<, &etc.) |

| Atributo HTML | <img src="${url}"> | Citar atributo + codificación de atributo; validar esquema URL |

| JavaScript literal | <script>var v = '${userInput}';</script> | Escape de cadenas JS (\uXXXXescape de comillas/barras invertidas) |

| CSS | <div style="width:${input}px"> | Validación estricta, escape de CSS o no permitir CSS dinámico |

| URL / HREF | <a href="${href}">haga clic en</a> | Codificación por porcentaje, lista blanca de esquemas (http/https), canonicalización |

En la práctica, prefiera siempre las bibliotecas de codificación integradas o bien probadas. Evita hacer tus propios reemplazos ad hoc.

Fregaderos seguros y cómo evitar API peligrosas

Incluso con una codificación correcta, ciertas API son intrínsecamente arriesgadas. Algunos ejemplos de sumideros peligrosos son:

innerHTML,outerHTMLdocument.write,document.writelneval(),Función()constructor- Controladores de eventos en línea (p. ej.

onclick="..."con contenido dinámico)

Prefiera alternativas seguras:

.textContento.innerTextpara insertar textoelement.setAttribute()(para nombres de atributos controlados)- Métodos DOM (por ejemplo

appendChild,createElement) sin concatenación de cadenas

Saneamiento HTML cuando se necesita HTML enriquecido

En los casos en los que se permite que el contenido proporcionado por el usuario incluya algo de HTML (por ejemplo, editores WYSIWYG, comentarios con marcas limitadas), es necesaria una limpieza. El planteamiento básico es el siguiente:

- Lista blanca etiquetas, atributos y patrones de valores de atributos permitidos.

- Utilice bibliotecas maduras (por ejemplo, DOMPurify) en lugar de frágiles expresiones regulares personalizadas.

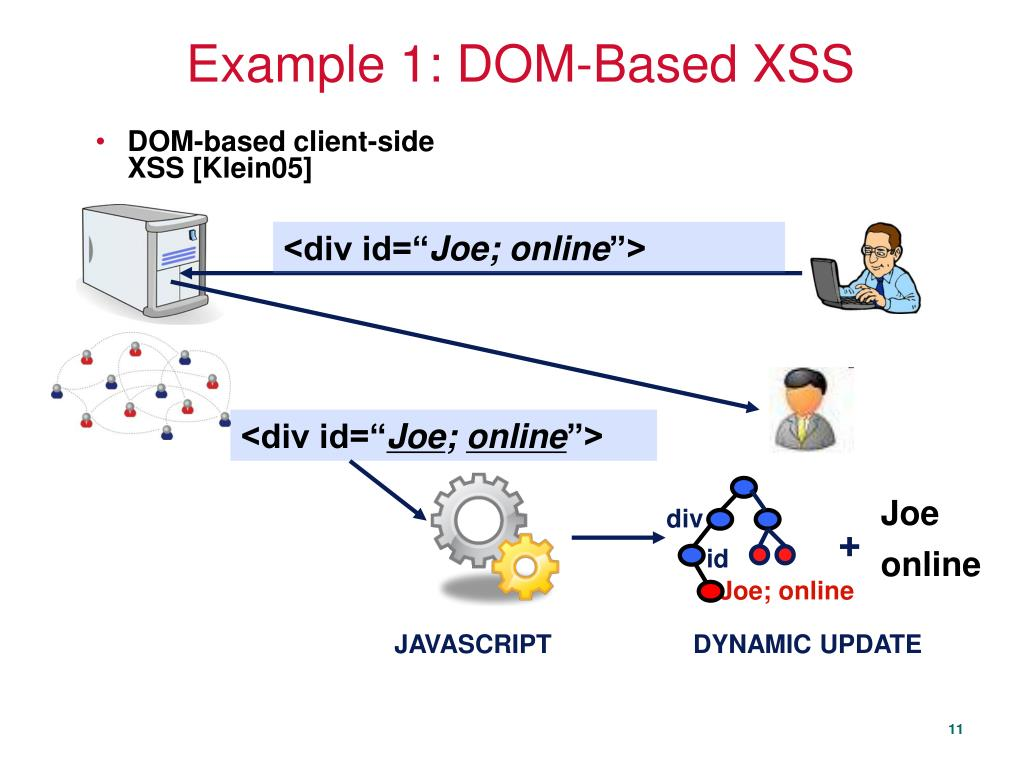

- Tenga en cuenta ataques diferenciales de análisis sintácticoEl comportamiento de análisis del desinfectador puede diferir del analizador HTML del navegador, lo que puede dar lugar a omisiones.

Una línea de investigación conocida demuestra cómo los desinfectadores y los navegadores pueden divergir en la interpretación del marcado de mayúsculas y minúsculas, permitiendo escapes a través de una tokenización alternativa. (Véase la investigación "Diferenciales de análisis sintáctico").

Detección de XSS basado en DOM mediante el rastreo de manchas en tiempo de ejecución

Las técnicas del lado del servidor no pueden DOM XSS (inyección del lado del cliente), porque el sumidero relevante puede estar en JavaScript después de la carga de la página. El rastreo dinámico de manchas (marcar fuentes no fiables y vigilar la propagación) es un método bien estudiado.

- TT-XSS (por R. Wang et al.) es una implementación clásica de la detección DOM XSS basada en taint dinámico. (科学直通车)

- Hablar de mi generación utiliza el análisis dinámico del flujo de datos para generar exploits DOM XSS dirigidos. (ResearchGate)

- TrustyMon (2025) demuestra un sistema práctico de monitorización en tiempo de ejecución que puede detectar XSS basado en DOM en aplicaciones del mundo real con gran precisión y pocos falsos positivos. (Biblioteca Digital ACM)

Estos sistemas instrumentan la ejecución en el lado del cliente, etiquetan las entradas no fiables (por ejemplo, hash de URL, parámetros de consulta, elementos DOM) y detectan cuándo llegan a sumideros peligrosos (por ejemplo. innerHTML) de forma que se ejecute el script.

Una advertencia: el seguimiento en tiempo de ejecución tiene un coste de rendimiento. Algunos trabajos combinan ML/DNN como prefiltro para reducir la sobrecarga del rastreo de manchas. Por ejemplo, Melicher et al. proponen utilizar el aprendizaje profundo para preclasificar las funciones probablemente vulnerables y aplicar el rastreo de manchas solo allí. (contrib.andrew.cmu.edu)

Ejemplo A - Fregadero fijo (uso seguro) textoContenido)

<html>

<head><title>Bienvenido</title></head>

<body>

<h1>¡Hola!</h1>

<div id="greeting"></div>

<script>

function getQueryParam(name) {

return new URLSearchParams(window.location.search).get(name);

}

var raw = getQueryParam("name") || "";

// Use textContent to insert as plain text (safe)

document.getElementById("greeting").textContent = raw;

</script>

<p>Bienvenido a nuestra web.</p>

</body>

</html>Por qué es seguro: textoContenido escribe texto sin formato; incluso si en bruto contiene <script>…</script>se mostrará como texto, no se ejecutará. También usando URLSearchParams evita el análisis sintáctico frágil de índices y subcadenas. portswigger.net

Ejemplo B - Sumidero de atributos y gestión segura de URL (pseudo-sumidero href)

Patrón vulnerable:

// Vulnerable:

var params = new URLSearchParams(window.location.search);

var target = params.get("url"); // controlado por el usuario

document.getElementById("mylink").href = target;

Si objetivo es código javascript, al hacer clic en el enlace se ejecuta JS.

Patrón seguro (validar esquema):

function safeHref(input) {

try {

var u = new URL(input, window.location.origin);

if (u.protocol === "http:" || u.protocol === "https:") {

return u.toString();

}

} catch(e) { /* invalid URL */ }

return "#";

}

document.getElementById("mylink").href = safeHref(params.get("url"));Explicación: nueva URL() se normaliza; sólo permitimos http:/https: esquemas. Esto bloquea javascript:/datos: esquemas. portswigger.net

Política de seguridad de contenidos (CSP): Defensa en profundidad

Mientras que la codificación y el saneamiento son defensas primarias, CSP proporciona un fuerte barrera secundaria. Un CSP bien configurado que utilice nonces o hashes, junto con dinámico-estricto y eliminación de unsafe-inlinepuede limitar en gran medida la explotación de XSS.

Sin embargo, existen escollos:

- Reutilización de Nonce: Algunos sitios reutilizan el mismo nonce en múltiples respuestas, lo que socava las protecciones de CSP. Un estudio reciente "The Nonce-nce of Web Security" muestra que muchos sitios del mundo real hacen esto. (arXiv)

- Complejidad de la implantación: la compatibilidad con secuencias de comandos en línea heredadas, bibliotecas de terceros e incoherencias de los navegadores suele conducir a una relajación de las políticas.

Por lo tanto, la CSP debe complementar, no sustituir, la codificación y el saneamiento.

Mejores prácticas de ingeniería: CI, Lint, Pruebas, Supervisión

Para poner en funcionamiento defensas XSS sólidas:

- ESLint / Linters de códigoprohibir o marcar el uso de sumideros no permitidos (innerHTML, eval), exigir anotaciones de contexto en las expresiones de plantilla.

- Análisis estático y dinámico en la IC:

- Análisis estático de manchas en varios archivos para módulos JS

- Pruebas fuzz o de análisis sintáctico diferencial

- Instrumentación en tiempo de ejecución en entornos de ensayo

- Pruebas unitarias y de seguridadgenerar cargas útiles basadas en el contexto en pruebas unitarias para garantizar que se aplica la codificación correcta (como en "Detección y reparación automatizadas de vulnerabilidades XSS" o "Detección de XSS mediante pruebas unitarias") (arXiv)

- Supervisión y alerta: recopilan informes de infracciones de CSP, alertas instrumentadas en tiempo de ejecución de flujos sospechosos, métricas de registro de fallos de codificación.

Diseño de Penligent One-Click XSS Scan

A continuación se muestra una especificación de diseño propuesta que puede incrustar en el producto de Penligent como una escaneo XSS con un solo clic "Playbook".

Flujo de trabajo de tareas (alto nivel)

- Rastreo y renderización JS - descubrir todas las páginas y rutas controladas por JS.

- Análisis estático - propagación de manchas en el código fuente para localizar sumideros y funciones de alto riesgo.

- Escaneado de plantillas - utilizar escáneres con plantillas (por ejemplo, Nuclei) para disparar cargas útiles XSS comunes.

- Tiempo de ejecución / exploración dinámica - utilizando la navegación headless y la instrumentación, inyectar cargas útiles y detectar la ejecución de scripts.

- Rastreo de manchas en tiempo de ejecución - instrumentar el tiempo de ejecución de la página y vigilar si datos no fiables llegan a sumideros peligrosos.

- Prueba fuzz de análisis diferencial - alimentar el sanitizador + navegador con marcas de borde y detectar divergencias.

- Auditoría CSP & SRI - inspeccionar cabeceras, etiquetas de script, comprobar la reutilización de nonce, atributos de integridad faltantes.

- Generación de informes - reúna vulnerabilidades con PoCs, calificación de riesgo, sugerencias de remediación y, opcionalmente, genere parches PR.

Plantilla de Núcleos de Muestra (XSS Reflejado)

id: xss-reflect-basic

info:

name: XSS Reflejado Básico

autor: penligent-scan

gravedad: alta

peticiones:

- método: GET

ruta:

- "{{BaseURL}}?q={{carga}}"

payloads:

payload:

- ""

matchers:

- tipo: word

parte: cuerpo

palabras:

- ""Se ampliaría con conjuntos de cargas útiles conscientes del contexto (atributo, JS, URL) y se encadenaría a la verificación sin cabeza para reducir los falsos positivos.

Ejemplo de definición de tarea (JSON)

{

"nombre": "XSS QuickScan",

"steps": [

{"id": "crawl", "type": "crawler", "params": {"start_url": "{{target}}", "render_js": true}},

{"id": "static", "type": "static_analysis", "deps": ["crawl"], "params": {"analyzers": ["multi-file-taint"]}},

{"id": "template_scan", "type": "scanner", "deps": ["crawl"], "params": {"templates": ["xss-reflect-basic"]}},

{"id": "dynamic", "type": "dynamic_scan", "deps": ["template_scan", "static"], "params": {"engine": "headless-instrumented"}},

{"id": "dom_taint", "type": "runtime_taint", "deps": ["dynamic"], "params": {"agent": "instrumented-browser"}},

{"id": "parsing_diff", "type": "parsing_diff", "deps": ["dynamic"], "params": {}},

{"id": "audit_csp", "type": "csp_audit", "deps": ["crawl"], "params": {}},

{"id": "report", "type": "report_gen", "deps": ["dom_taint", "parsing_diff", "audit_csp"], "params": {"format": "pdf,html"}}

]

}Informe y resultados

Cada hallazgo incluye:

- Tipo (reflejado / almacenado / DOM)

- Prueba de concepto (solicitud/respuesta HTTP, instantánea del DOM, captura de pantalla)

- Puntuación de gravedad

- Sugerencias de corrección (por ejemplo, codificador correcto, configuración del desinfectante, uso seguro de la API)

- Opción de autogenerar un esqueleto de parche o PR

También puede enlazar a la literatura relevante (por ejemplo, citando TrustyMon, analizando documentos diferenciales) en el informe técnico interno.

Ejemplos de fragmentos de código y buenas prácticas

He aquí algunos fragmentos ilustrativos seguros/inseguros en un entorno similar a React:

Inseguro (vulnerable)

function UserGreeting(props) { devuelve ; }Versión más segura

import DOMPurify from 'dompurify';

function UserGreeting(props) {

const clean = DOMPurify.sanitize(props.userContent, { ALLOWED_TAGS: ['b','i','u','a'], ALLOWED_ATTR: ['href'] });

devolver <div dangerouslysetinnerhtml="{{" __html: clean }} />;

}O, mejor:

function UserGreeting(props) {

devuelve <div>{props.userContent}</div>; // React escapará automáticamente

}Para los valores de los atributos:

// Unsafe

<img src={userInput} />

// Safer

function safeUrl(u) {

const doc = new URL(u, window.location.origin);

if (doc.protocol === 'http:' || doc.protocol === 'https:') {

return doc.toString();

}

return '/'; // fallback

}

<img src={safeUrl(userInput)} />Conclusión y próximos pasos

Este artículo fusiona la Hoja de trucos OWASP para la prevención de XSS (normas pragmáticas) con orientaciones modernas de la investigación (contaminación en tiempo de ejecución, diferencial de análisis sintáctico, prefiltro ML) para crear un enfoque de defensa sólido y fácil de usar. El diseño del análisis Penligent de un solo clic ayuda a producir estos métodos, lo que facilita a los equipos la adopción de defensas sólidas sin reinventar los procesos.