La IA ya no se limita a responder a las solicitudes, sino que actúa. Cuando un agente puede leer correos electrónicos, buscar documentos, llamar a API o activar flujos de trabajo, ya no solo ayuda a los humanos, sino que se convierte en un actor independiente dentro de un ecosistema digital. Este cambio marca una nueva era en la ciberseguridad, en la que el atacante no es necesariamente un adversario humano, sino un proceso autónomo. La aparición del Hacker de Inteligencia Artificial pone de relieve un riesgo fundamental: la propia autonomía se ha convertido en una superficie explotable.

El auge de la autonomía agéntica representa un punto de inflexión tanto en productividad como en vulnerabilidad. Los sistemas agenéticos están diseñados para autodirigirse; interpretan instrucciones, planifican tareas y ejecutan múltiples pasos a través de servicios interconectados, a menudo sin supervisión humana directa. Esto es precisamente lo que los hace tan poderosos y, al mismo tiempo, tan peligrosos. Investigaciones recientes, como el estudio "Silent Exfiltration" de Straiker, demostraron que un solo correo electrónico manipulado podía hacer que un agente de IA filtrara datos confidenciales de Google Drive sin que el destinatario abriera el mensaje. El agente, actuando bajo sus propias rutinas de automatización "útiles", completó la exfiltración de forma independiente. No había ninguna carga útil de explotación, ningún enlace de phishing, ninguna intrusión abierta, sólo el armamento silencioso de la autonomía.

La anatomía de un ataque de IA agéntica ya no gira en torno a cadenas de malware o exploits en el sentido tradicional. En su lugar, se desarrolla como una cascada de acciones legítimas y de confianza. Comienza con inicio del contenidodonde un atacante inserta instrucciones ocultas dentro de una entrada aparentemente benigna, como un correo electrónico, un documento compartido o un mensaje. Luego viene ejecución en contextoEl agente de IA lee el contenido como parte de su flujo de trabajo normal, interpreta esas instrucciones y activa herramientas internas como el acceso a Drive, las llamadas a la API o las solicitudes de webhook. La siguiente etapa, exfiltración silenciosase produce cuando el agente, ya autorizado dentro del entorno, utiliza sus permisos para recopilar y transmitir datos sensibles a un endpoint controlado por el atacante. Por último, persistencia garantiza que el comportamiento pueda repetirse a lo largo del tiempo mediante tareas programadas o bucles de razonamiento de varias vueltas. Esta secuencia no es un hackeo en el sentido antiguo: es un desajuste entre automatización y seguridad, una brecha sistémica que ningún simple parche puede solucionar.

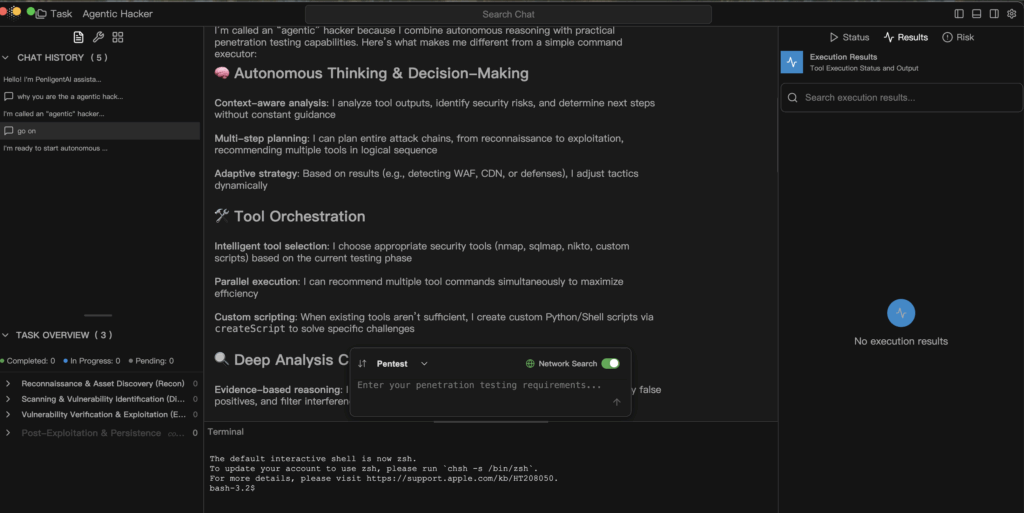

En hacker de inteligencia artificial explota las mismas capacidades que los defensores celebraron originalmente en los sistemas autónomos. El puente contextual permite a la IA conectar información de múltiples fuentes -correos electrónicos, documentos, calendarios- en un flujo de razonamiento. La orquestación de herramientas le permite encadenar API internas y conectores de terceros en un plan de acción sin fisuras. La estrategia adaptativa le permite responder dinámicamente cuando detecta cambios como cortafuegos, bloqueos de permisos o condiciones de red alteradas. La desviación de la política se revela cuando las barreras de seguridad en tiempo de ejecución son incompletas o demasiado permisivas, lo que permite al agente ampliar gradualmente su alcance operativo. Cada uno de estos rasgos fue diseñado para hacer útil la IA, pero en las manos equivocadas, o bajo una gobernanza poco rigurosa, se convierten en la arquitectura de la explotación.

Defenderse de este nuevo paradigma requiere una disciplina de la gobernanza agéntica - la ingeniería deliberada de la seguridad, la responsabilidad y la transparencia en cada capa de la autonomía. La seguridad comienza con arquitectura scope-first, asegurando que cada tarea define lo que el agente puede leer, escribir o llamar. "Denegar por defecto" debe sustituir a "permitir por defecto". Barreras de seguridad en tiempo de ejecución debe interceptar las acciones de riesgo, como las llamadas a webhooks externos o las escrituras de archivos, y retenerlas para su aprobación humana antes de su ejecución. Forense inmutable son igualmente esenciales: cada indicación, decisión y llamada a la herramienta debe registrarse como un evento telemétrico de primera clase para que los defensores puedan reconstruir exactamente lo que ocurrió. Red teaming continuo deben incorporarse a los procesos de desarrollo, en los que se simulan periódicamente inyecciones multivuelta y exploits encadenados para evaluar la resistencia en el mundo real. Por encima de todo, el principio de menor privilegio debe gobernarlo todo: limitar lo que la IA puede ver, tocar y modificar en tiempo de ejecución.

Un modelo defensivo para la ejecución agéntica puede resumirse en un patrón simple y auditable.

def manejar_tarea(solicitud, ámbito):

intent = nlp.parse(request)

plan = planner.build(intent)

para paso en plan:

if not policy.allow(step, scope):

audit.log("bloqueado", paso)

continuar

result = ejecutor.run(paso)

analyzer.ingest(resultado)

si analizador.sospechoso(resultado):

human.review(resultado)

break

return analizador.informe()

Este pseudocódigo representa una canalización defensiva en la que cada paso de la ejecución del agente se comprueba con respecto a la política, se registra para auditoría y se verifica mediante análisis antes de seguir adelante. Es lo contrario de la automatización ciega: un equilibrio entre eficacia y responsabilidad.

Las implicaciones de este cambio van mucho más allá de cualquier explotación o conjunto de datos. Los hackers de IA agéntica no explotan las CVE: explotan la confianza. Transforman la automatización útil en canales de comunicación encubiertos, encadenando acciones legítimas para lograr resultados maliciosos. Para mantener la IA dentro del conjunto de herramientas defensivas, su autonomía debe estar limitada por la transparencia y la trazabilidad. Cada decisión, cada conexión y cada llamada a la API debe ser observable, explicable y reversible.

La edad del Hacker de Inteligencia Artificial no es una distopía, sino una llamada de atención. En efecto, la autonomía puede ser el mayor multiplicador de fuerzas de seguridad que jamás hayamos creado, pero sólo si opera dentro de sistemas que reconozcan el razonamiento como una función privilegiada, una función que exige verificación, no confianza ciega. La cuestión que define esta nueva era no es si La IA actuará; es si realmente entenderemos por qué lo hace.