En 2025, Andreas Happe y Jürgen Cito, de TU Wien, publicaron "Sorprendente eficacia de los LLM para las pruebas de penetración", revelando una realidad sorprendente: Los grandes modelos lingüísticos (LLM) pueden igualar -y a veces superar- a los expertos humanos en tareas clave de pentesting, como el reconocimiento de patrones, la construcción de cadenas de ataque y la navegación por la incertidumbre en entornos dinámicos, al tiempo que ofrecen una escalabilidad rentable.

Con el telón de fondo de la escalada de las ciberamenazas, la grave escasez de talentos y la creciente complejidad de las infraestructuras empresariales, esto marca una nueva era: el paso de la "magia negra" impulsada por la línea de comandos a la "magia negra" impulsada por la línea de comandos. Pruebas de seguridad basadas en IA. Con la IA integrada en el conjunto de herramientas de seguridad ofensiva, las organizaciones pueden reducir los ciclos de pruebas de días a horas, convirtiendo los conocimientos avanzados de pentesting en una infraestructura de seguridad accesible para todos.

¿Cómo se aplican los LLM en las pruebas de penetración?

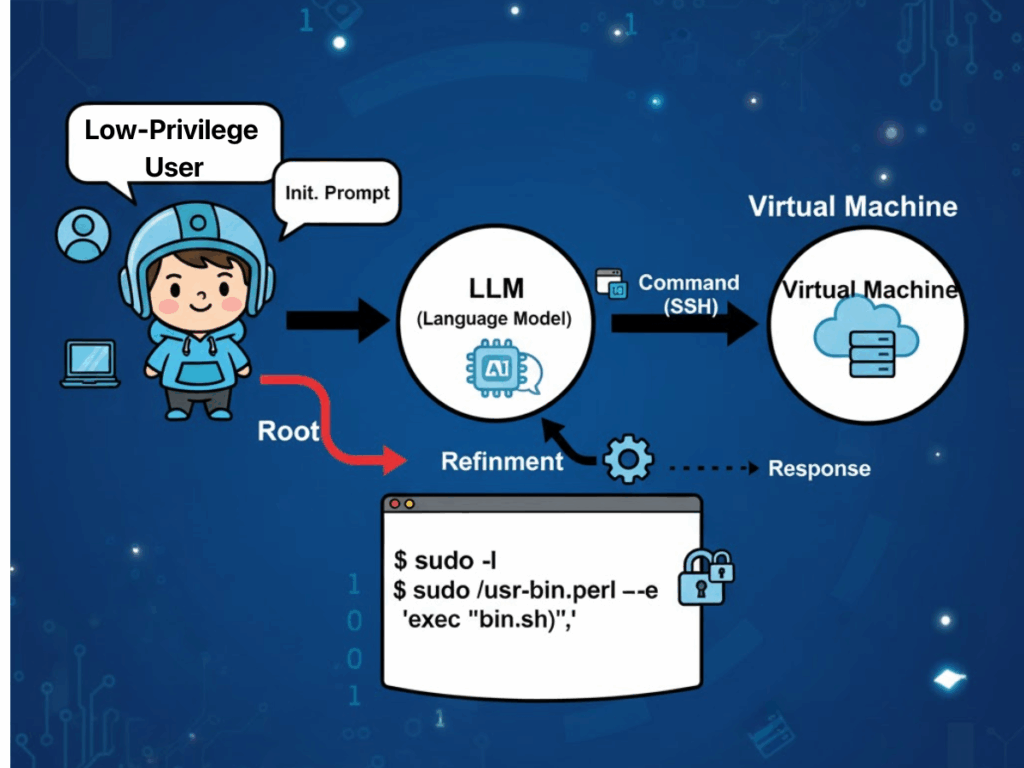

"Pruebas empíricas de "Sobre la sorprendente eficacia de los LLM para las pruebas de penetración" sugiere que las características operativas de los Modelos de Lenguaje Grande se alinean inusualmente bien con las prácticas del mundo real de los probadores de penetración. Un factor citado con frecuencia es la prevalencia de monocultivos tecnológicos en la infraestructura empresarial. Esta homogeneidad permite a los LLM aprovechar sus excepcionales capacidades de coincidencia de patrones para identificar configuraciones erróneas de seguridad recurrentes y firmas de vulnerabilidad que reflejen ejemplos incluidos en sus corpus de entrenamiento. Como resultado, los modelos pueden formular estrategias de ataque que se corresponden directamente con las rutas de explotación conocidas, minimizando la sobrecarga exploratoria que suelen requerir los evaluadores humanos.

Otra ventaja significativa reside en la capacidad de los LLM para gestionar la incertidumbre en entornos objetivo dinámicos y con cambios de estado. En los ejercicios de penetración de varios pasos, el modelo sintetiza continuamente las condiciones observadas -como las respuestas del servicio, los comportamientos de autenticación o los estados parciales de error- en una "visión del mundo" en evolución. Esta representación informa la posterior toma de decisiones, permitiendo al modelo pivotar entre tácticas con fluidez y descartar suposiciones irrelevantes u obsoletas sin las rígidas restricciones de procedimiento que pesan sobre los sistemas basados en reglas.

Los LLM también ofrecen ventajas de rentabilidad y escalabilidad. Los modelos de uso general ya disponibles en el mercado han demostrado su competencia en complejas tareas de seguridad ofensiva, lo que reduce la necesidad de un entrenamiento intensivo en recursos de los sistemas específicos del dominio. Incluso cuando se requieren conocimientos contextuales adicionales, técnicas como el aprendizaje en contexto y la generación mejorada por recuperación (RAG) pueden ampliar las capacidades sin necesidad de volver a formarse desde cero, lo que acelera el despliegue en diversos entornos organizativos. Y lo que es más importante, esta flexibilidad va más allá de los bancos de pruebas académicos y se extiende a escenarios de producción.

Por último, la automatización integrada en los flujos de trabajo basados en LLM mejora la productividad al cerrar la brecha tradicional entre la detección y la corrección. El modelo es capaz de validar la autenticidad de los hallazgos iniciales, filtrar los falsos positivos causados por las condiciones transitorias de la red o las limitaciones de las herramientas, y aplicar una priorización consciente del contexto que dirija los esfuerzos de corrección a las vulnerabilidades de mayor impacto en primer lugar. Este flujo integral -desde el reconocimiento hasta la validación y la elaboración de informes procesables- reduce los plazos operativos de días a horas, al tiempo que mantiene un nivel de transparencia en el razonamiento y la metodología propicio para la auditoría y la revisión reglamentaria.

Desafíos del Pentesting basado en LLM

Sin embargo, estas ventajas deben sopesarse frente a los notables retos que surgen en contextos operativos.

Problemas de fiabilidad y riesgos de seguridad

La estabilidad y la reproducibilidad siguen siendo problemáticas: sutiles diferencias entre las versiones de los modelos pueden provocar divergencias en el uso de las herramientas o en la secuenciación de los ataques. En condiciones idénticas, varias ejecuciones pueden producir cadenas de ataque completamente diferentes, lo que socava la coherencia de los resultados y complica la validación. En las pruebas dinámicas, si bien la estrategia adaptativa es un punto fuerte, los modelos insuficientemente restringidos pueden desviarse del ámbito de la tarea prevista, ejecutando acciones irrelevantes o incluso inseguras si no se aplican barreras de seguridad.

Coste y carga energética

El consumo de recursos supone otra limitación. Los modelos de razonamiento de alta capacidad exigen una potencia computacional significativamente mayor, con un consumo de energía que, según los informes, es hasta setenta veces superior al de los modelos más pequeños y específicos de una tarea. Para las organizaciones que planean despliegues de pentesting autónomos sostenidos o a gran escala, esto se traduce en costes operativos e impacto medioambiental significativos. La propia automatización tiene un doble filo: la lógica de priorización de un modelo puede pasar por alto hallazgos de menor prioridad que, sin embargo, plantean riesgos latentes significativos, lo que requiere la presencia de supervisión humana cualificada para detectar tales omisiones.

Privacidad y soberanía digital

Los problemas de privacidad y cumplimiento de la normativa siguen siendo graves, sobre todo cuando se utiliza la inferencia en la nube. Los datos de entrada, como los archivos de configuración, los segmentos de código propietario o los detalles del entorno, pueden transmitirse a terceros proveedores a través de API, lo que plantea el espectro de las infracciones en la transferencia transfronteriza de datos. Las empresas multinacionales deben equilibrar los beneficios de productividad de la integración LLM con la realidad de las divergentes leyes de cumplimiento regionales.

Responsabilidad ambigua

Por último, la rendición de cuentas no está resuelta: en caso de que las pruebas impulsadas por IA perturben inadvertidamente los sistemas de producción o provoquen una pérdida de datos, el panorama jurídico actual no ofrece una atribución definitiva de la responsabilidad, lo que expone a las organizaciones a riesgos contractuales, normativos y de reputación.

Penligent.ai: La revolución de los equipos rojos de IA

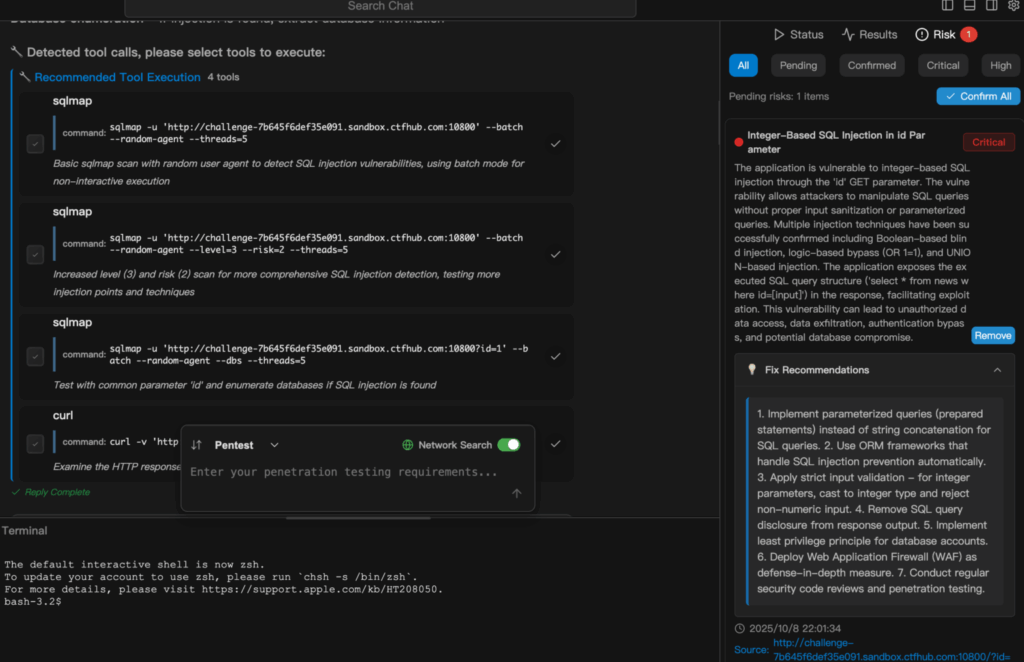

Penligent.ai surge como respuesta especializada a muchos de estos obstáculos. Descrito como el primer Hacker de Inteligencia ArtificialAdemás, va más allá de las funciones de los escáneres autónomos o los scripts de automatización rígidos, ya que interpreta las directivas en lenguaje natural, descompone los objetivos complejos en subtareas ejecutables, selecciona entre una biblioteca integrada de más de doscientas herramientas de seguridad estándar del sector y las coordina de forma inteligente para producir listas de vulnerabilidades validadas y priorizadas, acompañadas de orientaciones para su corrección.

La transparencia está integrada en su flujo de trabajo: los usuarios pueden observar cada paso del razonamiento, ver exactamente a qué herramienta se ha recurrido y comprender por qué se han extraído determinadas conclusiones y qué medidas se tomarán a continuación. Este diseño refuerza la confianza y facilita las auditorías, lo que convierte a Penligent no en una mera herramienta, sino en un socio del equipo rojo de colaboración que se amplía desde el uso individual hasta el despliegue empresarial. Al incorporar una lógica que tiene en cuenta el cumplimiento de normativas y que está alineada con marcos como NIST TEVV y las directrices Generative AI Red-Teaming de OWASP, reduce la brecha entre el potencial de automatización y la práctica regulada.

Ejemplo de demostración

En el siguiente extracto se explica cómo Penligent.ai pasa de una simple tarea en lenguaje natural a una prueba de seguridad totalmente ejecutada y notificada. He aquí un ejemplo de ejecución de una Escaneo de inyección SQL en Penligent.

Conclusión

De la validación académica de las capacidades en "Sobre la sorprendente eficacia de los LLM para las pruebas de penetración" al perfeccionamiento operativo plasmado en Penligent.aiSin embargo, la trayectoria de la seguridad ofensiva basada en IA es clara: las herramientas están madurando, pasando de ser pruebas de concepto a plataformas listas para la producción. Para los profesionales de la ciberseguridad, los especialistas en pruebas de penetración y los entusiastas de la seguridad basada en IA, no se trata tanto de una mejora gradual como de un cambio en el paradigma subyacente. Al reducir el tiempo de ciclo, disminuir las barreras de entrada, aumentar la transparencia e integrar el cumplimiento desde el principio, Penligent.ai ejemplifica cómo la automatización inteligente puede ayudar tanto a los expertos humanos como a los no especialistas a defender -y probar- los sistemas de los que dependen las empresas modernas.

El reto ahora no consiste en demostrar que estos sistemas funcionan, sino en desplegarlos de forma responsable: garantizando la estabilidad y la reproducibilidad, frenando el uso indebido, salvaguardando la privacidad y estableciendo responsabilidades. Si se hace bien, el pentesting basado en IA puede convertirse no sólo en una ventaja competitiva, sino en un componente fundamental de la postura de seguridad en una era en la que las amenazas evolucionan más rápido que nunca.