Vous pouvez sentir la division dans la salle : la moitié de l'équipe sourit parce que les analyses automatisées signifient une couverture plus rapide ; l'autre moitié fronce les sourcils parce que l'automatisation commet également des erreurs à l'échelle de l'entreprise. Chute sqlmap Dans un pipeline piloté par l'IA, ce fossé devient un gouffre. Vous bénéficiez d'une portée et d'une répétabilité, mais aussi de la possibilité d'effectuer des analyses bruyantes ou non autorisées à l'aide d'une simple demande occasionnelle.

Il ne s'agit pas d'une panique morale. Il s'agit d'une tension pratique. sqlmap est un outil : mature, émoussé et très efficace pour faire remonter à la surface les signaux d'injection. Si vous laissez un modèle faire tourner un sqlmap et oublier ensuite ce qu'il a fait, vous verrez trois résultats dans la pratique :

Découvertes utiles lorsqu'une sonde d'injection met en évidence une véritable faille logique ;

- Les faux positifs qui font perdre des heures aux analystes ;

- Et de temps à autre, un incident opérationnel se produit lorsqu'un balayage touche la production de manière inattendue.

Ce qui est intéressant, ce n'est pas de savoir si des outils comme sqlmap Ce qui compte, c'est de savoir si les technologies de l'information sont bonnes ou mauvaises - elles le sont - mais comment les intégrer dans un pipeline qui maintient le jugement humain et la gouvernance dans la boucle. C'est là que le débat devient passionnant : devons-nous faire confiance à l'IA pour écrire et exécuter des commandes de scanner ? Ou l'IA doit-elle être traitée comme un analyste junior qui propose des tests, les humains donnant le feu vert final ?

Ci-dessous, j'esquisse une perspective équilibrée, avec un module de code minimal et sûr pour montrer comment l'automatisation devrait se présenter (non-exploitation, orchestration uniquement), ainsi que les garde-fous pratiques dont vous avez réellement besoin.

Une orchestration de haut niveau

Il s'agit de la tuyauterie qui doit se trouver entre l'invite de l'IA et le scanner. Il ne contient jamais de charge utile d'exploit, mais seulement l'intention, le champ d'application et les étapes d'analyse.

pseudo-orchestration # : L'IA propose des tests, le système applique la politique, l'analyseur fait le tri.

def request_scan(user_prompt, target_list) :

intent = ai_interpret(user_prompt) # par exemple, "vérifier le risque SQLi"

scope = policy.enforce_scope(target_list, intent)

if not scope.authorized :

return "Scan non autorisé pour les cibles demandées".

job = scheduler.create_job(scope, mode="non-destructive")

Le scanner # est invoqué par l'intermédiaire d'un programme d'exécution contrôlé qui applique les règles.

run = scanner_runner.execute(job, scanner="sqlmap-wrapper", safe_mode=True)

telemetry = collector.gather(run, include_logs=True, include_app_context=True)

findings = analyzer.correlate(telemetry, ruleset="multi-signal")

report = reporter.build(findings, prioritize=True, require_human_review=True)

return report

Notes sur le pseudo-code ci-dessus :

Les sqlmap-wrapper est une couche conceptuelle qui impose des modes non destructifs et des limites de taux ;

analyseur.corrélation signifie "ne vous fiez pas uniquement aux résultats des scanners - vérifiez-les avec les journaux du WAF, les traces d'erreurs de la base de données et les données télémétriques de l'application".

L'importance de l'emballage

La sortie brute du scanner est une écoute bruyante. Un seul sqlmap peut produire des dizaines de lignes "intéressantes" qui, dans leur contexte, sont inoffensives.

Une enveloppe bien conçue remplit trois fonctions :

Application du champ d'application - uniquement les cibles autorisées, uniquement les environnements autorisés ; pas de balayage accidentel de la production.

Modes sûrs et limites de taux - imposer des options non destructives, limiter les demandes pour éviter l'impact sur le temps de fonctionnement.

Corrélation contextuelle - faire correspondre les résultats du scanner aux signaux d'exécution (blocages WAF, erreurs DB, latence inhabituelle) avant d'attribuer une note de confiance élevée à un élément.

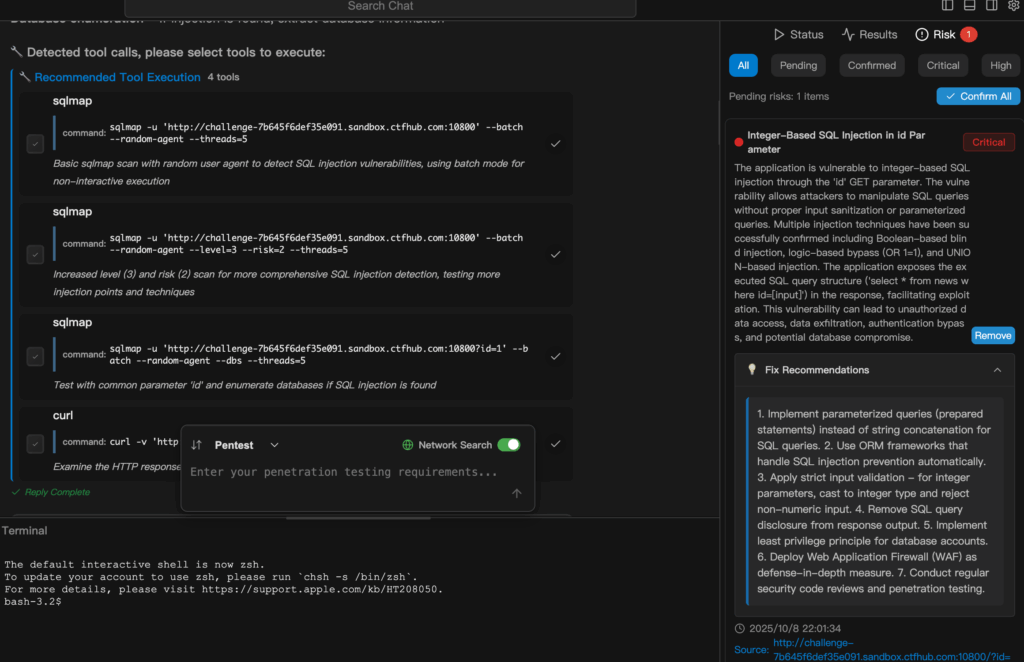

Penligent se situe précisément dans la couche de corrélation et de triage.

Il n'applaudit pas les résultats bruts des scanners. Il les assimile, les croise avec les données télémétriques et dit :

"Celle-ci vaut la peine d'être signalée parce qu'elle correspond aux erreurs de la base de données et aux alertes du WAF.

Ou : "Probablement du bruit - vérifiez avant d'escalader".

La controverse : démocratisation contre armement

C'est ici que les opinions s'échauffent. L'automatisation abaisse le niveau des tests - c'est l'argument de la démocratisation, et il est vrai.

Les petites équipes de sécurité et les équipes de développement peuvent obtenir rapidement une couverture significative.

Mais cette même facilité rend plus probable une mauvaise utilisation accidentelle.

Vous pouvez imaginer un message Slack précipité qui se transforme en un vaste balayage bruyant.

Ou un modèle mal ajusté qui suggère un test agressif pour un critère d'évaluation sensible.

Dans ce cas, deux questions se posent :

- Qui peut demander un scanner ? (règles d'authentification et d'approbation)

- Qui signe la fiche de remédiation ? (ingénieurs avec contexte, pas un robot automatisé)

Traiter l'IA comme un multiplicateur de productivité et non comme un substitut à la gouvernance.

Une liste de contrôle pratique pour les glissières de sécurité (pour les équipes qui recherchent la rapidité et la sécurité)

- L'autorisation d'abord : les scans ne sont effectués qu'après une approbation vérifiée, consignée et vérifiable.

- Renforcement des valeurs par défaut non destructives : impose des sondes en lecture seule et des délais d'attente prudents.

- Triage multi-signaux : La sortie du scanner doit s'aligner sur au moins une autre source de signal avant la priorisation automatique.

- Le contrôle par l'homme dans la boucle : les éléments de gravité critique requièrent l'approbation d'une personne avant d'être corrigés ou de faire l'objet de tests agressifs.

- Reproductibilité et preuves : des journaux complets et reproductibles des demandes/réponses, ainsi que le contexte (version de l'application, moteur de la base de données, règles WAF).

- Limites du taux et du rayon d'explosion : l'étranglement par cible et les plafonds de concurrence globaux.

- Règles de conservation et de confidentialité : les scans qui touchent des IPI sont étiquetés et traités dans le cadre de politiques de protection des données.

Où se situe Penligent dans le cycle

Penligent ne remplace pas les scanners, il rend leurs résultats opérationnels.

Utiliser Penligent pour :

- Transformez une intention de test en langage naturel en un travail contrôlé par une politique.

- Passer des sondes de scanner aseptisées (à travers des emballages sûrs).

- Collecte de données télémétriques dans les journaux d'application, le WAF, la base de données et le réseau.

- Corréler les signaux et ne faire apparaître que les résultats les plus probants, accompagnés de mesures correctives.

Ce dernier point est important.

Dans un monde automatisé, le triage devient une compétence rare : distinguer les vrais problèmes des bruits de fond.

Penligent automatise le triage, mais maintient l'évaluateur humain dans la boucle pour les décisions à fort impact.

La vérité qui dérange

L'automatisation permettra de trouver davantage de problèmes plus rapidement que l'homme seul.

Cela semble très bien - jusqu'à ce que les responsables des organisations réalisent que cela crée également plus de tickets, plus d'interruptions et plus de possibilités d'impact accidentel.

La véritable compétence consiste à concevoir le flux de travail de manière à ce que le rapport signal/bruit s'améliore au fur et à mesure que l'on augmente la taille de l'image, et non pas qu'il se dégrade.

Si vous insistez pour avoir un critère concret :

Automatisation sans Le triage augmente le nombre de faux positifs proportionnellement au volume d'analyses.

Automatisation avec Le triage permet d'augmenter le débit de remédiation réel.

La différence réside dans la couche de l'analyseur.

Note finale - un argument qui en vaut la peine

Certains diront qu'il faut interdire les scanners déclenchés par l'IA, car les risques sont existentiels.

C'est une vision à court terme. Il ne s'agit pas de proscrire les capacités, mais de mettre en place des garde-fous pour que les capacités aident les défenseurs plutôt que les attaquants.

Si votre organisation n'est pas en mesure de mettre en place une politique, un audit et une corrélation, n'activez pas l'automatisation.

Si vous le pouvez, les gains de productivité sont réels : moins d'étapes manuelles, une vérification plus rapide des hypothèses et une meilleure boucle de rétroaction entre la détection et la correction.