Introduction

Dans le contexte de la cybersécurité, Outils de piratage désignent les divers instruments techniques utilisés pour identifier, tester et valider le niveau de sécurité des systèmes. Ils ne sont pas synonymes de "logiciels de piratage", mais constituent plutôt des éléments essentiels de la sécurité des systèmes. tests de pénétrationCes outils permettent d'effectuer des recherches sur le terrain, de valider les vulnérabilités et d'évaluer les flux de travail en matière de sécurité. Du balayage de ports de Nmap au cadre d'exploitation de Metasploit, en passant par l'interception du trafic de Burp Suite, ces outils constituent l'épine dorsale opérationnelle de la sécurité offensive et défensive moderne.

Malgré l'essor de l'automatisation et de l'IA, la valeur des Outils de piratage reste inchangée. Ils incarnent la "forme exécutable" des connaissances en matière de sécurité, en ancrant les praticiens dans la validation empirique des limites du système et des surfaces d'attaque. En fait, les systèmes de sécurité intelligents du futur seront construits à partir de ces outils, où l'orchestration et la compréhension sémantique transforment la "magie noire" de la ligne de commande en une intelligence de sécurité explicable et pilotée par des agents.

Pourquoi les outils de piratage sont-ils importants ?

Dans le cadre des opérations de sécurité, les outils de piratage font le lien entre la théorie et la pratique. Les experts s'appuient sur eux pour valider des hypothèses, reproduire des attaques et découvrir des zones d'ombre. Le raisonnement basé sur l'IA dépend des données empiriques générées par ces outils, tandis que l'automatisation défensive s'appuie sur leur retour d'information pour optimiser les stratégies de protection.

Leur importance réside dans trois dimensions :

- Couche de connaissances sur l'exécution - Les théories de la sécurité n'acquièrent de la valeur que lorsqu'elles sont mises en œuvre au moyen d'outils.

- Cadre de référence pour la défense - Les outils définissent les limites offensives que les défenseurs doivent comprendre et imiter.

- Terrain d'entraînement pour la sécurité de l'IA - Les agents d'IA "comprennent le risque" parce que leur sémantique est fondée sur des données empiriques générées par l'outil.

Classification et capacités des outils de piratage

La classification des outils de piratage reflète l'ensemble du cycle de vie de l'ingénierie de la sécurité, de la reconnaissance et du balayage à l'exploitation et à l'établissement de rapports.

| Catégorie | Fonction principale | Traits de capacité | Exemples d'outils |

|---|---|---|---|

| Reconnaissance | Dénombrement des domaines, identification des hôtes, analyse des ports, détection des empreintes de services | Balayage de haute précision, corrélation passive des données, détection à faible bruit | Nmap, Shodan, Recon-ng |

| Exploitation | Identifier et exploiter les vulnérabilités connues pour obtenir un accès initial | Gestion automatisée de la charge utile, attaque programmée chaînes | Metasploit, ExploitDB, SQLmap |

| L'escalade des privilèges | Élever des comptes à faibles privilèges au niveau d'administrateur système | Exploitation du noyau, collecte d'informations d'identification, scripts locaux d'élévation des privilèges | Mimikatz, LinPEAS, WinPEAS |

| Persistance et évasion | Maintenir l'accès aux systèmes cibles et échapper à la détection | Injection de rootkits, obscurcissement des processus, contournement des antivirus | Cobalt Strike, Empire, Veil |

| Post-exploitation | Collecte de données, mouvements latéraux, évasion judiciaire | Modules de mouvement latéral, conditionnement des données et exfiltration cryptée | BloodHound, PowerView, SharpHound |

| Évaluation et défense | Détecter les vulnérabilités, mener des exercices défensifs, analyser les journaux. | Simulation d'attaque et de défense, détection assistée par l'IA, analyse visuelle | Burp Suite, Nessus, OWASP ZAP |

L'ingénierie en pratique : Opérationnaliser les outils de piratage

Les objectifs de l'opérationnalisation sont simples : rendre chaque scan et chaque exploitation reproductibles, contrôlables et évolutifs. Les pratiques courantes sont les suivantes :

- Contrats de production: définir des sorties structurées (JSON / SARIF / schéma personnalisé) qui incluent des paramètres, des versions et des horodatages.

- Exécution conteneurisée: intégrer des outils dans des images de conteneurs pour épingler les environnements et les dépôts.

- Microservice et bus de messagesLes outils sont enveloppés en tant que services ou travaux invocables à distance et enchaînés via des files d'attente (Kafka/RabbitMQ) pour l'extensibilité et les nouvelles tentatives.

- Intégration CI/CD: incorporez les analyses dans les pipelines avec une profondeur échelonnée (avant la fusion, la nuit, à la demande).

- Preuves et pistes d'auditLes données de la commande, des paramètres, de la sortie stdout/stderr, du code de sortie, des informations sur l'hôte et des versions de l'image sont capturées dans un ensemble de preuves pouvant être contrôlées.

Numérisation parallèle et normalisation des sorties

Vous trouverez ci-dessous un modèle de script Python pragmatique qui démontre l'appel de plusieurs outils en parallèle (en utilisant Nmap et Nuclei comme exemples), en enveloppant les métadonnées d'exécution et en produisant un JSON unifié. En production, il est recommandé d'invoquer chaque outil en tant que tâche conteneurisée ou microservice ; cet exemple est une preuve de concept.

# ops_runner.py - POC : exécution parallèle + sortie JSON normalisée

import subprocess, json, time, concurrent.futures, os, shlex

TARGETS = ["10.0.0.5", "10.0.0.7"]

RESULT_DIR = "./out"

os.makedirs(RESULT_DIR, exist_ok=True)

def run_cmd(cmd) :

meta = {"cmd" : cmd, "started_at" : time.time(), "host" : os.uname().nodename}

try :

# utilise shlex.split si cmd est une chaîne, ici nous passons une liste par sécurité

proc = subprocess.run(cmd, stdout=subprocess.PIPE, stderr=subprocess.PIPE, timeout=300, text=True)

meta.update({

"rc" : proc.returncode,

"stdout" : proc.stdout,

"stderr" : proc.stderr,

"duration" : time.time() - meta["started_at"]

})

except Exception as e :

meta.update({"rc" : -1, "stdout" : "", "stderr" : str(e), "duration" : time.time() - meta["start_at"]})

return meta

def scan_target(target) :

nmap_cmd = ["nmap", "-sV", "-p-", target, "-oX", "-"] # sample : XML brut vers stdout

nuclei_cmd = ["nuclei", "-u", f "http://{target}", "-silent", "-json"]

res = {"target" : cible, "runs" : {}}

res["runs"]["nmap"] = run_cmd(nmap_cmd)

res["runs"]["nuclei"] = run_cmd(nuclei_cmd)

return res

def main() :

out = {"generated_at" : time.time(), "results" : {}}

avec concurrent.futures.ThreadPoolExecutor(max_workers=4) as ex :

futures = {ex.submit(scan_target, t) : t for t in TARGETS}

for fut in concurrent.futures.as_completed(futures) :

t = futures[fut]

out["results"][t] = fut.result()

with open(f"{RESULT_DIR}/scan_results.json", "w") as fh :

json.dump(out, fh, indent=2)

if __name__ == "__main__" :

main()

Notes clés

- Chaque invocation renvoie des métadonnées d'exécution complètes (cmd, heure de début, durée, rc, stdout/stderr).

- En production, analyser le stdout en champs structurés (par exemple, Nuclei JSON) et l'intégrer dans un index pour l'agrégation.

- Pour les exécutions en conteneur, utilisez

docker runou Kubernetes Jobs pour le versionnage, le contrôle de la concurrence et l'isolation.

Intégrer les analyses dans CI/CD

Principaux points pratiques :

- Stratégie de balayage à plusieurs niveaux: Utiliser des sondes légères (balayages de ports/modèles de base) pour la pré-fusion ; exécuter des modèles profonds et une validation lors de la fusion/principale ou des constructions nocturnes.

- Déclencheurs conditionnels: Ne déclencher des analyses approfondies que lorsque les modifications touchent des "services publics" ou des fichiers IaC spécifiques.

- Politique d'échec: Bloquer les déploiements en cas d'échec de vérification à haut risque ; pour les résultats à faible risque, créer un ticket et autoriser la poursuite du déploiement.

- Archivage des preuves: Télécharger les résultats de chaque exécution de l'IC vers le stockage centralisé et les lier à l'identifiant de l'exécution.

Exemple (pseudo-configuration des actions GitHub) :

nom : Scans de sécurité

on :

push :

branches : [main]

jobs :

quick-scan :

fonctionne sur : ubuntu-latest

étapes :

- utilise : actions/checkout@v3

- name : Quick Recon

run : docker run --rm my-registry/nmap:latest nmap -sS $TARGET -oX - > recon.xml

- name : Résultats du téléchargement

run : python3 upload_results.py recon.xml --job-id $GITHUB_RUN_ID

Conseils

- Les scanners d'étape permettent de gérer les coûts et le bruit.

- Utiliser la détection des changements pour déclencher des analyses plus approfondies uniquement lorsque cela s'avère pertinent.

- Archiver les preuves à l'aide d'identifiants de travail pour assurer la traçabilité.

Conteneurisation, microservices et bus de messages

L'encapsulation des outils sous forme d'images de conteneurs ou de microservices permet d'obtenir des environnements contrôlables, une traçabilité des versions et une mise à l'échelle. Publier les résultats sur un bus de messages (Kafka/RabbitMQ) afin que les analyseurs, les agents d'intelligence artificielle ou les SIEM puissent consommer, agréger et calculer les priorités de manière asynchrone.

Déroulement de l'événement :

Le planificateur déclenche le travail du conteneur → L'outil s'exécute et émet une sortie structurée → Résultat poussé vers Kafka → Le consommateur d'analyse (moteur d'IA/de règles) ingère et produit un rapport validé → Rapport écrit en retour et déclenche des alertes/tickets.

Ensembles de preuves et auditabilité

Chaque tâche de détection/exploitation devrait produire un ensemble de preuves (cmd, paramètres, hachage d'image, stdout, pcap, horodatage, nœud d'exécution). Les paquets doivent pouvoir être récupérés, téléchargés et liés à des tickets pour la remédiation et la conformité.

Penligent : Pentesting intelligent avec plus de 200 outils de piratage

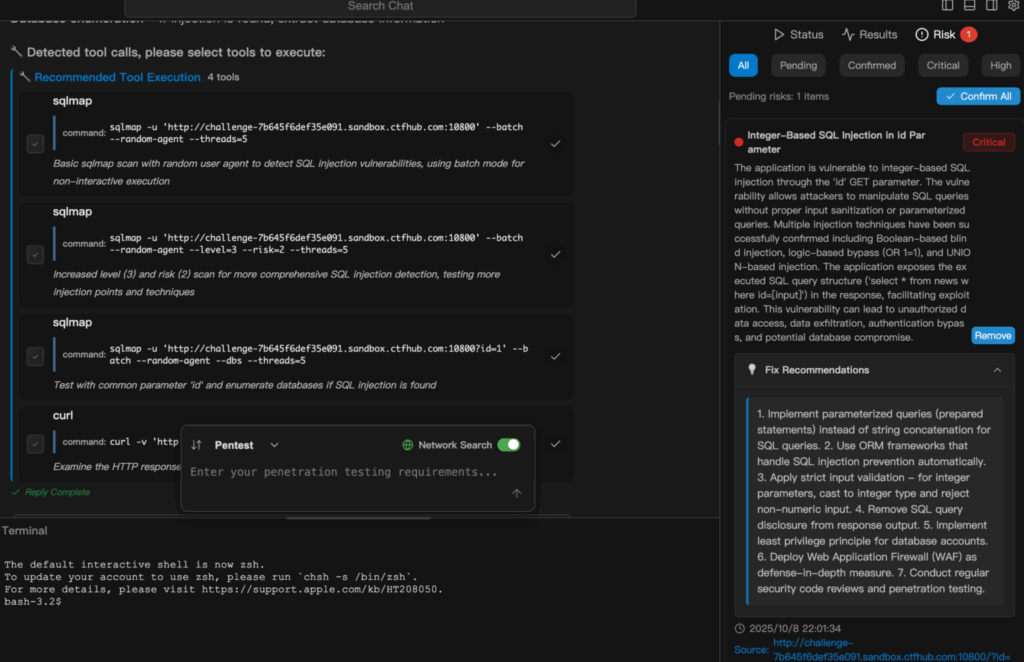

L'étape suivante après l'ingénierie est l'"orchestration intelligente", c'est-à-dire l'utilisation d'agents pour enchaîner les outils, prendre des décisions et produire des résultats vérifiables. Penligent illustre cette évolution : il convertit les entrées en langage naturel en séquences d'action, sélectionne et exécute automatiquement les outils appropriés, vérifie les résultats et génère des rapports exportables. Principaux éléments techniques : analyse de l'intention, stratégie de sélection des outils, boucle de vérification et pistes d'audit.

Scénario (test d'une application cloud-native)

Le commandement est donné : "Vérifier ce sous-domaine pour l'injection SQL et l'exposition des conteneurs".Le système décompose la tâche : découverte des actifs → identification des terminaux web → analyse des modèles → vérification des résultats suspects → empreinte de l'hôte/du conteneur. Chaque invocation d'outil, chaque paramètre, chaque journal d'exécution et chaque résultat probant sont enregistrés ; le résultat final est une liste de mesures correctives classées par ordre de priorité, avec confiance et impact. Pour les ingénieurs, cela permet d'éviter le travail répétitif tout en préservant les détails techniques reproductibles.

Scénario (CI/CD d'entreprise)

Penligent peut être intégré dans CI/CD : lorsque des changements d'infrastructure ou de code déclenchent des scans, la plateforme exécute des modèles ciblés et des vérifications, pousse les résultats prioritaires vers des systèmes de ticketing ou des pipelines de remédiation, transformant le pentesting d'un événement hors ligne en une boucle de rétroaction continue.

Conclusion

Les outils de piratage ne sont pas de simples instruments : ils constituent le "système d'exploitation" des connaissances en matière d'ingénierie de la sécurité. Lorsqu'ils sont systématiquement intégrés et intelligemment orchestrés, les tests de sécurité passent d'une pratique artisanale à un processus scientifique reproductible. Penligent marque le début de cette transformation - où les outils forment le squelette et l'intelligence devient l'âme de la cybersécurité moderne.