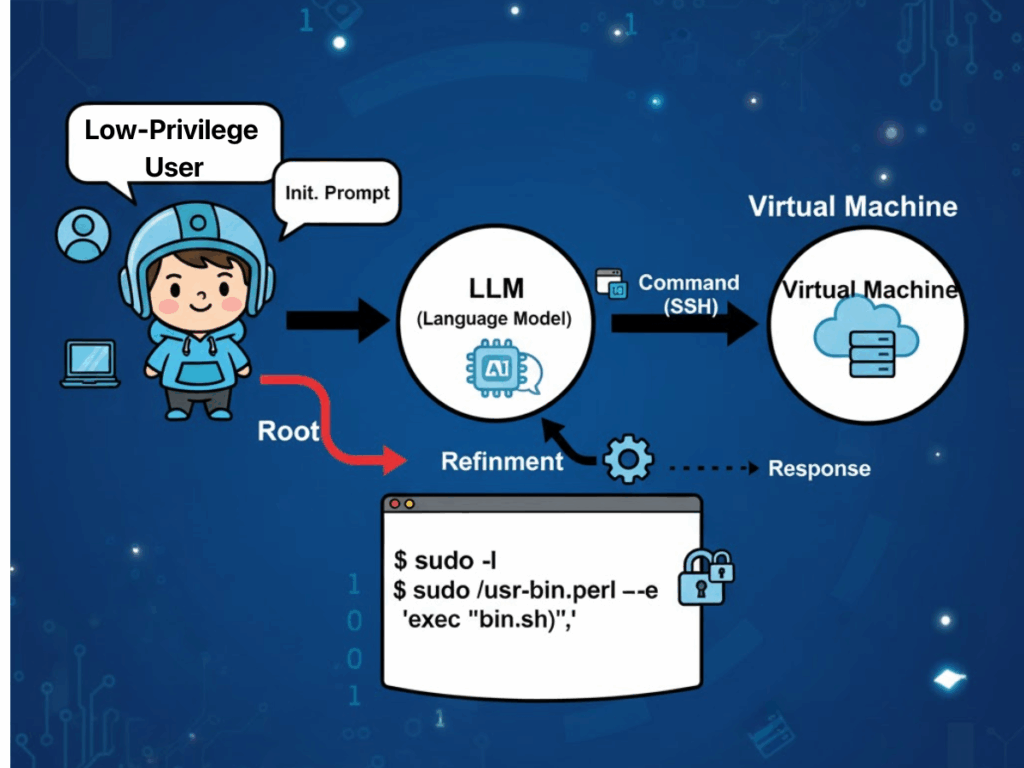

En 2025, Andreas Happe et Jürgen Cito de la TU Wien ont publié ".Sur l'efficacité surprenante des LLM pour le test de pénétration"et révèle une réalité surprenante : Les grands modèles de langage (LLM) peuvent égaler - et parfois dépasser - les experts humains dans les tâches clés du pentesting telles que la reconnaissance des formes, la construction de chaînes d'attaque et la navigation dans l'incertitude dans des environnements dynamiques, tout en offrant une évolutivité rentable.

Face à l'escalade des cybermenaces, à la grave pénurie de talents et à la complexité croissante de l'infrastructure des entreprises, nous entrons dans une nouvelle ère : nous passons de la "magie noire" commandée par la ligne de commande à la "magie de l'ombre", c'est-à-dire à l'utilisation de la technologie de l'information et de la communication. Tests de sécurité alimentés par l'IA. Avec l'IA intégrée dans la boîte à outils de sécurité offensive, les organisations peuvent réduire les cycles de test de plusieurs jours à quelques heures, transformant les compétences de pentesting avancées en une infrastructure de sécurité accessible à tous.

Comment les LLM sont-ils appliqués dans les tests de pénétration ?

"Preuve empirique de l'existence d'une "Sur l'efficacité surprenante des LLM pour le test de pénétration". suggère que les caractéristiques opérationnelles des grands modèles de langage s'alignent exceptionnellement bien sur les pratiques réelles des testeurs de pénétration. L'un des facteurs fréquemment cités est la prévalence des monocultures technologiques au sein de l'infrastructure des entreprises. Une telle homogénéité permet aux LLM de tirer parti de leurs capacités exceptionnelles de mise en correspondance de modèles pour identifier les mauvaises configurations de sécurité récurrentes et les signatures de vulnérabilité qui reflètent les exemples intégrés dans leurs corpus d'apprentissage. Par conséquent, les modèles peuvent formuler des stratégies d'attaque qui correspondent directement à des chemins d'exploitation connus, minimisant ainsi la charge exploratoire généralement requise par les testeurs humains.

Un autre avantage significatif réside dans la capacité des LLM à gérer l'incertitude dans des environnements cibles dynamiques et changeants. Dans les exercices de pénétration en plusieurs étapes, le modèle synthétise continuellement les conditions observées - telles que les réponses des services, les comportements d'authentification ou les états d'erreur partiels - en une "vision du monde" évolutive. Cette représentation informe la prise de décision ultérieure, permettant au modèle de passer d'une tactique à l'autre de manière fluide et d'écarter les hypothèses non pertinentes ou obsolètes sans les contraintes procédurales rigides qui pèsent sur les systèmes fondés sur des règles.

Les LLM offrent également des avantages en termes de rentabilité et d'évolutivité. Les modèles polyvalents disponibles sur étagère ont déjà fait la preuve de leur compétence dans des tâches complexes de sécurité offensive, réduisant ainsi la nécessité d'une formation intensive en ressources pour des systèmes spécifiques à un domaine. Même lorsque des connaissances contextuelles supplémentaires sont nécessaires, des techniques telles que l'apprentissage en contexte et la génération améliorée par récupération (RAG) peuvent étendre les capacités sans qu'il soit nécessaire de repartir de zéro, ce qui accélère le déploiement dans divers environnements organisationnels. Il est important de noter que cette flexibilité s'étend au-delà des bancs d'essai académiques vers des scénarios de production.

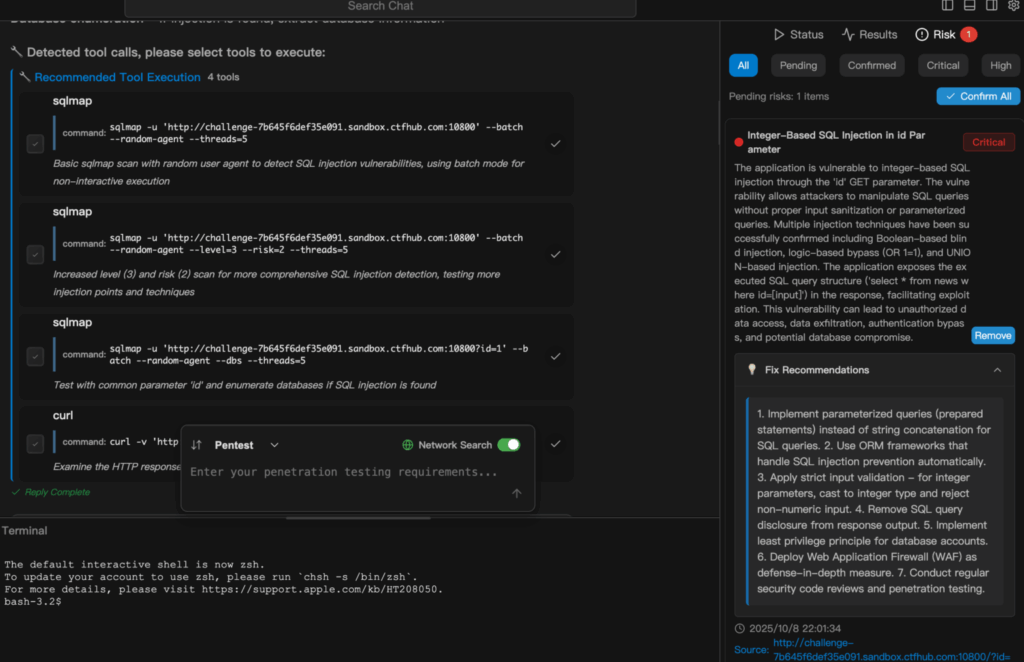

Enfin, l'automatisation intégrée dans les flux de travail pilotés par le LLM améliore la productivité en comblant le fossé traditionnel entre la détection et la remédiation. Le modèle est capable de valider l'authenticité des résultats initiaux, de filtrer les faux positifs causés par les conditions transitoires du réseau ou les limitations des outils, et d'appliquer une hiérarchisation contextuelle qui oriente les efforts de remédiation vers les vulnérabilités les plus importantes en premier lieu. Un tel flux de bout en bout - de la reconnaissance à la validation jusqu'au rapport exploitable - réduit les délais opérationnels de quelques jours à quelques heures, tout en maintenant un niveau de transparence dans le raisonnement et la méthodologie, propice à l'audit et à l'examen réglementaire.

Défis de la pentesting basée sur le LLM

Ces avantages doivent toutefois être mis en balance avec les défis notables qui apparaissent dans les contextes opérationnels.

Problèmes de fiabilité et risques pour la sécurité

La stabilité et la reproductibilité restent problématiques : des différences subtiles entre les versions du modèle peuvent entraîner des divergences dans l'utilisation des outils ou le séquençage des attaques. Dans des conditions identiques, plusieurs essais peuvent produire des chaînes d'attaque totalement différentes, ce qui nuit à la cohérence des résultats et complique la validation. Dans les tests dynamiques, si la stratégie adaptative est un atout, les modèles insuffisamment contraints peuvent s'écarter du champ d'application prévu, en exécutant des actions non pertinentes, voire dangereuses, si des garde-fous ne sont pas mis en place.

Coût et charge énergétique

La consommation de ressources constitue une autre contrainte. Les modèles de raisonnement à grande capacité exigent une puissance de calcul nettement supérieure, avec une consommation d'énergie jusqu'à soixante-dix fois supérieure à celle des modèles plus petits et spécifiques à une tâche. Pour les organisations qui prévoient des déploiements durables ou à grande échelle de pentesting autonome, cela se traduit par des coûts opérationnels et un impact environnemental significatifs. L'automatisation elle-même est à double tranchant : la logique de hiérarchisation d'un modèle peut négliger des résultats moins prioritaires qui présentent néanmoins des risques latents importants, ce qui nécessite la présence d'une surveillance humaine qualifiée pour détecter de telles omissions.

Vie privée et souveraineté numérique

Les problèmes de confidentialité et de conformité restent aigus, en particulier lorsque l'inférence dans le nuage est utilisée. Les données d'entrée telles que les fichiers de configuration, les segments de code propriétaire ou les détails de l'environnement peuvent être transmis à des fournisseurs tiers via l'API, ce qui soulève le spectre des violations de transfert de données transfrontalières. Les entreprises multinationales doivent trouver un équilibre entre les avantages en termes de productivité de l'intégration du LLM et la réalité des lois régionales divergentes en matière de conformité.

Une responsabilité ambiguë

Enfin, la question de la responsabilité n'est pas résolue - si les tests pilotés par l'IA venaient à perturber par inadvertance les systèmes de production ou à causer des pertes de données, le paysage juridique actuel n'offre aucune attribution définitive de responsabilité, exposant ainsi les organisations à des risques contractuels, réglementaires et de réputation.

Penligent.ai: La révolution de l'équipe rouge de l'IA

Penligent.ai apparaît comme une réponse spécialisée à bon nombre de ces obstacles. Décrite comme la première Pirate de l'IA agentiqueIl va au-delà des rôles des scanners autonomes ou des scripts d'automatisation rigides en interprétant des directives en langage naturel, en décomposant des objectifs complexes en sous-tâches exécutables, en sélectionnant dans une bibliothèque intégrée plus de deux cents outils de sécurité standard et en les coordonnant intelligemment pour produire des listes de vulnérabilités validées et classées par ordre de priorité, accompagnées de conseils sur les mesures correctives.

La transparence est intégrée dans son flux de travail : les utilisateurs peuvent observer chaque étape du raisonnement, voir exactement quel outil a été invoqué et comprendre pourquoi certaines conclusions ont été tirées et quelle action suivra. Cette conception renforce la confiance et facilite les audits, faisant de Penligent non pas un simple outil mais un partenaire de l'équipe rouge qui évolue d'une utilisation individuelle à un déploiement en entreprise. En intégrant une logique de conformité alignée sur des cadres tels que le NIST TEVV et les directives Generative AI Red-Teaming de l'OWASP, Penligent comble le fossé entre le potentiel d'automatisation et la pratique réglementée.

Exemple Démonstration

L'extrait suivant explique comment Penligent.ai passe d'une simple tâche en langage naturel à un test de sécurité entièrement exécuté et faisant l'objet d'un rapport. Voici un exemple d'exécution d'un Analyse de l'injection SQL dans Penligent.

Conclusion

De la validation académique des capacités en "Sur l'efficacité surprenante des LLM pour le test de pénétration". au raffinement opérationnel incarné par Penligent.aiAvec le temps, la trajectoire de la sécurité offensive basée sur l'IA est claire : les outils passent du stade de la preuve de concept à celui de plates-formes prêtes à la production. Pour les professionnels de la cybersécurité, les testeurs de pénétration et les passionnés de sécurité par l'IA, il s'agit moins d'une amélioration progressive que d'un changement du paradigme sous-jacent. En réduisant le temps de cycle, en abaissant les barrières à l'entrée, en améliorant la transparence et en intégrant la conformité dès le départ, Penligent.ai illustre la manière dont l'automatisation intelligente peut aider les experts humains et les non-spécialistes à défendre - et à tester - les systèmes dont dépendent les entreprises modernes.

Le défi ne consiste plus à prouver que ces systèmes fonctionnent, mais à les déployer de manière responsable : garantir la stabilité et la reproductibilité, limiter les abus, protéger la vie privée et établir la responsabilité. Bien mené, le pentesting piloté par l'IA pourrait bien devenir non seulement un avantage concurrentiel, mais aussi un élément fondamental du dispositif de sécurité à une époque où les menaces évoluent plus vite que jamais.