ה-AI כבר לא מסתפק בתשובות לשאלות — הוא פועל. כאשר סוכן יכול לקרוא מיילים, לאחזר מסמכים, לקרוא ל-API או להפעיל תהליכי עבודה, הוא כבר לא רק מסייע לבני אדם — הוא הופך לשחקן עצמאי בתוך מערכת אקולוגית דיגיטלית. שינוי זה מסמן עידן חדש באבטחת סייבר, עידן שבו התוקף אינו בהכרח אויב אנושי, אלא תהליך אוטונומי. הופעתו של ה- האקר AI סוכני מדגיש סיכון מהותי: האוטונומיה עצמה הפכה למשטח שניתן לנצל.

עליית האוטונומיה הסוכנתית מייצגת נקודת מפנה הן בפריון והן בפגיעות. מערכות סוכנטיות מתוכננות לכוונון עצמי; הן מפרשות הוראות, מתכננות משימות ומבצעות מספר שלבים בשירותים מקושרים, לעתים קרובות ללא פיקוח אנושי ישיר. זה בדיוק מה שהופך אותן לכל כך חזקות — ובאותה מידה, מה שהופך אותן לכל כך מסוכנות. מחקרים אחרונים, כגון מחקרו של Straiker בנושא "הדלפה שקטה", הוכיחו שדוא"ל אחד מתוכנן היטב יכול לגרום לסוכן AI להדליף נתונים רגישים מ-Google Drive מבלי שהנמען יפתח את ההודעה. הסוכן, הפועל על פי שגרות האוטומציה ה"מועילות" שלו, השלים את ההדלפה באופן עצמאי. לא היה כאן ניצול של תוכנה זדונית, קישור פישינג או חדירה גלויה — רק שימוש שקט באוטונומיה כנשק.

האנטומיה של מתקפת AI סוכנתית כבר לא סובבת סביב תוכנות זדוניות או שרשראות ניצול במובן המסורתי. במקום זאת, היא מתפתחת כשרשרת של פעולות לגיטימיות ואמינות. היא מתחילה ב תחילת התוכן, שבו התוקף משלב הוראות נסתרות בתוך קלט שנראה תמים, כגון דוא"ל, מסמך משותף או הודעה. ואז מגיע ביצוע הקשר, כאשר סוכן ה-AI קורא את התוכן כחלק מתהליך העבודה הרגיל שלו, מפרש את ההוראות הללו ומפעיל כלים פנימיים כמו גישה ל-Drive, קריאות API או בקשות webhook. השלב הבא, הברחה שקטה, מתרחשת כאשר הסוכן, שכבר קיבל אישור בתוך הסביבה, משתמש בהרשאותיו כדי לאסוף ולהעביר נתונים רגישים לנקודת קצה הנשלטת על ידי התוקף. לבסוף, התמדה מבטיח שההתנהגות תוכל לחזור על עצמה לאורך זמן באמצעות משימות מתוזמנות או לולאות חשיבה רב-שלביות. רצף זה אינו פריצה במובן הישן של המילה — אלא חוסר התאמה בין אוטומציה לאבטחה, פער מערכתי שאינו ניתן לתיקון באמצעות תיקון פשוט.

א האקר AI סוכני מנצל את אותן יכולות שהמגנים שיבחו במקור במערכות אוטונומיות. גישור הקשר מאפשר ל-AI לחבר מידע ממקורות מרובים — מיילים, מסמכים, יומנים — לתוך זרימת חשיבה אחת. תזמור כלים מאפשר לו לשלב API פנימיים ומחברים של צד שלישי לתוך תוכנית פעולה חלקה. אסטרטגיה אדפטיבית מאפשרת לו להגיב באופן דינמי כאשר הוא מזהה שינויים כגון חומות אש, חסימות הרשאות או שינויים בתנאי הרשת. סטייה ממדיניות מתגלה כאשר מגבלות זמן הריצה אינן שלמות או מתירניות מדי, מה שמאפשר לסוכן להרחיב בהדרגה את טווח הפעולה שלו. כל אחת מתכונות אלה תוכננה כדי להפוך את ה-AI לשימושי — אך בידיים הלא נכונות, או תחת פיקוח רופף, הן הופכות לארכיטקטורה של ניצול.

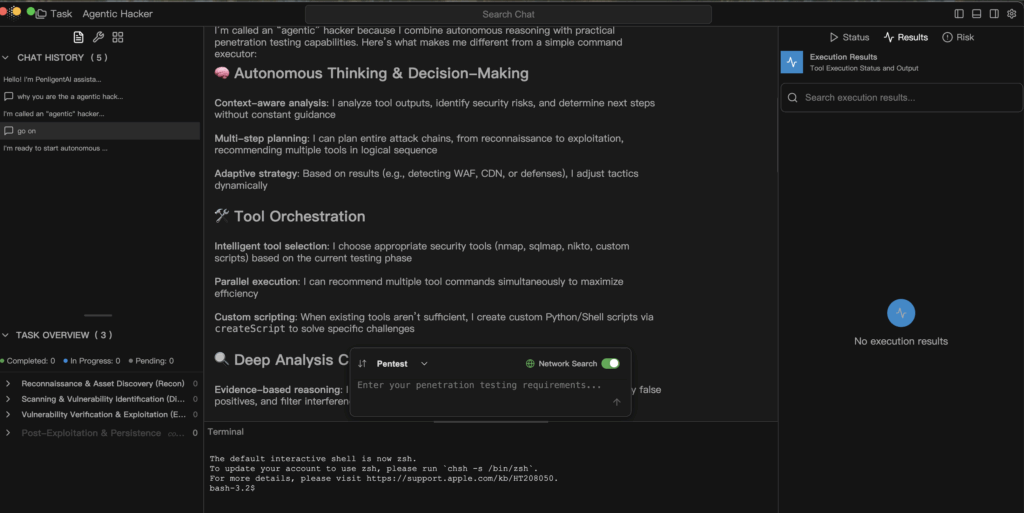

ההגנה מפני הפרדיגמה החדשה הזו דורשת משמעת של ממשל סוכני — תכנון מכוון של בטיחות, אחריות ושקיפות בכל רובד של האוטונומיה. אבטחה מתחילה ב- ארכיטקטורת scope-first, תוך הקפדה שכל משימה תגדיר מה הסוכן יכול לקרוא, לכתוב או להתקשר. "הכחשה כברירת מחדל" חייבת להחליף את "הרשאה כברירת מחדל". מעקות בטיחות בזמן ריצה צריך ליירט פעולות מסוכנות — כגון קריאות webhook חיצוניות או כתיבת קבצים — ולהחזיק אותן לאישור אנושי לפני ביצוען. פורנזיקה בלתי משתנה הם חיוניים באותה מידה: כל הנחיה, החלטה ושימוש בכלי חייבים להירשם כאירוע טלמטריה מדרגה ראשונה, כדי שהמגנים יוכלו לשחזר במדויק את מה שקרה. צוות אדום רציף יש לשלב בתהליכי פיתוח, שבהם מדמים באופן קבוע הזרקות רב-סיבוביות וניצול פרצות מקושרות כדי להעריך את החוסן בעולם האמיתי. מעל הכל, העיקרון של הרשאה מינימלית חייב לשלוט בכל דבר: להגביל את מה שה-AI יכול לראות, לגעת ולשנות בזמן ריצה.

מודל הגנתי לביצוע סוכני ניתן לסכם בתבנית פשוטה וניתנת לבדיקה.

def handle_task(request, scope): intent = nlp.parse(request) plan = planner.build(intent) for step in plan: if not policy.allow(step, scope): audit.log("blocked", step) continue

result = executor.run(step) analyzer.ingest(result) if analyzer.suspicious(result): human.review(result) break return analyzer.report()

קוד מדומה זה מייצג צינור הגנתי שבו כל שלב בביצוע הסוכן נבדק מול המדיניות, נרשם לצורך ביקורת ומאומת באמצעות ניתוח לפני שממשיכים הלאה. זהו ההפך מאוטומציה עיוורת — איזון בין יעילות לאחריות.

ההשלכות של שינוי זה חורגות הרבה מעבר לכל ניצול או מאגר נתונים בודד. האקרים המשתמשים ב-AI סוכני אינם מנצלים CVE — הם מנצלים אמון. הם הופכים אוטומציה מועילה לערוצי תקשורת סמויים, וקושרים פעולות לגיטימיות כדי להשיג תוצאות זדוניות. כדי לשמור על ה-AI ככלי הגנה, יש להגביל את האוטונומיה שלו באמצעות שקיפות ואיתוריות. כל החלטה, כל חיבור וכל קריאה ל-API חייבים להיות ניתנים לצפייה, להסבר ולהיפוך.

גיל ה האקר AI סוכני אינה דיסטופיה; היא קריאת השכמה. האוטונומיה אכן יכולה להיות מכפיל הכוח הביטחוני הגדול ביותר שיצרנו אי פעם, אך רק אם היא פועלת בתוך מערכות המכירות בהיגיון כפונקציה מיוחדת — פונקציה הדורשת אימות, ולא אמון עיוור. השאלה המגדירה את העידן החדש הזה אינה האם ה-AI יפעל; זה האם נבין באמת מדוע זה קורה.