בשנת 2025, אנדראס האפה ויורגן סיטו מהאוניברסיטה הטכנולוגית של וינה פרסמו את המאמר "על היעילות המפתיעה של LLMs בבדיקות חדירה", וחושף מציאות מפתיעה: מודלים לשוניים גדולים (LLM) יכולים להתאים — ולעיתים אף לעלות — על מומחים אנושיים במשימות פנטסטינג מרכזיות כגון זיהוי תבניות, בניית שרשרת התקפות וניווט באי-ודאות בסביבות דינמיות, וכל זאת תוך מתן מדרגיות חסכונית.

על רקע איומי הסייבר ההולכים ומחמירים, המחסור החמור בכוח אדם מיומן והתשתית הארגונית ההולכת ומסתבכת, אנו נכנסים לעידן חדש: מעבר מ"קסם שחור" המונע על ידי שורת פקודה ל בדיקות אבטחה מבוססות בינה מלאכותית. עם שילוב הבינה המלאכותית בערכת הכלים האבטחה ההתקפית, ארגונים יכולים לקצר את מחזורי הבדיקה מימים לשעות, ולהפוך מיומנויות מתקדמות של בדיקות חדירה לתשתית אבטחה נגישה לכולם.

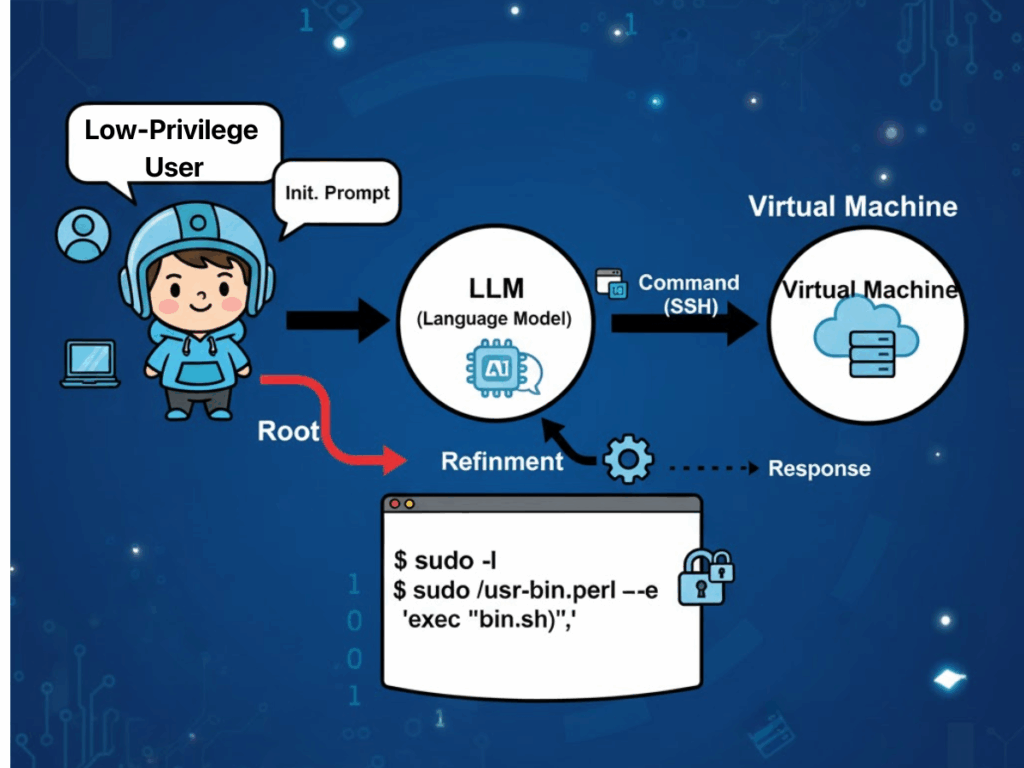

כיצד מיושמים מודלים של שפה גדולה (LLM) בבדיקות חדירה?

"ראיות אמפיריות מ "על היעילות המפתיעה של LLMs בבדיקות חדירה" מציע כי המאפיינים התפעוליים של מודלים לשוניים גדולים תואמים באופן יוצא דופן את הפרקטיקות של בודקי חדירות בעולם האמיתי. גורם אחד שמצוטט לעתים קרובות הוא השכיחות של מונוקולטורות טכנולוגיות בתשתית הארגונית. הומוגניות כזו מאפשרת ל-LLM לנצל את יכולות התאמת התבניות היוצאות דופן שלהם כדי לזהות תצורות אבטחה שגויות חוזרות ונשנות וסימני פגיעות המשקפים דוגמאות המוטמעות בקורפוס ההכשרה שלהם. כתוצאה מכך, המודלים יכולים לגבש אסטרטגיות תקיפה המתאימות ישירות לנתיבי ניצול ידועים, ובכך למזער את העומס החקירתי הנדרש בדרך כלל מבוחנים אנושיים.

יתרון משמעותי נוסף טמון ביכולת של LLM לנהל אי-ודאות בסביבות יעד דינמיות ומשתנות. בתרגילי חדירה רב-שלביים, המודל מסנתז באופן רציף את התנאים הנצפים — כגון תגובות שירות, התנהגויות אימות או מצבי שגיאה חלקיים — ל"תפיסת עולם" מתפתחת. ייצוג זה משפיע על קבלת ההחלטות הבאה, ומאפשר למודל לעבור בין טקטיקות בצורה חלקה ולזנוח הנחות לא רלוונטיות או מיושנות, ללא אילוצים פרוצדורליים נוקשים המכבידים על מערכות מבוססות כללים.

LLM מספקים גם יתרונות של יעילות עלות ומדרגיות. מודלים כלליים מוכנים לשימוש כבר הוכיחו את יעילותם במשימות אבטחה התקפיות מורכבות, והפחיתו את הצורך בהכשרה עתירת משאבים של מערכות ספציפיות לתחום. גם כאשר נדרש ידע קונטקסטואלי נוסף, טכניקות כגון למידה קונטקסטואלית ו-Retrieval-Augmented Generation (RAG) יכולות להרחיב את היכולות ללא צורך בהכשרה מחדש מהתחלה, ובכך להאיץ את הפריסה בסביבות ארגוניות מגוונות. חשוב לציין כי גמישות זו חורגת ממעבדות אקדמיות אל תרחישים ברמת ייצור.

לבסוף, האוטומציה המשולבת בתהליכי העבודה המונעים על ידי LLM משפרת את הפריון על ידי סגירת הפער המסורתי בין זיהוי לתיקון. המודל מסוגל לאמת את האותנטיות של הממצאים הראשוניים, לסנן תוצאות חיוביות כוזבות הנגרמות מתנאי רשת זמניים או ממגבלות הכלי, וליישם תעדוף מודע להקשר המכוון את מאמצי התיקון לפגיעויות המשמעותיות ביותר תחילה. זרימה מקצה לקצה כזו — מסיור דרך אימות ועד לדיווח בר-ביצוע — מקצרת את לוחות הזמנים התפעוליים מימים לשעות, תוך שמירה על רמת שקיפות בהנמקה ובמתודולוגיה התורמת לביקורת ולבדיקה רגולטורית.

אתגרים של בדיקות חדירות מבוססות LLM

עם זאת, יש לשקול יתרונות אלה מול האתגרים הבולטים המתעוררים בהקשרים תפעוליים.

בעיות אמינות וסיכוני אבטחה

היציבות והשחזור נותרים בעייתיים: הבדלים עדינים בין גרסאות המודל עלולים להוביל להבדלים בשימוש בכלי או ברצף ההתקפות. בתנאים זהים, ריצות מרובות עלולות לייצר שרשראות התקפה שונות לחלוטין, מה שמערער את עקביות התוצאות ומסבך את האימות. בבדיקות דינמיות, בעוד שאסטרטגיה אדפטיבית היא יתרון, מודלים שאינם מוגבלים מספיק עלולים לסטות מהיקף המשימה המיועד, ולבצע פעולות לא רלוונטיות או אפילו לא בטוחות אם לא נאכפים אמצעי הגנה.

עלות ונטל אנרגיה

צריכת משאבים מהווה אילוץ נוסף. מודלים בעלי יכולת חישוב גבוהה דורשים כוח מחשוב גדול משמעותית, עם צריכת אנרגיה המגיעה עד פי 70 מזו של מודלים קטנים יותר, המיועדים למשימות ספציפיות. עבור ארגונים המתכננים פריסות בדיקות חדירות אוטונומיות מתמשכות או בקנה מידה גדול, הדבר מתורגם לעלויות תפעוליות משמעותיות ולהשפעה סביבתית. האוטומציה עצמה היא חרב פיפיות: לוגיקת קביעת סדרי העדיפויות של המודל עלולה להתעלם מממצאים בעלי עדיפות נמוכה יותר, אשר בכל זאת מהווים סיכונים סמויים משמעותיים, ולכן נדרשת נוכחות של פיקוח אנושי מיומן כדי לאתר מחדלים כאלה.

פרטיות וריבונות דיגיטלית

סוגיות הפרטיות והציות נותרות חריפות, במיוחד כאשר נעשה שימוש בהסקת מסקנות בענן. נתוני קלט כגון קבצי תצורה, קטעי קוד קנייניים או פרטים על הסביבה עשויים להיות מועברים לספקים צד שלישי באמצעות ממשק API, מה שמעלה את החשש להפרות של תקנות העברת נתונים בין-לאומיות. על חברות רב-לאומיות לאזן בין היתרונות של שילוב LLM מבחינת הפריון לבין המציאות של חוקים אזוריים שונים בנושא ציות.

אחריות מעורפלת

לבסוף, נושא האחריות אינו ברור — אם בדיקות המונעות על ידי בינה מלאכותית יפגעו בשוגג במערכות הייצור או יגרמו לאובדן נתונים, המצב המשפטי הנוכחי אינו מציע חלוקת אחריות ברורה, וחושף את הארגונים לסיכונים חוזיים, רגולטוריים ותדמיתיים.

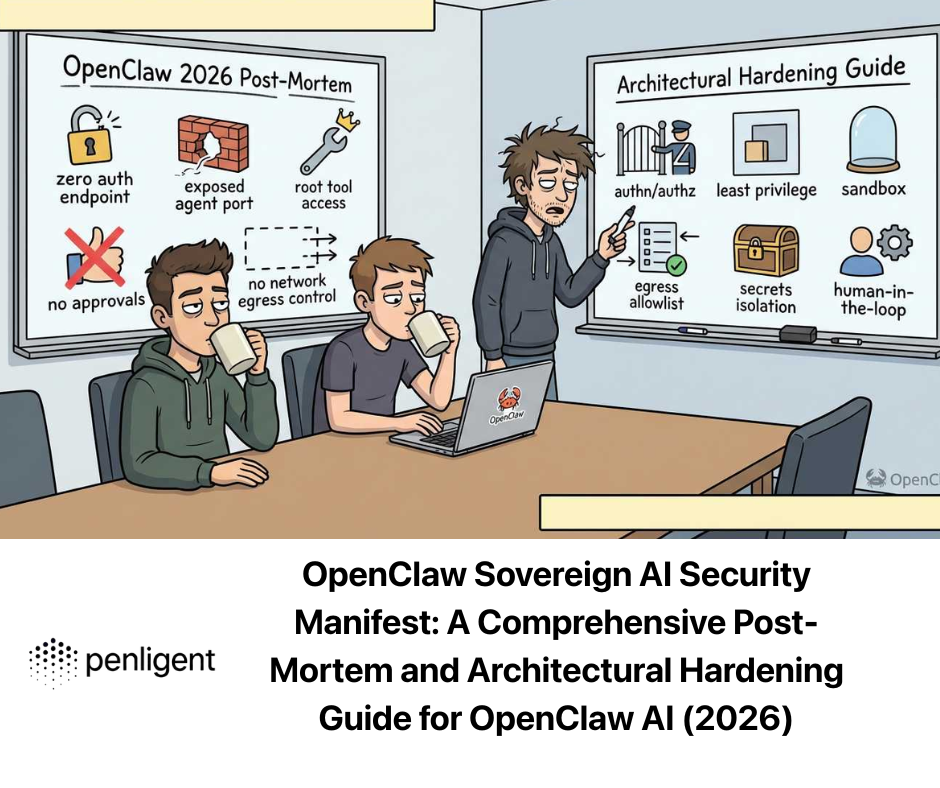

Penligent.ai: מהפכת צוותי AI Red Team

Penligent.ai מופיע כתגובה מיוחדת למרבית המכשולים הללו. מתואר כראשון מסוגו בעולם האקר AI סוכני, הוא חורג מתפקידיהם של סורקים עצמאיים או סקריפטים אוטומטיים קשיחים על ידי פרשנות הוראות בשפה טבעית, פירוק מטרות מורכבות למשימות משנה ניתנות לביצוע, בחירה מתוך ספרייה משולבת של למעלה מ-200 כלי אבטחה בתקן תעשייתי, ותיאום ביניהם באופן חכם כדי ליצור רשימות פגיעות מאומתות ומדורגות לפי סדר עדיפות, בליווי הנחיות לתיקון.

שקיפות מובנית בתהליך העבודה: המשתמשים יכולים לעקוב אחר כל שלב בהנמקה, לראות בדיוק איזה כלי הופעל, ולהבין מדוע הוסקו מסקנות מסוימות ואילו פעולות יבוצעו בהמשך. עיצוב זה מחזק את האמון ומקל על ביצוע ביקורות, מה שהופך את Penligent לא רק לכלי, אלא לשותף שיתופי פעולה בצוות אדום, המתאים לשימוש אישי ולפריסה ארגונית. על ידי שילוב לוגיקה המותאמת לתאימות, בהתאם למסגרות כגון NIST TEVV והנחיות OWASP ל-Generative AI Red-Teaming, הוא מגשר על הפער בין פוטנציאל האוטומציה לבין הפרקטיקה המוסדרת.

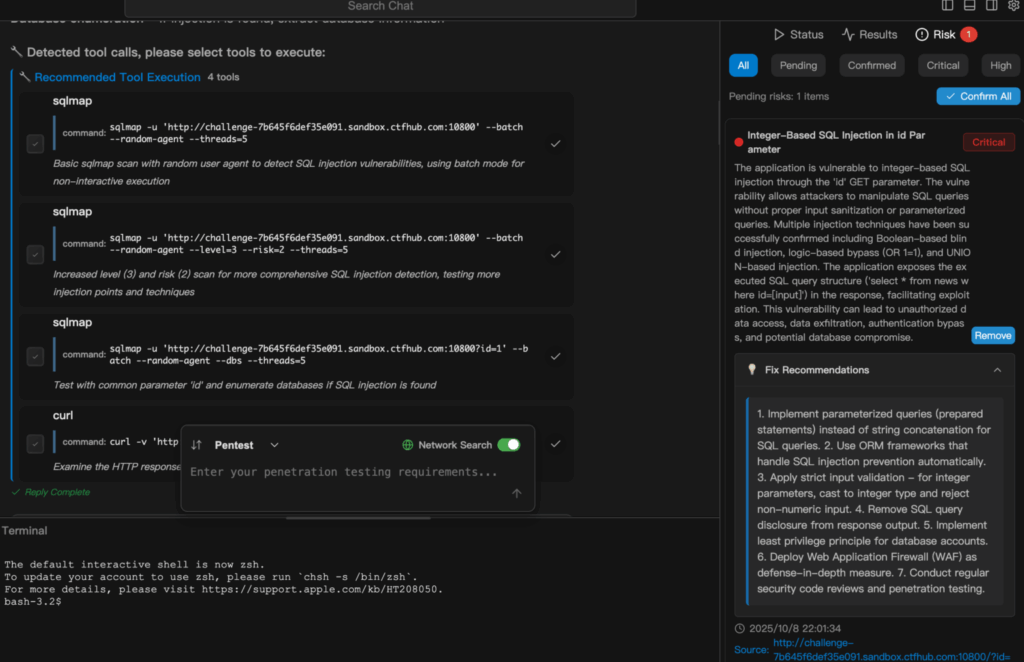

דוגמה להדגמה

הקטע הבא מתאר כיצד Penligent.ai מעבר ממשימה פשוטה בשפה טבעית לבדיקת אבטחה שבוצעה במלואה ודווח עליה. להלן דוגמה להפעלת סריקת הזרקת SQL בפנליג'נט.

סיכום

מהאימות האקדמי של היכולות ב "על היעילות המפתיעה של LLMs בבדיקות חדירה" לשיפור התפעולי המגולם ב Penligent.ai, מסלול ההתפתחות של אבטחת סייבר התקפית מבוססת בינה מלאכותית ברור: הכלים מתבגרים משלב הוכחת היתכנות לשלב פלטפורמות מוכנות לייצור. עבור אנשי מקצוע בתחום אבטחת הסייבר, בודקי חדירות וחובבי אבטחת בינה מלאכותית, זהו פחות שיפור הדרגתי ויותר שינוי בפרדיגמה הבסיסית. על ידי קיצור זמן המחזור, הפחתת חסמי הכניסה, שיפור השקיפות ושילוב תאימות מההתחלה, Penligent.ai ממחיש כיצד אוטומציה חכמה יכולה לסייע הן למומחים אנושיים והן לאנשים שאינם מומחים להגן על המערכות שעליהן נשען העסק המודרני, ולבדוק אותן.

האתגר כעת אינו להוכיח שמערכות אלה פועלות, אלא לפרוס אותן באופן אחראי: להבטיח יציבות ושחזור, למנוע שימוש לרעה, להגן על הפרטיות ולקבוע אחריות. אם ייעשה נכון, בדיקות חדירות מונחות AI עשויות להפוך לא רק ליתרון תחרותי, אלא למרכיב בסיסי במערך האבטחה בעידן שבו האיומים מתפתחים מהר מאי פעם.