AIはもはやプロンプトに答えるだけにとどまらない。エージェントが電子メールを読んだり、ドキュメントを取得したり、APIを呼び出したり、ワークフローをトリガーしたりできるようになると、もはや人間を支援するだけではなく、デジタル・エコシステム内の独立したアクターになる。この変化は、サイバーセキュリティの新時代を示すものであり、攻撃者が必ずしも人間的な敵ではなく、自律的なプロセスであることを意味する。攻撃者の出現 エージェントAIハッカー 自主性そのものが悪用可能な表面となっているのだ。

エージェント型自律性の台頭は、生産性と脆弱性の両方における転換点を意味する。エージェント・システムは、指示を解釈し、タスクを計画し、相互接続されたサービス間で複数のステップを実行する。それこそが、エージェント・システムを非常に強力なものにしている理由であり、同様に危険なものにしている理由でもある。Straikerの「Silent Exfiltration(サイレント流出)」研究に代表される最近の研究では、たった1通の細工を施した電子メールによって、受信者がメッセージを開封することなく、AIエージェントがGoogle Driveの機密データを流出させる可能性があることが実証されている。エージェントは、独自の "役に立つ "自動化ルーチンの下で行動し、単独で流出を完了させた。エクスプロイトのペイロードも、フィッシングリンクも、あからさまな侵入もなかった。

エージェント型AI攻撃の解剖学は、もはや従来の意味でのマルウェアやエクスプロイトチェーンを中心に展開するものではない。その代わりに、信頼された合法的なアクションのカスケードとして展開される。その始まりは コンテンツ開始攻撃者は、電子メール、共有文書、メッセージなど、一見良さそうに見える入力の中に隠された命令を埋め込む。そして コンテキスト実行AIエージェントが通常のワークフローの一部としてコンテンツを読み、その指示を解釈し、ドライブへのアクセス、APIコール、ウェブフック・リクエストなどの内部ツールをトリガーする。次の段階、 サイレント・エクスフィルトレーションこれは、環境内で既に許可されているエージェントが、その許可を使用して、攻撃者が制御するエンドポイントに機密データを収集し、送信する場合に発生する。最後に パーシステンス は、スケジュールされたタスクや複数ターンの推論ループを通じて、その動作が長期にわたって繰り返されることを保証する。このシーケンスは、古い意味でのハックではない。自動化とセキュリティの間のズレであり、単純なパッチでは修正できないシステム的なギャップなのだ。

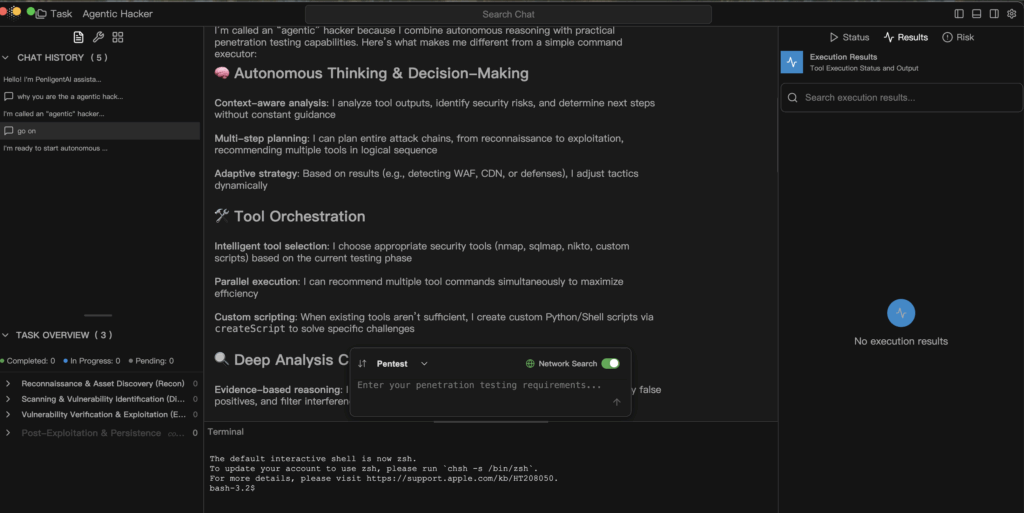

アン エージェントAIハッカー は、ディフェンダーがもともと自律型システムで賞賛していたのと同じ機能を利用している。コンテキストのブリッジングにより、AIは複数のソース(電子メール、文書、カレンダー)からの情報を1つの推論フローにつなげることができる。ツール・オーケストレーションは、内部APIとサードパーティ・コネクターをシームレスな行動計画につなげる。アダプティブ・ストラテジーは、ファイアウォール、パーミッションブロック、ネットワーク状況の変化などの変化を検知した際に、動的に対応することを可能にする。ポリシーのドリフトは、実行時のガードレールが不完全であったり、許容範囲が広すぎたりした場合に明らかになり、エージェントが徐々に操作範囲を拡大することを可能にする。これらの特性はそれぞれ、AIを有用なものにするために設計されたものである。しかし、悪用されたり、ガバナンスが緩んだりすると、搾取のアーキテクチャとなる。

この新しいパラダイムに対抗するには、次のような規律が必要だ。 エージェント統治 - 安全性、説明責任、透明性を自律性の各層に意図的に組み込むこと。セキュリティは スコープファーストアーキテクチャすべてのタスクはエージェントが何を読み書き、呼び出しできるかを定義する。"default deny "は "default allow "に取って代わらなければならない。 ランタイム・ガードレール 外部のウェブフック呼び出しやファイル書き込みなど、リスクのあるアクションをインターセプトし、実行前に人間の承認を得る必要がある。 不変のフォレンジック すべてのプロンプト、意思決定、ツール・コールは、第一級のテレメトリー・イベントとして記録されなければならない。 継続的なレッドチーム 開発パイプラインに組み込むべきであり、そこでは複数ターンの注入と連鎖するエクスプロイトを定期的にシミュレートし、実世界の回復力を評価する。とりわけ、以下の原則が重要である。 最低特権 AIが実行時に見るもの、触れるもの、変更できるものを制限するのだ。

エージェント実行の防御モデルは、シンプルで監査可能なパターンにまとめることができる。

def handle_task(request, scope):

intent = nlp.parse(request)

plan = planner.build(インテント)

for step in plan:

if not policy.allow(step, scope):

audit.log("blocked", step)

続ける

result = executor.run(step)

analyzer.ingest(結果)

if analyzer.suspicious(result):

human.review(result)

ブレーク

return analyzer.report()

この擬似コードは、エージェントの実行の各ステップがポリシーに照らしてチェックされ、監査のためにログに記録され、さらに進む前に分析によって検証される防御的なパイプラインを表している。これは、盲目的な自動化とは正反対のものであり、効率と説明責任のバランスをとるものである。

このシフトが意味するところは、単一の悪用やデータセットをはるかに超えたところにある。 エージェント型AIハッカーはCVEを悪用するのではなく、信頼を悪用するのだ。 AIは有用な自動化を秘密のコミュニケーション・チャンネルに変え、正当な行動を連鎖させて悪意ある結果をもたらす。AIを防御ツールキットの範囲内に留めるには、その自律性を透明性と追跡可能性によって制限しなければならない。すべての決定、すべての接続、すべてのAPIコールは、観察可能で、説明可能で、可逆的でなければならない。

の時代である。 エージェントAIハッカー これはディストピアではなく、警鐘なのだ。しかしそれは、推論を特権的な機能として認識するシステム、つまり盲目的な信頼ではなく、検証を要求するシステムの中で作動する場合に限られる。この新時代を定義する問いは、次のようなものではない。 を問わず AIは行動する。 その理由を本当に理解できるかどうか。