はじめに

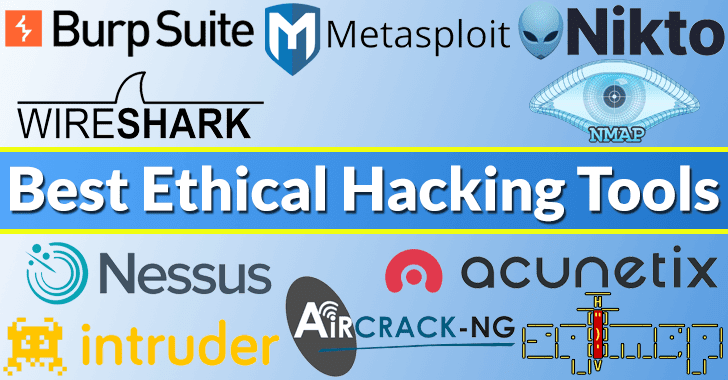

サイバーセキュリティの文脈で、 ハッキングツール とは、システムのセキュリティ態勢を特定し、テストし、検証するために使用される多様な技術的手段を指す。これらは、「ハッカー・ソフトウェア」と同義ではなく、むしろ、「ハッカー・ソフトウェア」の重要な構成要素として機能する。 侵入テスト脆弱性の検証、セキュリティ評価のワークフローを提供します。NmapのポートスキャンからMetasploitのエクスプロイト・フレームワーク、Burp Suiteのトラフィック傍受に至るまで、これらのツールは現代の攻撃的・防御的セキュリティの運用基盤を形成している。

自動化とAIの台頭にもかかわらず、その価値は ハッキングツール は依然として衰えることがない。これらのツールは、セキュリティ知識の「実行可能な形」を具現化し、システムの境界と攻撃対象領域を経験的に検証することで、実務者を支援する。実際、将来のインテリジェント・セキュリティ・システムは、これらのツールの上に構築されることになるだろう。オーケストレーションと意味的理解が、コマンドラインの「黒魔術」を説明可能なエージェント駆動型のセキュリティ・インテリジェンスに変えるのである。

なぜハッキングツールが重要なのか?

セキュリティ・オペレーションにおいて、ハッキング・ツールは理論と実践の橋渡しをします。専門家は、仮説を検証し、攻撃を再現し、盲点を発見するためにハッキング・ツールを活用しています。AI主導の推論は、これらのツールが生成する経験的データに依存し、防御の自動化は、保護戦略を最適化するためのフィードバックに依存します。

その重要性は3つの側面にある:

- 知識の実行層 - セキュリティの理論は、ツールによって運用されて初めて価値を持つ。

- 防衛のための基準フレーム - ツールは、ディフェンスが理解し、模倣しなければならないオフェンスの境界線を定義する。

- AIセキュリティの訓練場 - AIエージェントが「リスクを理解する」のは、その意味論がツールによって生成された経験的データに基づくものだからだ。

ハッキングツールの分類と機能

ハッキング・ツールの分類は、偵察・スキャンから悪用・報告まで、セキュリティ・エンジニアリングのライフサイクル全体を反映している。

| カテゴリー | コア機能 | 能力特性 | ツール例 |

|---|---|---|---|

| 偵察 | ドメインの列挙、ホストの識別、ポートのスキャン、サービスのフィンガープリントの検出 | 高精度スキャン、パッシブデータ相関、低ノイズ検出 | Nmap、初段、Recon-ng |

| 搾取 | 既知の脆弱性を特定し、悪用して初期アクセスを達成する。 | 自動化されたペイロード管理、 スクリプト攻撃 鎖 | Metasploit、ExploitDB、 SQLマップ |

| 特権のエスカレーション | 低特権アカウントからシステム管理者レベルへの昇格 | カーネル悪用、クレデンシャル・ハーベスティング、ローカル特権昇格スクリプト | Mimikatz、LinPEAS、WinPEAS |

| 粘り強さと回避 | ターゲットシステムへのアクセスを維持し、検知を回避する。 | ルートキット侵入、プロセス難読化、アンチウイルス回避 | コバルト・ストライク、エンパイア、ヴェール |

| ポスト・エクスプロイテーション | データ収集、横移動、フォレンジック回避 | 横移動モジュール、データパッケージング、暗号化された流出 | ブラッドハウンド、パワービュー、シャープハウンド |

| アセスメント&ディフェンス | 脆弱性の検出、防御演習の実施、ログの分析 | 攻撃防御シミュレーション、AI支援検知、ビジュアル分析 | Burp Suite、Nessus、OWASP ZAP |

エンジニアリングの実践ハッキングツールの運用

運用化の目標はシンプルだ。 再現可能、監査可能、拡張可能.一般的な慣行には以下のようなものがある:

- アウトプット契約: パラメータ、バージョン、タイムスタンプを含む構造化出力(JSON / SARIF / カスタムスキーマ)を定義します。

- コンテナ化された実行コンテナイメージにツールをパッケージし、環境とdepを固定する。

- マイクロサービスとメッセージバスツールをリモートで起動可能なサービスやジョブとしてラップし、キュー(Kafka/RabbitMQ)を介してチェーン化することで、スケーラビリティとリトライを実現する。

- CI/CDの統合段階的深度(事前マージ、夜間、オンデマンド)でパイプラインにスキャンを組み込むことができます。

- 証拠と監査証跡コマンド、パラメータ、stdout/stderr、終了コード、ホスト情報、画像バージョンを監査可能な証拠バンドルにキャプチャします。

パラレルスキャンと出力正規化

以下は、複数のツールを並列に呼び出し(例としてNmapとNucleiを使用)、ランタイムメタデータをラップし、統一されたJSONを出力することを示す、実用的なPythonスクリプトテンプレートである。本番環境では、各ツールをコンテナ化されたジョブまたはマイクロサービスとして呼び出すことを推奨する。

# ops_runner.py - POC: 並列実行 + 正規化されたJSON出力

import subprocess, json, time, concurrent.futures, os, shlex

targets = ["10.0.0.5", "10.0.0.7"] ターゲット数

RESULT_DIR = "./out"

os.makedirs(RESULT_DIR, exist_ok=True)

def run_cmd(cmd):

meta = {"cmd": cmd, "started_at": time.time(), "host": os.uname().nodename}.

を試す:

# use shlex.split if cmd is string, here we pass list for safety

proc = subprocess.run(cmd, stdout=subprocess.PIPE, stderr=subprocess.PIPE, timeout=300, text=True)

meta.update({

"rc": proc.returncode、

"stdout": proc.stdout、

"stderr": proc.stderr、

"duration": time.time() - meta["started_at"].

})

except Exception as e:

meta.update({"rc":-1, "stdout":"", "stderr": str(e), "duration": time.time() - meta["started_at"]})

リターンメタ

def scan_target(target):

nmap_cmd = ["nmap", "-sV", "-p-", target, "-oX", "-"] #サンプル:XML生データを標準出力に出力

nuclei_cmd = ["nuclei", "-u", f "http://{target}", "-silent", "-json"].

res = {"target": target, "runs":{}}

res["runs"]["nmap"] = run_cmd(nmap_cmd)

res["runs"]["nuclei"] = run_cmd(nuclei_cmd)

return res

def main():

out = {"generated_at": time.time(), "results":{}}

with concurrent.futures.ThreadPoolExecutor(max_workers=4) as ex:

futures = {ex.submit(scan_target, t): t for t in TARGETS}.

for fut in concurrent.futures.as_completed(futures):

t = futures[fut].

out["results"][t] = fut.result()

with open(f"{RESULT_DIR}/scan_results.json", "w") as fh:

json.dump(out, fh, indent=2)

if __name__ == "__main__":

main()

キーノート

- 各呼び出しは、完全な実行時メタデータ(cmd、開始時間、持続時間、rc、stdout/stderr)を返す。

- 本番では、stdoutを構造化フィールド(Nuclei JSONなど)にパースし、集約のためにインデックスに取り込む。

- コンテナで実行する場合は

ドッカーランまたはKubernetesジョブでバージョン管理、並行性制御、分離を行う。

CI/CDにスキャンを組み込む

実践的なポイント

- レイヤード・スキャン戦略:軽量プローブ(ポートスキャン/基本テンプレート)をマージ前に使用し、ディープテンプレートと検証をマージ/メインまたはナイトリービルドで実行する。

- 条件付きトリガー:公開サービス」または特定の IaC ファイルに変更があった場合のみ、ディープスキャンをトリガーします。

- 失敗の方針:リスクの高い検証失敗についてはデプロイをブロックし、リスクの低い発見についてはチケットを作成し、デプロイを続行できるようにします。

- 証拠保管:各CIの実行結果を集中ストレージにアップロードし、ランIDにバインドする。

例(GitHub Actionsの疑似設定):

name: セキュリティ・スキャン

をクリックしてください:

プッシュ

ブランチ[main]

jobs:

quick-scan:

実行: ubuntu-latest

ステップ

- uses: アクション/チェックアウト@v3

- という名前をつける:クイックスキャン

run: docker run --rm my-registry/nmap:latest nmap -sS $TARGET -oX - > recon.xml

- name: アップロード結果

run: python3 upload_results.py recon.xml --job-id $GITHUB_RUN_ID

ヒント

- ステージスキャンでコストとノイズを管理。

- 変更検出を使用して、関連する場合にのみ、より深いスキャンをトリガーする。

- トレーサビリティのため、ジョブIDとともに証拠をアーカイブする。

コンテナ化、マイクロサービス、メッセージバス

ツールをコンテナイメージやマイクロサービスとしてラッピングすることで、制御可能な環境、バージョンのトレーサビリティ、スケールを実現する。出力をメッセージバス(Kafka/RabbitMQ)にパブリッシュすることで、アナライザ、AIエージェント、SIEMが非同期に優先度を消費、集約、計算できる。

イベントの流れ

スケジューラーがコンテナジョブをトリガー → ツールが実行され、構造化された出力が出る → 結果がKafkaにプッシュ → 分析コンシューマー(AI/ルールエンジン)が取り込み、検証されたレポートが作成される → レポートが書き戻され、アラート/チケットがトリガーされる。

エビデンス・バンドルと監査可能性

各検出/エクスプロイトタスクは、証拠のバンドル(cmd、パラメータ、イメージハッシュ、標準出力、pcap、タイムスタンプ、ランナーノード)を生成する必要がある。バンドルは検索可能で、ダウンロード可能で、修復とコンプライアンスのためにチケットにリンクされていなければならない。

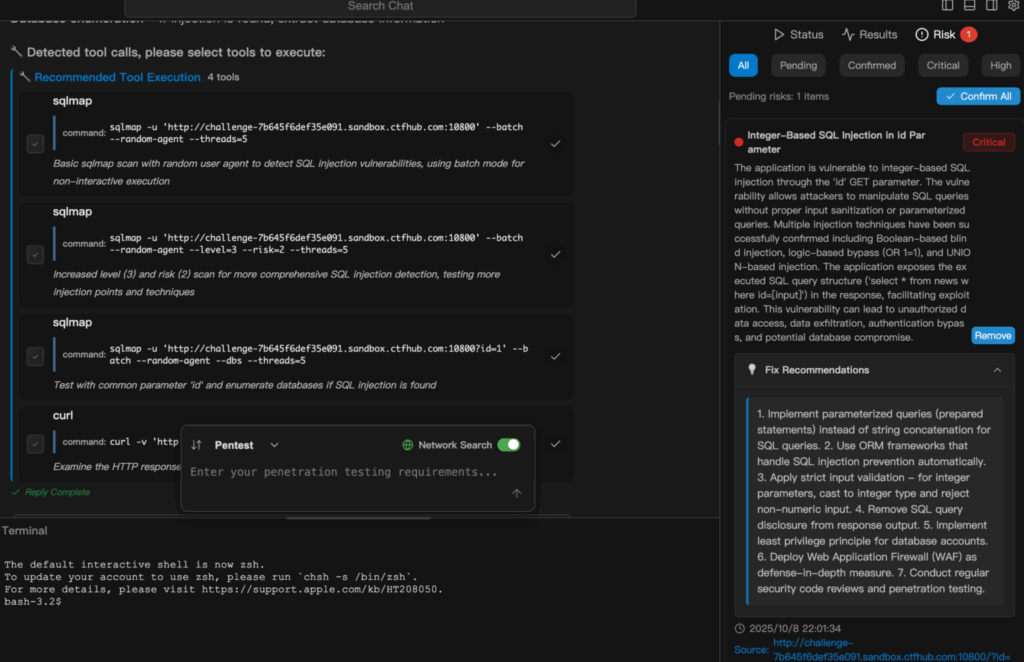

Penligent:200以上のハッキングツールによるインテリジェントなペンテスト

エンジニアリングの次のステップは「インテリジェント・オーケストレーション」であり、エージェントを使用してツールを連鎖させ、意思決定を行い、監査可能な結果を生成することである。Penligentはこの進化を体現している。自然言語入力をアクションシーケンスに変換し、適切なツールを自動選択して実行し、調査結果を検証し、エクスポート可能なレポートを生成する。主な技術要素:インテント解析、ツール選択戦略、検証ループ、監査証跡。

シナリオ(クラウドネイティブアプリのテスト)

命令が下った: "このサブドメインにSQLインジェクションとコンテナ露出がないかチェックする"このシステムは、資産の発見 → ウェブエンドポイントの特定 → テンプレートスキャン → 不審な発見の検証 → ホスト/コンテナのフィンガープリンティング、とタスクを分解する。すべてのツールの起動、パラメータ、実行ログ、および証拠となる出力が記録され、最終的な出力は、信頼性と影響度を伴う優先順位付けされた修復リストです。エンジニアにとっては、再現可能な技術的詳細を維持しながら、繰り返し作業を省くことができます。

シナリオ(エンタープライズCI/CD)

Penligentは、CI/CDに組み込むことができます。インフラやコードの変更がスキャンのトリガーとなると、プラットフォームはターゲットとなるテンプレートと検証を実行し、優先度の高い発見を発券システムや修正パイプラインにプッシュします。

結論

ハッキングツールは単なる道具ではなく、セキュリティ工学の知識の「オペレーティングシステム」を形成する。体系的に統合され、インテリジェントに編成されたとき、セキュリティ・テストは職人的な実践から、再現可能で科学的なプロセスへと進化する。Penligentは、ツールが骨格を形成し、インテリジェンスが現代のサイバーセキュリティの魂となる、この変革の始まりを示します。