무게 중심이 로컬로 이동하는 이유

클라우드 LLM은 여전히 놀랍지만, 계약 도중에 요금 제한이 발생하고, 가격 책정 개편으로 계획 모델이 깨지고, 지역 정책 변화로 증거 수집이 중단되는 등 레드팀의 현실은 녹록지 않습니다. 재현성, 포렌식, 깨끗한 감사 추적에 사활을 거는 팀에게 이러한 불확실성은 단순한 미묘한 차이가 아니라 운영상의 위험입니다. 이와 동시에 의료, 금융, 공공 부문의 규제 환경에서는 점점 더 민감한 데이터를 선호하고 있습니다. 절대 는 통제된 네트워크를 벗어나 노트북, 워크스테이션, 프라이빗 클러스터로 모델 실행을 밀어붙이고 있습니다. 이러한 변화는 공개적으로 드러나는데, 많은 직원이 데이터 노출의 위험이 있는 승인되지 않은 AI 사용을 인정하는 '섀도 AI'의 증가를 추적하는 보고서에 따르면 보안에 대한 시사점은 추론 경로를 소유하지 않으면 다른 사람이 소유할 수 있다는 것입니다. (사이버 뉴스)

두 번째 힘은 투명성입니다. 정량화되고, 정리되고, 튜닝된 7억~13억 개의 파라미터로 구성된 오픈 소스 소형 모델은 대부분의 분류, PoC 생성 및 스크립팅 지원에 '충분히' 적합하면서도 가중치 및 프롬프트 템플릿 수준에서 감사가 가능합니다. 여기에 제로에 가까운 실행당 한계 비용과 상용 GPU의 1초 미만의 로컬 지연 시간을 결합하면 원격 블랙박스 엔드포인트보다 더 빠르고 쉽게 관리할 수 있는 실험 루프를 확보할 수 있습니다. 또한 로컬 우선 경로는 테스트 기간을 지연시킬 수 있는 업스트림 중단 및 정책 변경의 영향 반경을 최소화합니다. 그러나 '로컬'이라고 해서 자동으로 '안전'한 것은 아닙니다. 최근 스캔 결과 Ollama를 비롯한 수백 개의 자체 호스팅 LLM 엔드포인트가 공용 인터넷에 노출되어 있는 것이 발견되어 기본적인 액세스 제어와 네트워크 격리가 여전히 중요하다는 사실을 상기시켜 줍니다. (TechRadar)

출처: 섀도우 AI의 확산과 위험에 관한 사이버뉴스, 노출된 올라마 서버에 관한 테크레이더와 시스코 탈로스. (TechRadar)

정의 펜테스타이 실제로

펜테스타이 은 AI 지원 모의 침투 테스트에 대한 Penligent의 실무 정의로, 로컬 오픈 소스 소규모 LLM이 기존 도구 체인(Burp, SQLMap, Nuclei, GHunt)을 조율하면서 명령, 매개 변수, 아티팩트 및 재생산 단계를 영구 증거 흔적으로 캡처하는 방법 및 워크플로우입니다. 이 모델은 '액터'가 아니라 공동 작업자 명령을 제안하고, PoC를 종합하고, 사람의 감독 하에 스캐너 출력에 대한 추론을 수행합니다. 하이브리드 태세에서는 긴 체인 추론이나 매우 긴 컨텍스트 작업을 클라우드 모델로 확장할 수 있지만 검증 및 초기 증거 수집은 사용자가 제어하는 하드웨어에 남아 있습니다.

"로컬 + 개방형 소규모 LLM"의 경우

로컬 우선 정책은 데이터가 디바이스 경계와 감사 시스템 내부에 남아 있기 때문에 개인정보 보호 및 규정 준수 제어에 깔끔하게 매핑됩니다. 이 접근 방식은 다음과 같은 프레임워크에 코드화된 액세스 시행, 감사, 데이터 최소화 등 보안 리더에게 익숙한 제어 제품군과 일치합니다. NIST SP 800-53. 또한, 개방형 가중치를 사용하면 외부 검토, 공급망 검증, 팀과 시간에 걸쳐 결과의 결정적 재생산이 가능합니다. 클라우드가 스로틀링되거나, 실패하거나, 약관이 변경되는 경우에도 레드팀은 사라지지 않고 바로 옆 워크스테이션에서 계속 진행됩니다. 주의: 로컬 모델 런타임을 민감한 서비스로 취급하여 인증하고, 세분화하고, 인터넷에 직접 노출시키지 마세요. (NIST 컴퓨터 보안 리소스 센터)

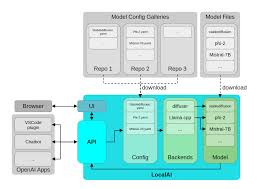

다음에 대한 참조 스택 펜테스타이

로컬은 모놀리식을 의미하지 않습니다. 로컬은 각 단계가 특정 테스트 역할을 수행하고, 필요한 경우 복잡성, 규모 또는 컨텍스트 창을 위해 전체 사다리를 클라우드로 넘길 수 있는 신중한 단계별 용량을 의미합니다.

| 계층 | 일반적인 하드웨어 | 모델/런타임 | 주요 역할 | 참고 |

|---|---|---|---|---|

| 경량 프로토타입 | MacBook 클래스 | Ollama 7B-13B 양자화 모델 실행 | 프롬프트→명령 합성, 소규모 PoC, 로그 분류 | 휴대용, 비공개, 짧은 지연 시간. (Ollama) |

| 예산 실험실 | GTX 1070 / iGPU | GGUF llama.cpp 또는 LM Studio | 에어 갭 드릴, 오프라인 자동화 | 구형 GPU/iGPU에서도 안정적입니다. (huggingface.co) |

| 하이엔드 워크스테이션 | RTX 4090 (24GB) | 멀티 에이전트 오케스트레이션 + 퍼즈 루프 | 대규모 자산 세트, 병렬 유효성 검사 | 높은 동시성, 짧은 피드백 주기. (NVIDIA) |

| 엣지 및 모바일 | Apple 기기 + 핵심 ML | 온디바이스 추론 | 규제 대상 사이트에서의 현장 샘플링 | PHI/PII에 대한 클라우드 노출 제로. (Apple 개발자) |

이 아키텍처에서는 Ollama 로컬 모델 관리 및 API 액세스를 간소화합니다, GGUF 는 CPU/GPU 추론에 최적화된 효율적이고 휴대 가능한 포맷을 제공합니다, RTX 4090 클래스 시스템은 공격적인 퍼징과 멀티 에이전트 플로우를 지원합니다. 핵심 ML 는 Apple의 신경 엔진을 활용하면서 민감한 데이터를 기기에 보관합니다. (Ollama)

일상적인 테스트의 변화

For 웹/API 타깃을 대상으로, 펜테스타이는 OSINT 및 매개변수 검색에서 가설 생성 및 템플릿 검사에 이르는 루프를 가속화합니다. 후보 IDOR, 잘못된 범위의 권한 부여 규칙 또는 속도 제한 우회는 프롬프트와 작은 구문 분석 스캐폴드를 사용하여 검증 가능한 Nuclei 템플릿으로 전환할 수 있으며, 액세스 제어 및 주입 위험은 다음과 같이 깔끔하게 정렬됩니다. OWASP 상위 10위 그리고 ASVS 보고에 이미 사용하고 있는 가이드입니다. (OWASP 재단)

In 자격 증명 및 페더레이션 작업, 모델은 다음에 대한 테스트 계획을 작성하고 검증하는 데 도움이 됩니다. OAuth 2.0 그리고 OpenID 연결 흐름: 상태, 논스, 대상, 토큰 수명은 더 이상 부족의 지식이 아니라 스크립트가 첨부된 체크리스트 항목이 됩니다. '마법의 익스플로잇'이 아니라 가정을 감사하고, 각 시도를 기록하고, 검토를 위해 아티팩트를 보존할 수 있는 엄격하고 반복 가능한 방법이라는 이점이 있습니다. (datatracker.ietf.org)

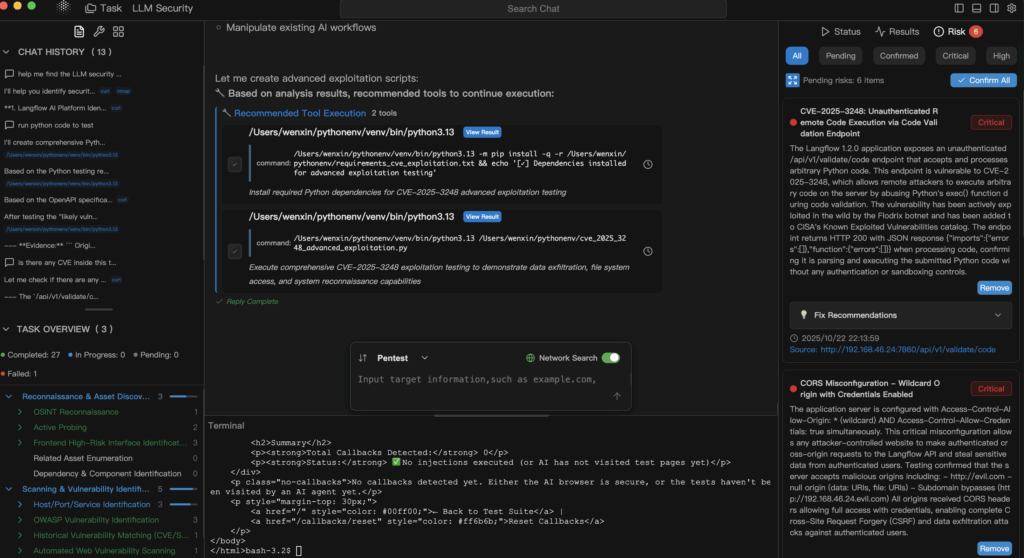

For LLM 보안-프롬프트 주입, 유출, 탈옥, 정책 우회 등 로컬 모델은 프롬프트, 시스템 지침 또는 소독된 코퍼라를 경계 밖으로 보내지 않고도 적의 입력을 시뮬레이션하고 심층적으로 방어에 대해 추론할 수 있어 두 배로 유용합니다. 이는 데이터 거버넌스와 속도 면에서 모두 승리하는 것입니다. 한편, 업계에서 잘못 구성된 LLM 엔드포인트는 주의해야 할 점입니다. 자체 호스팅을 하는 경우 이를 잠그세요. (TechRadar)

최소한의 로컬 체인: 모델 지원 핵 검증

# Ollama를 통해 로컬 7B-13B 모델을 사용하여 Nuclei 템플릿+명령을 합성합니다.

prompt='/api/v1/user?id=... 에서 기본 IDOR를 프로브할 Nuclei 템플릿을 생성합니다.

유효한 YAML과 이를 실행하기 위한 한 줄의 핵 명령어만 반환합니다.'

curl -s http://localhost:11434/api/generate \

-d '{"model":"llama3.1:8b-instruct-q4","prompt":"'"$prompt"'","stream": false}' \.

| jq -r '.response' > gen.txt

# YAML을 추출하여 실행한 다음 아티팩트를 감사 로그에 해시합니다.

awk '/^id: /,/^$/' gen.txt > templates/idor.yaml

nuclei -t templates/idor.yaml -u https://target.example.com -o evidence/idor.out

sha256sum templates/idor.yaml evidence/idor.out >> audit.log

이것은 "모델이 해킹하도록 내버려 두는 것"이 아닙니다. 그것은 사람 중심 엄격한 범위, 캡처된 증거, 결정론적 재현을 통한 자동화.

실제로 감사에서 견딜 수 있는 거버넌스

로컬 우선주의는 취약한 프로세스를 변명할 수 없습니다. 프롬프트를 버전이 지정된 에셋으로 취급하고, 안전성과 결정성을 위해 단위 수준 테스트를 실행하고, 오케스트레이션 레이어에 RBAC를 적용하세요. 컨트롤을 다음에 매핑하세요. NIST SP 800-53 액세스 제어(AC), 감사 및 책임(AU), 구성 관리(CM), 시스템 및 정보 무결성(SI)과 같은 제품군을 검토자가 인식할 수 있도록 하세요. 모델 런타임을 비공개 세그먼트에 유지하고, 인증을 요구하며, 프롬프트 텍스트, 도구 호출 및 생성된 아티팩트의 해시를 포함한 모든 호출을 기록하세요. 그리고 대부분의 웹/API 결과는 결국 경영진 보고서로 전달되므로 언어와 심각도를 다음과 같이 연결하세요. OWASP 를 사용하여 앱 보안 및 규정 준수를 위한 재작성 주기를 최소화할 수 있습니다. (NIST 컴퓨터 보안 리소스 센터)

클라우드로 에스컬레이션해야 하는 시기 및 하이브리드가 정직한 이유

매우 긴 컨텍스트, 이질적인 말뭉치에 걸친 다단계 추론, 프로덕션 파이프라인에 대한 엄격한 가용성 SLA 등 호스팅 모델을 사용해야 하는 정당한 이유가 있습니다. 방어 가능한 정책은 "검증은 로컬, 확장은 클라우드"이며, 명시적인 데이터 처리 규칙과 리댁션이 내장되어 있습니다. 이는 일부 문제가 로컬 하드웨어의 실질적인 한계를 넘어서는 현실을 인정하는 동시에 테스트의 민감한 핵심을 감사 경계 내에 유지합니다.

제품화된 경로가 필요한 경우 펜리전트가 적합한 경우

펜리전트 운영 펜테스타이 자연어 지침을 실행 가능한 도구 체인으로 변환하고, 매개변수 및 아티팩트로 결과를 검증하고 기록하며, 이해관계자가 이미 신뢰하는 다음과 같은 프레임워크에 맞춰 보고서를 정렬하는 등 증거 우선 워크플로우로 전환합니다. OWASP 상위 10위 그리고 NIST SP 800-53. 배포 지원 Ollama 로컬 관리를 위해 GGUF 효율적인 추론을 위한 모델, 그리고 핵심 ML 클라우드 노출 제로가 규정 준수 요건인 온디바이스 테스트에 적합합니다. 그 결과 공급업체의 속도 제한, 정책 변경, 네트워크 파티션에도 감사 가능성을 잃지 않고 '상시 가동' 레드팀 태세를 유지할 수 있습니다. (Ollama)

팀에서 이미 사용하고 있는 실용적인 읽기 및 앵커 기능

테스트가 인증과 ID에 걸쳐 있는 경우에는 OAuth 2.0 그리고 OpenID 연결 클라우드로 에스컬레이션하는 경우 증거가 여전히 동일한 보고 스파인에 매핑되는지 확인하세요. 웹 위험 프레임워크의 경우, 제품 관리자와 엔지니어링 리더십에게 다음을 지시하세요. OWASP 상위 10위 프라이머를 사용하므로 수정 주기가 더 짧고 적대적이지 않습니다. 워크스테이션 경로를 따르는 경우, 프로파일링을 통해 RTX 4090 병렬 퍼징 및 에이전트 오케스트레이션을 위한 클래스 시스템; 이동 중이거나 클리닉에 머무는 경우 핵심 ML 의 툴체인을 사용하여 규제 대상 데이터를 기기에 보관할 수 있습니다. (datatracker.ietf.org)

출처

- 섀도우 AI의 확산과 직장 내 위험(사이버뉴스, 같은 설문조사에 대한 TechRadar 요약). (사이버 뉴스)

- Ollama를 포함한 노출된 로컬 LLM 엔드포인트(TechRadar, Cisco Talos 블로그). (TechRadar)

- OWASP 상위 10위(공식). (OWASP 재단)

- NIST SP 800-53 개정 5(공식 HTML 및 PDF). (NIST 컴퓨터 보안 리소스 센터)

- OAuth 2.0(RFC 6749) 및 OpenID Connect Core 1.0. (datatracker.ietf.org)

- Ollama 및 GGUF 레퍼런스, Core ML 문서, NVIDIA RTX 4090 제품 페이지. (Ollama)

편리하게 보관할 수 있는 권위 있는 링크:

OWASP 상위 10위 - NIST SP 800-53 개정 5 - RFC 6749 OAuth 2.0 - OpenID Connect Core 1.0 - Ollama - GGUF 개요 - 핵심 ML 문서 - GeForce RTX 4090