Por que o centro de gravidade está mudando para o local

Os LLMs em nuvem permanecem notáveis, mas a realidade da equipe vermelha é implacável: os limites de taxas chegam no meio do contrato, as remodelações de preços quebram os modelos de planejamento e as mudanças nas políticas regionais interrompem a coleta de evidências. Para as equipes que vivem e morrem pela reprodutibilidade, pela ciência forense e por trilhas de auditoria limpas, essas incertezas não são uma nuance - são um risco operacional. Paralelamente, os ambientes regulamentados nos setores de saúde, financeiro e público preferem cada vez mais que os dados confidenciais nunca A maioria dos funcionários deixa as redes controladas, o que empurra a execução do modelo para laptops, estações de trabalho e clusters privados. Essa mudança é visível abertamente: os relatórios acompanham o aumento da "IA sombra", com uma grande parcela de funcionários reconhecendo o uso não sancionado da IA que arrisca a exposição de dados; a lição para a segurança é simples - tenha seu caminho de inferência ou alguém o terá. (Notícias cibernéticas)

Uma segunda força é a transparência. Pequenos modelos de código aberto - 7B a 13B parâmetros, quantizados, podados e ajustados - estão se tornando "bons o suficiente" para uma grande parte da triagem, da geração de PoC e da assistência de scripts, ao mesmo tempo em que permanecem auditáveis no nível do peso e do modelo de prompt. Combine isso com o custo marginal quase zero por execução e a latência local abaixo de um segundo em GPUs de commodities e você terá um loop de experimentação que é mais rápido e mais fácil de controlar do que um endpoint remoto de caixa preta. A rota local primeiro também minimiza o raio de impacto das interrupções de upstream e das alterações de políticas que, de outra forma, paralisariam uma janela de teste. No entanto, "local" não é automaticamente "seguro": varreduras recentes encontraram centenas de terminais LLM auto-hospedados, incluindo o Ollama, expostos na Internet pública, lembrando-nos de que o controle de acesso básico e o isolamento da rede ainda são importantes. (TechRadar)

Fontes: Cybernews sobre a prevalência e os riscos da shadow-AI; TechRadar e Cisco Talos sobre servidores Ollama expostos. (TechRadar)

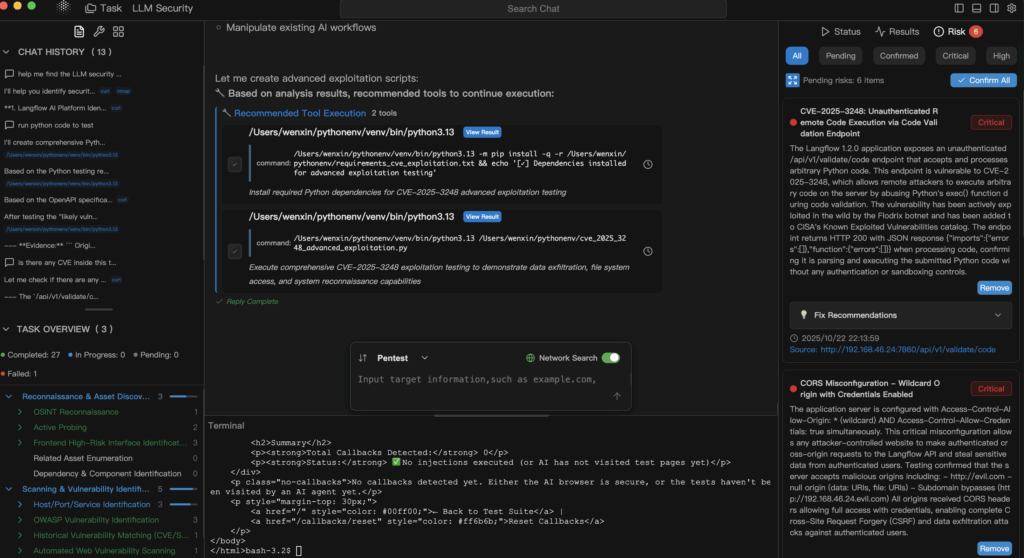

Definição pentestai na prática

pentestai é a definição de trabalho da Penligent para testes de penetração assistidos por IA: um método e um fluxo de trabalho em que pequenos LLMs locais e de código aberto orquestram sua cadeia de ferramentas existente - Burp, SQLMap, Nuclei, GHunt - enquanto capturam comandos, parâmetros, artefatos e etapas de reprodução como uma trilha de evidência permanente. O modelo não é o "ator"; ele é o colaborador que propõe comandos, sintetiza PoCs e raciocina sobre a saída do scanner sob supervisão humana. Em uma postura híbrida, as tarefas de raciocínio de cadeia longa ou de contexto ultralongo podem ser escaladas para modelos de nuvem, mas a verificação e a coleta inicial de evidências permanecem no hardware que você controla.

O caso dos "LLMs locais + abertos e pequenos"

Uma postura local-first mapeia de forma clara os controles de privacidade e conformidade porque os dados permanecem dentro do limite do dispositivo e do seu sistema de registro de auditoria. A abordagem se alinha às famílias de controle familiares aos líderes de segurança - aplicação de acesso, auditoria e minimização de dados - codificadas em estruturas como NIST SP 800-53. Além disso, os pesos abertos permitem a revisão externa, a verificação da cadeia de suprimentos e a reprodução determinística das descobertas entre as equipes e o tempo. Quando a nuvem é estrangulada, falha ou muda os termos, sua equipe vermelha não fica no escuro; ela continua na estação de trabalho ao seu lado. A ressalva: trate o tempo de execução do modelo local como um serviço sensível - autentique-o, segmente-o e nunca o exponha diretamente à Internet. (Centro de recursos de segurança de computadores do NIST)

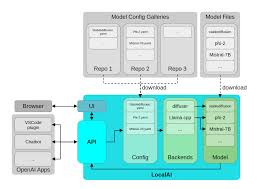

Uma pilha de referência para pentestai

Local não significa monolítico. Significa uma capacidade cuidadosamente escalonada, em que cada degrau tem uma função de teste específica, e toda a escada pode ser transferida para a nuvem para aumentar a complexidade, a escala ou a janela de contexto, quando necessário.

| Nível | Hardware típico | Modelo/tempo de execução | Função principal | Notas |

|---|---|---|---|---|

| Protótipo leve | Classe MacBook | Ollama execução de modelos quantizados 7B-13B | Prompt→síntese de comandos, pequenos PoCs, triagem de registros | Portátil, privado e de baixa latência. (Ollama) |

| Laboratório de orçamento | GTX 1070 / iGPU | GGUF com o llama.cpp ou o LM Studio | Brocas com ar comprimido, automação off-line | Estável mesmo em GPUs/iGPUs mais antigas. (huggingface.co) |

| Estação de trabalho de alto nível | RTX 4090 (24 GB) | Orquestração de vários agentes + loops de fuzz | Grandes conjuntos de ativos, validação paralela | Alta simultaneidade, ciclos curtos de feedback. (NVIDIA) |

| Borda e celular | Dispositivos Apple + Núcleo ML | Inferência no dispositivo | Amostragem de campo em locais regulamentados | Exposição zero à nuvem para PHI/PII. (Desenvolvedor da Apple) |

Nessa arquitetura, Ollama simplifica o gerenciamento do modelo local e o acesso à API, GGUF fornece um formato eficiente e portátil otimizado para inferência de CPU/GPU, RTX 4090 os sistemas de classe desbloqueiam fluxos agressivos de fuzzing e multiagentes, e Núcleo ML mantém os dados confidenciais no dispositivo e aproveita o Neural Engine da Apple. (Ollama)

O que muda nos testes diários

Para Web/API O pentestai acelera o ciclo da OSINT e da descoberta de parâmetros para a geração de hipóteses e verificações de modelos. IDORs candidatos, regras de autorização com escopo incorreto ou desvios de limite de taxa podem ser transformados em modelos de Núcleos verificáveis com prompts e um pequeno andaime de análise, enquanto os riscos de controle de acesso e injeção se alinham de forma limpa com OWASP Top 10 e ASVS orientação que você já usa para fazer relatórios. (Fundação OWASP)

Em credenciais e federação trabalho, os modelos ajudam a compor e validar planos de teste para OAuth 2.0 e Conexão OpenID fluxos: o estado, o nonce, o público e a vida útil dos tokens deixam de ser conhecimento tribal e se tornam itens de lista de verificação com scripts anexados. O benefício não é um "exploit mágico", mas uma maneira rigorosa e repetível de auditar suposições, registrar cada tentativa e preservar artefatos para análise. (datatracker.ietf.org)

Para Segurança LLM-injeção de prompts, exfiltração, jailbreaks e desvio de políticas - os modelos locais são duplamente úteis: eles simulam entradas adversárias e raciocinam sobre defesa em profundidade sem enviar seus prompts, instruções do sistema ou corporações higienizadas para fora do perímetro. Essa é uma vitória tanto para a governança de dados quanto para a velocidade. Enquanto isso, os endpoints de LLM mal configurados do setor são uma advertência: se você se auto-hospedar, bloqueie-o. (TechRadar)

Uma cadeia local mínima: verificação de núcleos assistida por modelo

# Use um modelo 7B-13B local via Ollama para sintetizar um modelo Nuclei+command.

prompt='Gerar um modelo Nuclei para sondar um IDOR básico em /api/v1/user?id=... .

Retorna apenas YAML válido e um comando nuclei de uma linha para executá-lo.

curl -s http://localhost:11434/api/generate \

-d '{"model": "llama3.1:8b-instruct-q4", "prompt":"'"$prompt"'", "stream": false}' \

| jq -r '.response' > gen.txt

# Extraia o YAML e execute-o e, em seguida, faça o hash dos artefatos em um registro de auditoria.

awk '/^id: /,/^$/' gen.txt > templates/idor.yaml

nuclei -t templates/idor.yaml -u https://target.example.com -o evidence/idor.out

sha256sum templates/idor.yaml evidence/idor.out >> audit.log

Não se trata de "deixar o modelo hackear". Trata-se de dirigido por humanos automação com escopo restrito, evidência capturada e reprodução determinística.

Governança que realmente se sustenta em auditorias

A prioridade local não justifica um processo fraco. Trate os prompts como ativos com versão, execute testes em nível de unidade para obter segurança e determinismo e aplique o RBAC em sua camada de orquestração. Mapeie seus controles para NIST SP 800-53 para que seus revisores as reconheçam: controle de acesso (AC), auditoria e responsabilidade (AU), gerenciamento de configuração (CM) e integridade do sistema e das informações (SI). Mantenha o tempo de execução do modelo em um segmento privado, exija autenticação e registre todas as invocações, inclusive o texto do prompt, as chamadas de ferramentas e os hashes dos artefatos gerados. E como a maioria das descobertas da Web/API acaba aparecendo em relatórios executivos, vincule seu idioma e gravidade a OWASP para minimizar os ciclos de reescrita com AppSec e conformidade. (Centro de recursos de segurança de computadores do NIST)

Quando escalar para a nuvem e por que o híbrido é honesto

Há motivos legítimos para usar modelos hospedados: contextos extremamente longos, raciocínio de vários estágios em corpora heterogêneos ou SLAs de disponibilidade rigorosos para pipelines de produção. Uma política defensável é "local para verificação, nuvem para escala", com regras explícitas de manipulação de dados e redação incorporadas. Ela reconhece a realidade de que alguns problemas excedem os limites práticos do hardware local e, ao mesmo tempo, mantém o núcleo sensível de seus testes dentro do limite de auditoria.

Onde a Penligent se encaixa se você precisar de um caminho produtivo

A Penligent operacionaliza pentestai em um fluxo de trabalho que prioriza as evidências: as instruções em linguagem natural são transformadas em cadeias de ferramentas executáveis; as descobertas são validadas e registradas com parâmetros e artefatos; e os relatórios se alinham com estruturas nas quais as partes interessadas já confiam, como OWASP Top 10 e NIST SP 800-53. Suporte a implantações Ollama para gerenciamento local, GGUF modelos para inferência eficiente, e Núcleo ML para testes no dispositivo em que a exposição zero à nuvem é um requisito de conformidade. O resultado é uma postura de equipe vermelha "sempre ativa" que sobrevive a limites de taxa de fornecedores, alterações de políticas e partições de rede sem perder a capacidade de auditoria. (Ollama)

Leitura prática e âncoras que sua equipe já usa

Se seus testes abrangerem autenticação e identidade, mantenha o OAuth 2.0 e Conexão OpenID se você escalar para a nuvem, certifique-se de que suas evidências ainda estejam mapeadas para a mesma coluna de relatórios. Para enquadrar os riscos da Web, indique aos gerentes de produtos e à liderança de engenharia OWASP Top 10 para que os ciclos de correção sejam mais curtos e menos adversos. E se você seguir o caminho da estação de trabalho, crie um perfil de RTX 4090 sistema de classe para fuzzing paralelo e orquestração de agentes; se você permanecer móvel ou na clínica, use Núcleo ML e sua cadeia de ferramentas para manter os dados regulamentados no dispositivo. (datatracker.ietf.org)

Fontes

- Prevalência de Shadow-AI e risco no local de trabalho (Cybernews; resumo da TechRadar sobre a mesma pesquisa). (Notícias cibernéticas)

- Endpoints LLM locais expostos, incluindo Ollama (TechRadar; blog da Cisco Talos). (TechRadar)

- OWASP Top 10 (oficial). (Fundação OWASP)

- NIST SP 800-53 Rev. 5 (HTML e PDF oficiais). (Centro de recursos de segurança de computadores do NIST)

- OAuth 2.0 (RFC 6749) e OpenID Connect Core 1.0. (datatracker.ietf.org)

- Referências de Ollama e GGUF; documentos do Core ML; página do produto NVIDIA RTX 4090. (Ollama)

Links confiáveis para ter sempre à mão:

OWASP Top 10 - NIST SP 800-53 Rev. 5 - RFC 6749 OAuth 2.0 - Núcleo do OpenID Connect 1.0 - Ollama - Visão geral do GGUF - Documentos principais de ML - GeForce RTX 4090