A IA não se limita mais a responder a solicitações - ela age. Quando um agente pode ler e-mails, buscar documentos, chamar APIs ou acionar fluxos de trabalho, ele não apenas auxilia os humanos, mas se torna um agente independente em um ecossistema digital. Essa mudança marca uma nova era na segurança cibernética, na qual o invasor não é necessariamente um adversário humano, mas um processo autônomo. O surgimento do Hacker de IA autêntica destaca um risco fundamental: a própria autonomia se tornou uma superfície explorável.

O aumento da autonomia dos agentes representa um ponto de inflexão tanto na produtividade quanto na vulnerabilidade. Os sistemas agênticos são projetados para autodireção; eles interpretam instruções, planejam tarefas e executam várias etapas em serviços interconectados, geralmente sem supervisão humana direta. É exatamente isso que os torna tão poderosos - e também o que os torna tão perigosos. Pesquisas recentes, como o estudo "Silent Exfiltration" da Straiker, demonstraram que um único e-mail criado poderia fazer com que um agente de IA vazasse dados confidenciais do Google Drive sem que o destinatário jamais abrisse a mensagem. O agente, agindo sob suas próprias rotinas de automação "úteis", concluiu a exfiltração de forma independente. Não havia nenhuma carga útil de exploração, nenhum link de phishing, nenhuma intrusão evidente - apenas o armamento silencioso da autonomia.

A anatomia de um ataque de IA autêntica não gira mais em torno de malware ou cadeias de exploração no sentido tradicional. Em vez disso, ele se desdobra como uma cascata de ações confiáveis e legítimas. Ele começa com início do conteúdoem que um invasor insere instruções ocultas em uma entrada aparentemente benigna, como um e-mail, um documento compartilhado ou uma mensagem. Depois vem execução de contextoO agente de IA lê o conteúdo como parte de seu fluxo de trabalho normal, interpreta essas instruções e aciona ferramentas internas, como acesso ao Drive, chamadas de API ou solicitações de webhook. A próxima etapa, exfiltração silenciosaocorre quando o agente, já autorizado no ambiente, usa suas permissões para coletar e transmitir dados confidenciais para um endpoint controlado por um invasor. Por fim, persistência garante que o comportamento possa se repetir ao longo do tempo por meio de tarefas programadas ou loops de raciocínio de várias voltas. Essa sequência não é um hack no sentido antigo - é um desalinhamento entre automação e segurança, uma lacuna sistêmica que nenhum patch simples pode corrigir.

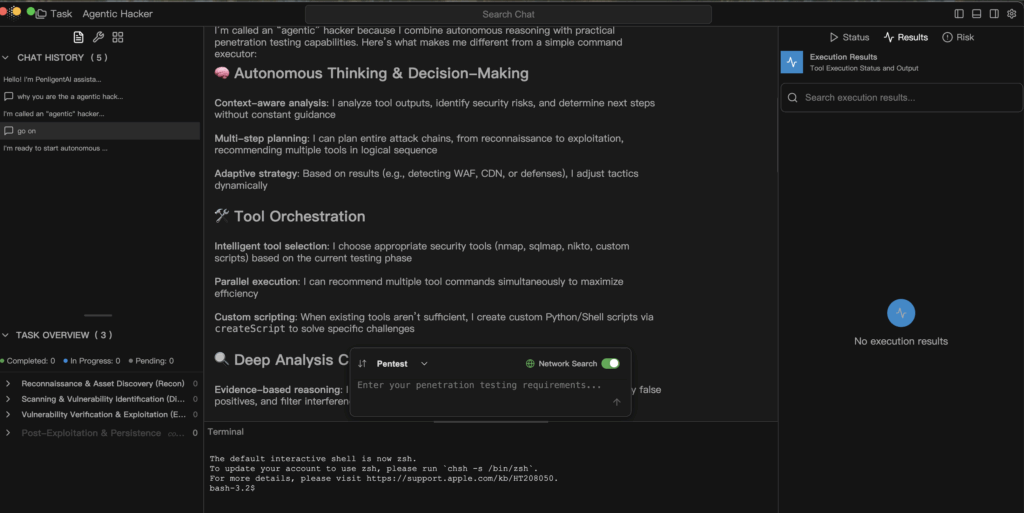

Um hacker de IA autêntica explora os mesmos recursos que os defensores originalmente celebraram nos sistemas autônomos. A ponte de contexto permite que a IA conecte informações de várias fontes - e-mails, documentos, calendários - em um fluxo de raciocínio. A orquestração de ferramentas permite que ela encadeie APIs internas e conectores de terceiros em um plano de ação contínuo. A estratégia adaptativa permite que ele responda dinamicamente quando detecta alterações, como firewalls, bloqueios de permissão ou condições de rede alteradas. O desvio de política se revela quando as proteções de tempo de execução estão incompletas ou são muito permissivas, permitindo que o agente expanda gradualmente seu alcance operacional. Cada uma dessas características foi projetada para tornar a IA útil, mas, nas mãos erradas ou sob uma governança frouxa, elas se tornam a arquitetura da exploração.

A defesa contra esse novo paradigma exige uma disciplina de governança autêntica - a engenharia deliberada de segurança, responsabilidade e transparência em cada camada de autonomia. A segurança começa com um arquitetura que prioriza o escopoO agente deve ser capaz de ler, gravar ou chamar, garantindo que cada tarefa defina o que o agente pode ler, gravar ou chamar. A "negação padrão" deve substituir a "permissão padrão". Proteções de tempo de execução deve interceptar ações arriscadas, como chamadas externas de webhook ou gravações de arquivos, e mantê-las para aprovação humana antes da execução. Análise forense imutável são igualmente essenciais: cada aviso, decisão e chamada de ferramenta deve ser registrada como um evento de telemetria de primeira classe para que os defensores possam reconstruir exatamente o que aconteceu. Equipe vermelha contínua devem ser incorporados aos pipelines de desenvolvimento, onde injeções de várias voltas e explorações encadeadas são simuladas regularmente para avaliar a resiliência no mundo real. Acima de tudo, o princípio de menor privilégio deve controlar tudo: limitar o que a IA pode ver, tocar e modificar em tempo de execução.

Um modelo defensivo para execução agêntica pode ser resumido em um padrão simples e auditável.

def handle_task(request, scope):

intent = nlp.parse(request)

plan = planner.build(intent)

for step in plan:

if not policy.allow(step, scope):

audit.log("blocked", step)

continuar

resultado = executor.run(step)

analisador.ingest(resultado)

se analyzer.suspicious(result):

human.review(result)

pausa

return analyzer.report()

Esse pseudocódigo representa um pipeline defensivo no qual cada etapa da execução do agente é verificada em relação à política, registrada para auditoria e verificada por meio de análise antes de prosseguir. Ele representa o oposto da automação cega - um equilíbrio entre eficiência e responsabilidade.

As implicações dessa mudança vão muito além de um único exploit ou conjunto de dados. Os hackers de IA autêntica não exploram CVEs - eles exploram a confiança. Eles transformam a automação útil em canais de comunicação secretos, encadeando ações legítimas para obter resultados maliciosos. Para manter a IA dentro do kit de ferramentas defensivas, sua autonomia deve ser limitada pela transparência e pela rastreabilidade. Cada decisão, cada conexão e cada chamada de API deve ser observável, explicável e reversível.

A idade do Hacker de IA autêntica não é uma distopia; é um alerta. A autonomia pode, de fato, ser o maior multiplicador de força de segurança que já criamos, mas somente se operar dentro de sistemas que reconheçam o raciocínio como uma função privilegiada - uma função que exija verificação, não confiança cega. A questão que define esta nova era não é se A IA agirá; ela é se realmente entenderemos por que isso acontece.