Em 2025, Andreas Happe e Jürgen Cito, da TU Wien, publicaram"Sobre a surpreendente eficácia dos LLMs para testes de penetração", revelando uma realidade surpreendente: Os modelos de linguagem ampla (LLMs) podem se equiparar - e às vezes superar - os especialistas humanos nas principais tarefas de pentesting, como reconhecimento de padrões, construção de cadeias de ataque e navegação pela incerteza em ambientes dinâmicos, tudo isso oferecendo escalabilidade econômica.

Em um cenário de crescentes ameaças cibernéticas, grave escassez de talentos e infraestrutura empresarial cada vez mais complexa, isso marca uma nova era: uma mudança da "magia negra" orientada pela linha de comando para Testes de segurança com tecnologia de IA. Com a IA incorporada ao kit de ferramentas de segurança ofensiva, as organizações podem reduzir os ciclos de teste de dias para horas, transformando as habilidades avançadas de pentesting em uma infraestrutura de segurança acessível a todos.

Como os LLMs são aplicados em testes de penetração?

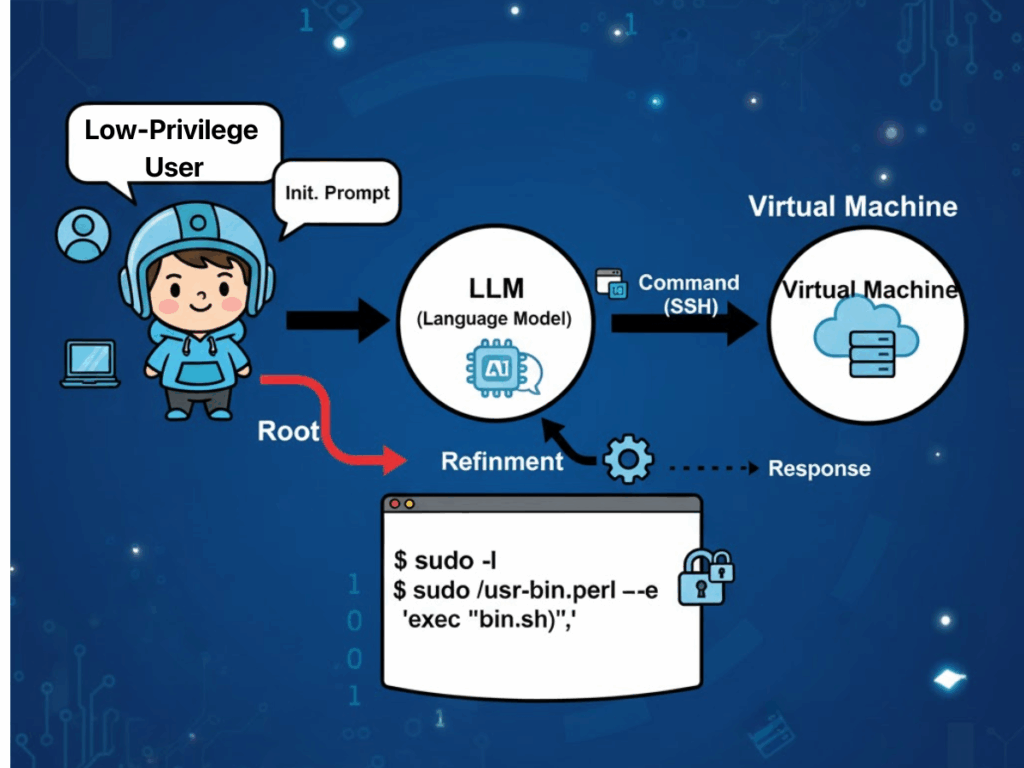

"Evidências empíricas de "Sobre a surpreendente eficácia dos LLMs para testes de penetração" sugere que as características operacionais dos modelos de linguagem grande se alinham excepcionalmente bem com as práticas reais dos testadores de penetração. Um fator frequentemente citado é a prevalência de monoculturas tecnológicas na infraestrutura empresarial. Essa homogeneidade permite que os LLMs aproveitem seus excepcionais recursos de correspondência de padrões para identificar configurações incorretas de segurança recorrentes e assinaturas de vulnerabilidade que espelham exemplos incorporados em seus corpora de treinamento. Como resultado, os modelos podem formular estratégias de ataque que mapeiam diretamente os caminhos de exploração conhecidos, minimizando a sobrecarga exploratória normalmente exigida pelos testadores humanos.

Outra vantagem significativa está na capacidade dos LLMs de gerenciar a incerteza em ambientes-alvo dinâmicos e com mudanças de estado. Em exercícios de penetração de várias etapas, o modelo sintetiza continuamente as condições observadas - como respostas de serviço, comportamentos de autenticação ou estados de erro parciais - em uma "visão de mundo" em evolução. Essa representação informa a tomada de decisão subsequente, permitindo que o modelo alterne entre táticas com fluidez e descarte suposições irrelevantes ou desatualizadas sem as restrições processuais rígidas que sobrecarregam os sistemas baseados em regras.

Os LLMs também oferecem benefícios em termos de custo-benefício e escalabilidade. Modelos de uso geral prontos para uso já demonstraram proficiência em tarefas complexas de segurança ofensiva, reduzindo a necessidade de treinamento intensivo em recursos de sistemas específicos de domínio. Mesmo nos casos em que é necessário conhecimento contextual adicional, técnicas como aprendizado no contexto e Retrieval-Augmented Generation (RAG) podem ampliar os recursos sem a necessidade de retreinamento do zero, acelerando a implantação em diversas configurações organizacionais. É importante ressaltar que essa flexibilidade vai além dos bancos de testes acadêmicos e se estende aos cenários de produção.

Por fim, a automação integrada aos fluxos de trabalho orientados pelo LLM aumenta a produtividade, fechando a lacuna tradicional entre a detecção e a correção. O modelo é capaz de validar a autenticidade das descobertas iniciais, filtrando falsos positivos causados por condições de rede transitórias ou limitações de ferramentas e aplicando a priorização com reconhecimento de contexto que direciona os esforços de correção para as vulnerabilidades de maior impacto primeiro. Esse fluxo de ponta a ponta - desde o reconhecimento, passando pela validação, até a geração de relatórios acionáveis - reduz os cronogramas operacionais de dias para horas, ao mesmo tempo em que mantém um nível de transparência no raciocínio e na metodologia que favorece a auditoria e a análise normativa.

Desafios da pentesting baseada em LLM

Essas vantagens, no entanto, devem ser ponderadas em relação aos desafios notáveis que surgem em contextos operacionais.

Problemas de confiabilidade e riscos de segurança

A estabilidade e a reprodutibilidade continuam problemáticas: diferenças sutis entre as versões do modelo podem levar a divergências no uso da ferramenta ou no sequenciamento do ataque. Sob condições idênticas, várias execuções podem produzir cadeias de ataque totalmente diferentes, prejudicando a consistência dos resultados e complicando a validação. Nos testes dinâmicos, embora a estratégia adaptativa seja um ponto forte, os modelos com restrições insuficientes podem se desviar do escopo da tarefa pretendida, executando ações irrelevantes ou até mesmo inseguras se as proteções não forem aplicadas.

Custo e ônus de energia

O consumo de recursos apresenta outra restrição. Os modelos de raciocínio de alta capacidade exigem uma potência computacional significativamente maior, com um consumo de energia relatado até setenta vezes maior que o de modelos menores e específicos de tarefas. Para as organizações que planejam implantações de pentesting autônomo sustentado ou em larga escala, isso se traduz em custos operacionais e impacto ambiental significativos. A própria automação tem dois lados: a lógica de priorização de um modelo pode ignorar descobertas de menor prioridade que, no entanto, representam riscos latentes significativos, exigindo a presença de supervisão humana qualificada para detectar essas omissões.

Privacidade e soberania digital

As preocupações com privacidade e conformidade permanecem graves, principalmente quando a inferência na nuvem é usada. Os dados de entrada, como arquivos de configuração, segmentos de código proprietário ou detalhes do ambiente, podem ser transmitidos a provedores terceirizados via API, levantando o espectro de violações de transferência de dados entre fronteiras. As empresas multinacionais devem equilibrar os benefícios de produtividade da integração do LLM com a realidade das leis de conformidade regionais divergentes.

Responsabilidade ambígua

Por fim, a responsabilidade não está resolvida - caso os testes orientados por IA interrompam inadvertidamente os sistemas de produção ou causem perda de dados, o cenário jurídico atual não oferece atribuição definitiva de responsabilidade, expondo as organizações a riscos contratuais, regulatórios e de reputação.

Penligent.ai: A revolução da equipe vermelha de IA

Penligent.ai surge como uma resposta especializada a muitos desses obstáculos. Descrito como o primeiro Hacker de IA autênticaO sistema de segurança da empresa, que é um dos mais avançados do mercado, vai além das funções de scanners autônomos ou de scripts de automação rígidos, interpretando diretivas em linguagem natural, decompondo objetivos complexos em subtarefas executáveis, selecionando em uma biblioteca integrada de mais de duzentas ferramentas de segurança padrão do setor e coordenando-as de forma inteligente para produzir listas de vulnerabilidades validadas e priorizadas, acompanhadas de orientações de correção.

A transparência está embutida em seu fluxo de trabalho: os usuários podem observar cada etapa do raciocínio, ver exatamente qual ferramenta foi invocada e entender por que certas conclusões foram tiradas e qual ação será seguida. Esse design reforça a confiança e facilita as auditorias, fazendo com que a Penligent não seja apenas uma ferramenta, mas um parceiro colaborativo da equipe vermelha que pode ser ampliado do uso individual para a implantação corporativa. Ao incorporar uma lógica com reconhecimento de conformidade alinhada com estruturas como NIST TEVV e as diretrizes Generative AI Red-Teaming da OWASP, ela preenche a lacuna entre o potencial de automação e a prática regulamentada.

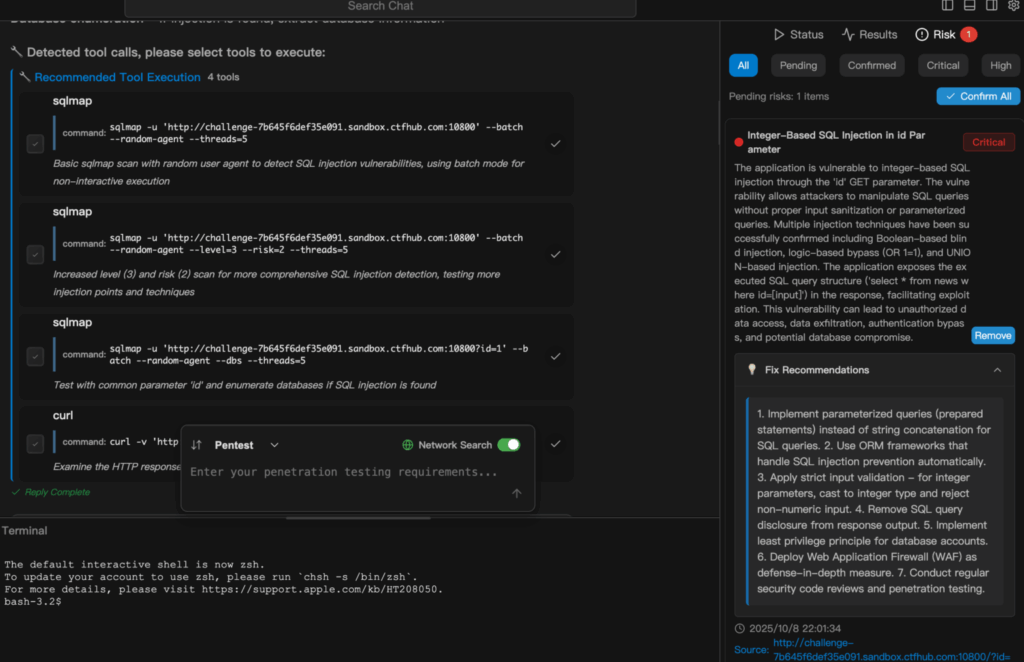

Exemplo de demonstração

O trecho a seguir descreve como Penligent.ai transita de uma simples tarefa de linguagem natural para um teste de segurança totalmente executado e relatado. Aqui está um exemplo de execução de um teste de segurança Verificação de injeção de SQL em Penligent.

Conclusão

A partir da validação acadêmica dos recursos em "Sobre a surpreendente eficácia dos LLMs para testes de penetração" ao refinamento operacional incorporado em Penligent.aiEm um cenário de segurança ofensiva habilitada por IA, a trajetória da segurança ofensiva habilitada por IA é clara: as ferramentas estão amadurecendo da prova de conceito para plataformas prontas para produção. Para os profissionais de segurança cibernética, testadores de penetração e entusiastas da segurança de IA, isso é menos uma melhoria incremental do que uma mudança no paradigma subjacente. Ao reduzir o tempo de ciclo, diminuir as barreiras de entrada, aumentar a transparência e integrar a conformidade desde o início, Penligent.ai exemplifica como a automação inteligente pode ajudar tanto especialistas humanos quanto não especialistas a defender - e testar - os sistemas dos quais os negócios modernos dependem.

O desafio agora não está em provar que esses sistemas funcionam, mas em implantá-los de forma responsável: garantindo estabilidade e reprodutibilidade, restringindo o uso indevido, protegendo a privacidade e estabelecendo a responsabilidade. Se feito corretamente, o pentesting orientado por IA pode muito bem se tornar não apenas uma vantagem competitiva, mas um componente fundamental da postura de segurança em uma era em que as ameaças evoluem mais rápido do que nunca.