É possível sentir a divisão na sala: metade da equipe está sorrindo porque as varreduras automatizadas significam uma cobertura mais rápida; a outra metade está franzindo a testa porque a automação também comete erros em escala empresarial. Queda mapa de sql em um pipeline orientado por IA e essa divisão se torna um abismo. Você obtém alcance e repetibilidade, além do potencial de executar varreduras ruidosas ou não autorizadas com uma única solicitação casual.

Não se trata de um pânico moral. É uma tensão prática. mapa de sql é uma ferramenta: madura, sem corte e muito boa para trazer à tona sinais de injeção. Se você deixar um modelo rodar um mapa de sql e depois esquecer o que ele fez, você verá três resultados na prática:

Descobertas úteis quando uma sonda de injeção destaca uma falha lógica real;

- Falsos positivos que desperdiçam horas do analista;

- E o ocasional soluço operacional quando uma varredura atinge a produção inesperadamente.

O mais interessante não é saber se ferramentas como mapa de sql são boas ou ruins - elas são - mas sim como você as integra em um pipeline que mantém o julgamento e a governança humanos no circuito. É aí que o debate fica interessante: devemos confiar na IA para escrever e executar comandos de scanner? Ou a IA deve ser tratada como um analista júnior que propõe testes, com os humanos dando a aprovação final?

Abaixo, esboço uma perspectiva equilibrada, com um módulo de código mínimo e seguro para mostrar como a automação deve ser (sem exploração, apenas orquestração), além das proteções práticas de que você realmente precisa.

Uma orquestração de alto nível

Pense nisso como o encanamento que deve ficar entre o seu prompt de IA e qualquer scanner. Ele nunca contém cargas úteis de exploit, apenas intenção, escopo e etapas de análise.

Pseudo-orquestração #: A IA sugere testes, o sistema aplica a política, o analisador faz a triagem

def request_scan(user_prompt, target_list):

intent = ai_interpret(user_prompt) # por exemplo, "verificar o risco de SQLi"

escopo = policy.enforce_scope(target_list, intent)

if not scope.authorized:

return "Varredura não autorizada para os alvos solicitados".

job = scheduler.create_job(scope, mode="non-destructive")

O scanner # é chamado por meio de um executor controlado que impõe regras

run = scanner_runner.execute(job, scanner="sqlmap-wrapper", safe_mode=True)

telemetria = collector.gather(run, include_logs=True, include_app_context=True)

findings = analyzer.correlate(telemetry, ruleset="multi-signal")

report = reporter.build(findings, prioritize=True, require_human_review=True)

retornar relatório

Observações sobre o pseudocódigo acima:

O sqlmap-wrapper é uma camada conceitual que impõe modos não destrutivos e limites de taxa;

analisador.correlacionar significa "não confie apenas na saída do scanner - faça uma verificação cruzada com os logs do WAF, os rastreamentos de erros do banco de dados e a telemetria do aplicativo".

Por que o invólucro é importante

A saída bruta do scanner é uma escuta telefônica com ruído. Uma única mapa de sql A execução pode produzir dezenas de linhas "interessantes" que, no contexto, são inofensivas.

Um wrapper bem projetado tem três funções:

Aplicação do escopo - somente alvos permitidos, somente ambientes autorizados; nenhuma varredura de produção acidental.

Modos seguros e limites de taxa - forçar opções não destrutivas, limitar as solicitações para evitar o impacto no tempo de atividade.

Correlação contextual - combine os resultados do scanner com os sinais de tempo de execução (blocos WAF, erros de banco de dados, latência incomum) antes de atribuir a algo uma pontuação de alta confiança.

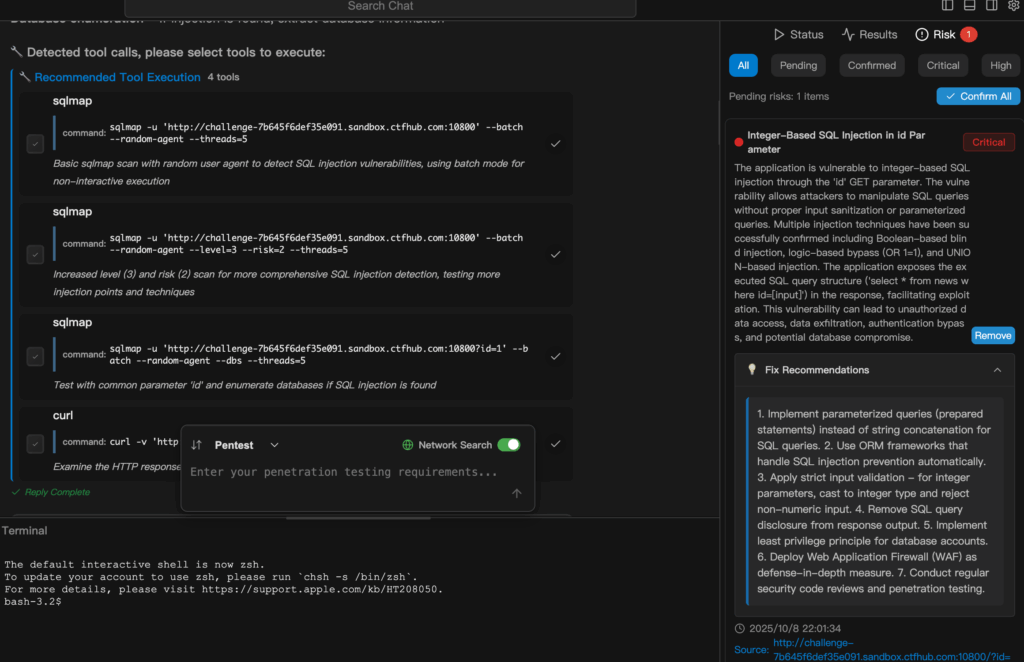

A Penligent se situa precisamente na camada de correlação e triagem.

Ele não elogia a saída bruta do scanner. Ele a digere, faz referências cruzadas com a telemetria e diz:

"Este vale a pena ser registrado porque se alinha com os erros de banco de dados + alertas do WAF."

Ou: "Provavelmente ruído - verifique antes de aumentar".

A controvérsia: democratização versus armamento

É aqui que as opiniões esquentam. A automação reduz o nível dos testes - esse é o argumento da democratização, e é verdade.

Pequenas equipes de segurança e equipes de desenvolvimento podem obter cobertura significativa rapidamente.

Mas essa mesma facilidade torna mais provável o uso indevido acidental.

Você pode imaginar uma mensagem apressada no Slack que se transforma em uma varredura ampla e barulhenta.

Ou um modelo mal ajustado que sugere um teste agressivo para um endpoint sensível.

Se você estiver fazendo isso, duas perguntas são importantes:

- Quem pode solicitar um exame? (autenticação + regras de aprovação)

- Quem assina o tíquete de remediação? (engenheiros com contexto, não um bot automatizado)

Tratar a IA como um multiplicador de produtividade, não como um substituto para a governança.

Uma lista de verificação prática do guardrail (para equipes que desejam velocidade e segurança)

- Autorização em primeiro lugar: varreduras somente após uma aprovação verificada, registrada e auditável.

- Padrões não destrutivos reforçados: impõe sondas somente leitura e tempos limite conservadores.

- Triagem de vários sinais: A saída do scanner deve estar alinhada com pelo menos uma outra fonte de sinal antes da priorização automática.

- Controle humano no circuito: os itens de gravidade crítica exigem aprovação humana antes da correção ou de testes agressivos.

- Capacidade de reprodução e evidências: Registros completos e reproduzíveis de solicitações/respostas, além do contexto (versão do aplicativo, mecanismo de banco de dados, regras WAF).

- Limites de taxa e raio de explosão: Limitadores por alvo e limites globais de simultaneidade.

- Regras de retenção e privacidade: As varreduras que tocam em PII são marcadas e tratadas de acordo com as políticas de proteção de dados.

Onde a Penligent se encaixa no ciclo

A Penligent não substitui os scanners, mas operacionaliza seus resultados.

Use Penligent para:

- Transforme uma intenção de teste de linguagem natural em um trabalho verificado por políticas.

- Execute sondas de scanner higienizadas (por meio de invólucros seguros).

- Colete telemetria em logs de aplicativos, WAF, banco de dados e rede.

- Correlacione os sinais e apresente apenas os resultados de alta confiança com as etapas de correção.

Essa última parte é importante.

Em um mundo automatizado, a triagem se torna a habilidade mais escassa: distinguir os problemas reais do ruído de fundo.

A Penligent automatiza a triagem, mas mantém o revisor humano no circuito das decisões de alto impacto.

A verdade incômoda

A automação encontrará mais problemas mais rapidamente do que os humanos sozinhos.

Isso parece ótimo, até que as pessoas que dirigem as organizações percebam que isso também gera mais tíquetes, mais interrupções e maior potencial de impacto acidental.

A verdadeira habilidade é projetar o fluxo de trabalho de modo que a relação sinal-ruído melhore à medida que você aumenta, e não diminua.

Se você insiste em um parâmetro concreto:

Automação sem A triagem aumenta o trabalho falso-positivo proporcionalmente ao volume de exames.

Automação com A triagem aumenta o rendimento real da correção.

A diferença é a camada do analisador.

Nota final - um argumento que vale a pena ser apresentado

Alguns dirão "proíbam as varreduras iniciadas por IA" porque os riscos são existenciais.

Isso é falta de visão. O objetivo não é proibir a capacidade; é construir barreiras de proteção para que a capacidade ajude os defensores em vez de ajudar os atacantes.

Se sua organização não puder implementar políticas, auditorias e correlação, não acione o botão de automação.

Se você puder, os ganhos de produtividade são reais: menos etapas manuais, verificação mais rápida de hipóteses e um melhor ciclo de feedback entre a detecção e a correção.