2025 yılında TU Wien'den Andreas Happe ve Jürgen Cito "Sızma Testi için LLM'lerin Şaşırtıcı Etkinliği Üzerine" diyerek şaşırtıcı bir gerçeği ortaya koymuştur: Büyük Dil Modelleri (LLM'ler) örüntü tanıma, saldırı zinciri oluşturma ve dinamik ortamlarda belirsizlikle başa çıkma gibi temel pentesting görevlerinde insan uzmanlarla eşleşebilir ve bazen onları geçebilir ve tüm bunları yaparken uygun maliyetli ölçeklenebilirlik sunar.

Artan siber tehditler, ciddi yetenek kıtlığı ve giderek karmaşıklaşan kurumsal altyapı karşısında bu yeni bir döneme işaret ediyor: komuta hattı odaklı "kara büyü "den Yapay zeka destekli güvenlik testi. Saldırgan güvenlik araç setine yerleştirilen yapay zeka ile kurumlar test döngülerini günlerden saatlere indirebilir ve gelişmiş pentest becerilerini herkesin erişebileceği bir güvenlik altyapısına dönüştürebilir.

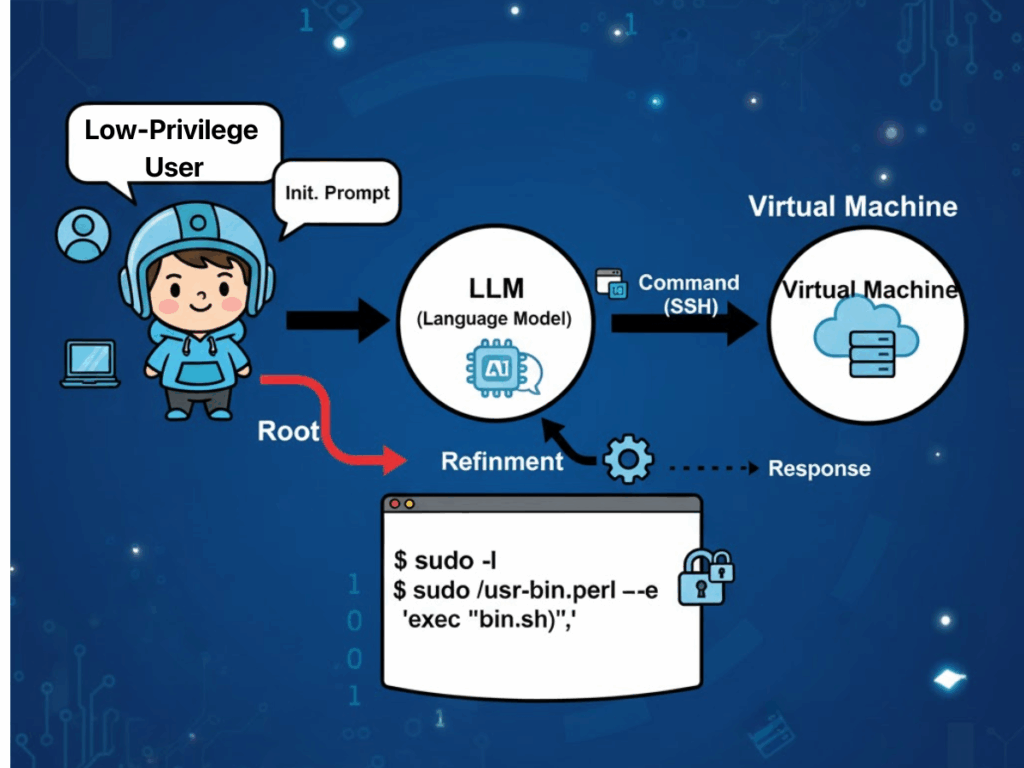

Sızma Testlerinde LLM'ler Nasıl Uygulanır?

"Türkiye'den ampirik kanıtlar "Sızma Testi için LLM'lerin Şaşırtıcı Etkinliği Üzerine" Büyük Dil Modellerinin operasyonel özelliklerinin, sızma test uzmanlarının gerçek dünyadaki uygulamalarıyla alışılmadık derecede iyi uyum sağladığını göstermektedir. Sıklıkla atıfta bulunulan bir faktör, kurumsal altyapı içinde teknolojik monokültürlerin yaygınlığıdır. Bu tür bir homojenlik, LLM'lerin, eğitim derlemelerinde gömülü örnekleri yansıtan yinelenen güvenlik yanlış yapılandırmalarını ve güvenlik açığı imzalarını belirlemek için olağanüstü desen eşleştirme yeteneklerinden yararlanmalarına olanak tanır. Sonuç olarak, modeller doğrudan bilinen istismar yollarıyla eşleşen saldırı stratejileri formüle edebilir ve insan test uzmanlarının tipik olarak ihtiyaç duyduğu keşif yükünü en aza indirebilir.

Bir diğer önemli avantaj da LLM'lerin dinamik ve durum değiştiren hedef ortamlarda belirsizliği yönetme kabiliyetinde yatmaktadır. Çok adımlı sızma tatbikatlarında model, hizmet yanıtları, kimlik doğrulama davranışları veya kısmi hata durumları gibi gözlemlenen koşulları sürekli olarak gelişen bir "dünya görüşü" halinde sentezler. Bu temsil, sonraki karar alma süreçlerini bilgilendirerek modelin taktikler arasında akıcı bir şekilde geçiş yapmasını ve kural tabanlı sistemleri zorlayan katı prosedürel kısıtlamalar olmadan alakasız veya modası geçmiş varsayımları atmasını sağlar.

LLM'ler ayrıca maliyet verimliliği ve ölçeklenebilirlik avantajları da sağlar. Kullanıma hazır genel amaçlı modeller, karmaşık saldırgan güvenlik görevlerinde yetkinliklerini kanıtlamış ve alana özgü sistemlerin kaynak yoğun eğitim ihtiyacını azaltmıştır. Ek bağlamsal bilginin gerekli olduğu durumlarda bile, bağlam içi öğrenme ve Geri Getirme-Artırılmış Nesil (RAG) gibi teknikler, sıfırdan eğitim almadan yetenekleri genişletebilir ve çeşitli kurumsal ortamlara dağıtımı hızlandırabilir. Daha da önemlisi, bu esneklik akademik test ortamlarının ötesine geçerek üretim sınıfı senaryolara kadar uzanmaktadır.

Son olarak, LLM odaklı iş akışlarına entegre edilen otomasyon, tespit ve düzeltme arasındaki geleneksel boşluğu kapatarak üretkenliği artırır. Model, ilk bulguların gerçekliğini doğrulayabilir, geçici ağ koşullarının veya araç sınırlamalarının neden olduğu yanlış pozitifleri filtreleyebilir ve düzeltme çabalarını önce en etkili güvenlik açıklarına yönlendiren bağlama duyarlı önceliklendirme uygulayabilir. Böyle bir uçtan uca akış - keşiften doğrulamaya ve eyleme geçirilebilir raporlamaya kadar - operasyonel zaman çizelgelerini günlerden saatlere sıkıştırırken, denetim ve düzenleyici incelemeye elverişli muhakeme ve metodolojide şeffaflık düzeyini korur.

LLM Tabanlı Pentesting'in Zorlukları

Ancak bu avantajlar, operasyonel bağlamlarda ortaya çıkan kayda değer zorluklara karşı tartılmalıdır.

Güvenilirlik Sorunları ve Güvenlik Riskleri

Kararlılık ve tekrar üretilebilirlik sorunlu olmaya devam etmektedir: model sürümleri arasındaki ince farklılıklar, araç kullanımında veya saldırı sıralamasında farklılıklara yol açabilir. Aynı koşullar altında, birden fazla çalıştırma tamamen farklı saldırı zincirleri üretebilir, bu da sonuç tutarlılığını zayıflatır ve doğrulamayı zorlaştırır. Dinamik testlerde, uyarlanabilir strateji güçlü bir yön olsa da, yeterince kısıtlanmamış modeller amaçlanan görev kapsamından sapabilir, korkuluklar uygulanmazsa alakasız ve hatta güvenli olmayan eylemler gerçekleştirebilir.

Maliyet ve Enerji Yükü

Kaynak tüketimi başka bir kısıtlama oluşturmaktadır. Yüksek kapasiteli muhakeme modelleri önemli ölçüde daha fazla hesaplama gücü gerektirir ve enerji kullanımının daha küçük, göreve özgü modellerin yetmiş katına kadar çıktığı bildirilmiştir. Sürekli veya büyük ölçekli otonom pentesting dağıtımları planlayan kuruluşlar için bu, anlamlı operasyonel maliyetler ve çevresel etki anlamına gelir. Otomasyonun kendisi iki uçludur: bir modelin önceliklendirme mantığı, yine de önemli gizli riskler oluşturan daha düşük öncelikli bulguları gözden kaçırabilir ve bu tür ihmalleri yakalamak için yetenekli insan gözetiminin varlığını gerektirir.

Gizlilik ve Dijital Egemenlik

Özellikle bulut çıkarımı kullanıldığında, gizlilik ve uyumluluk endişeleri ciddiyetini korumaktadır. Yapılandırma dosyaları, tescilli kod segmentleri veya ortam ayrıntıları gibi girdi verileri API aracılığıyla üçüncü taraf sağlayıcılara iletilebilir ve bu da sınır ötesi veri aktarımı ihlallerinin ortaya çıkmasına neden olabilir. Çok uluslu işletmeler, LLM entegrasyonunun üretkenlik avantajlarını farklı bölgesel uyum yasaları gerçeğiyle dengelemelidir.

Belirsiz Hesap Verebilirlik

Son olarak, hesap verebilirlik konusu çözüme kavuşturulmamıştır - yapay zekaya dayalı testlerin üretim sistemlerini yanlışlıkla bozması veya veri kaybına neden olması durumunda, mevcut yasal ortam sorumluluğun kesin olarak belirlenmesini sağlayamamakta ve kuruluşları sözleşmeye dayalı, düzenleyici ve itibar riskine maruz bırakmaktadır.

Penligent.ai: Yapay Zeka Kırmızı Takım Devrimi

Penligent.ai bu engellerin çoğuna özel bir yanıt olarak ortaya çıkmaktadır. Dünyanın ilk Agentic AI HackerDoğal dil direktiflerini yorumlayarak, karmaşık hedefleri yürütülebilir alt görevlere ayrıştırarak, iki yüzden fazla endüstri standardı güvenlik aracından oluşan entegre bir kütüphaneden seçim yaparak ve düzeltme rehberliği eşliğinde doğrulanmış, önceliklendirilmiş güvenlik açığı listeleri üretmek için bunları akıllıca koordine ederek bağımsız tarayıcıların veya katı otomasyon komut dosyalarının rollerinin ötesine geçer.

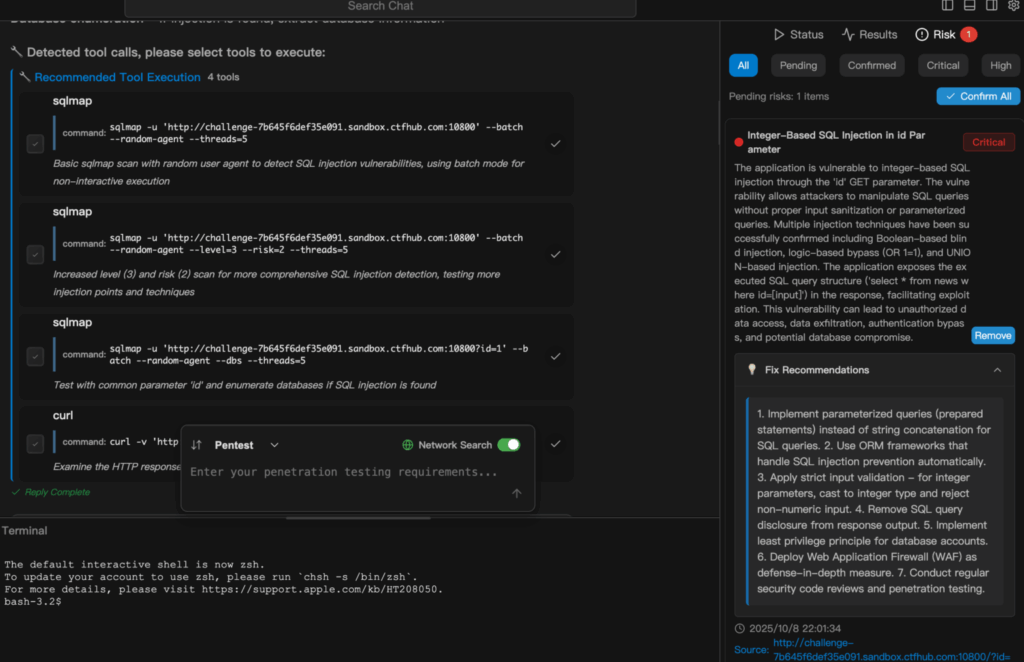

Şeffaflık iş akışına dahil edilmiştir: kullanıcılar her muhakeme adımını gözlemleyebilir, tam olarak hangi aracın çağrıldığını görebilir ve belirli sonuçların neden çıkarıldığını ve hangi eylemin takip edeceğini anlayabilir. Bu tasarım güveni artırır ve denetimleri kolaylaştırır, Penligent'ı yalnızca bir araç değil, bireysel kullanımdan kurumsal dağıtıma kadar ölçeklenen işbirlikçi bir kırmızı ekip ortağı haline getirir. NIST TEVV ve OWASP'ın Generative AI Red-Teaming yönergeleri gibi çerçevelerle uyumlu uyumluluk bilincine sahip mantığı yerleştirerek, otomasyon potansiyeli ile düzenlenmiş uygulama arasındaki boşluğu doldurur.

Örnek Gösterim

Aşağıdaki alıntı nasıl yapıldığını özetlemektedir Penligent.ai Basit bir doğal dil görevinden tamamen yürütülen ve raporlanan bir güvenlik testine geçişler. İşte bir güvenlik testi çalıştırma örneği SQL enjeksiyon taraması Penligent'ta.

Sonuç

Yeteneklerin akademik olarak doğrulanmasından "Sızma Testi için LLM'lerin Şaşırtıcı Etkinliği Üzerine" 'de somutlaştırılan operasyonel iyileştirmeye Penligent.aiYapay zeka destekli saldırgan güvenliğin gidişatı açık: araçlar kavram kanıtlama aşamasından üretime hazır platformlara doğru olgunlaşıyor. Siber güvenlik uzmanları, sızma test uzmanları ve yapay zeka güvenlik meraklıları için bu, temel paradigmada bir değişimden ziyade artımlı bir gelişmedir. Döngü süresini kısaltarak, giriş engellerini azaltarak, şeffaflığı artırarak ve uyumluluğu en başından itibaren entegre ederek, Penligent.ai akıllı otomasyonun hem insan uzmanlara hem de uzman olmayan kişilere modern iş dünyasının bağlı olduğu sistemleri savunmada ve test etmede nasıl yardımcı olabileceğini örneklendiriyor.

Şu anki zorluk bu sistemlerin çalıştığını kanıtlamak değil, onları sorumlu bir şekilde dağıtmaktır: istikrar ve tekrarlanabilirlik sağlamak, kötüye kullanımı engellemek, gizliliği korumak ve hesap verebilirlik oluşturmak. Doğru yapıldığında, yapay zeka odaklı pentesting sadece bir rekabet avantajı değil, tehditlerin her zamankinden daha hızlı geliştiği bir çağda güvenlik duruşunun temel bir bileşeni haline gelebilir.