Pourquoi le centre de gravité se déplace-t-il au niveau local ?

Les LLM dans le nuage restent remarquables, mais la réalité des équipes rouges est impitoyable : les limites de taux arrivent au milieu de l'engagement, les remaniements de prix cassent les modèles de planification et les changements de politique régionale perturbent la collecte de preuves. Pour les équipes qui vivent et meurent de la reproductibilité, de la criminalistique et des pistes d'audit, ces incertitudes ne sont pas une nuance, mais un risque opérationnel. Parallèlement, les environnements réglementés dans les domaines de la santé, de la finance et du secteur public préfèrent de plus en plus que les données sensibles soient conservées. jamais La plupart des utilisateurs quittent les réseaux contrôlés, ce qui pousse l'exécution des modèles vers les ordinateurs portables, les stations de travail et les clusters privés. Ce changement est visible au grand jour : des rapports font état de la montée de l'"IA fantôme", une grande partie des employés reconnaissant l'utilisation non autorisée de l'IA qui risque d'exposer les données ; la leçon à tirer pour la sécurité est simple : possédez votre chemin d'inférence ou quelqu'un d'autre le fera. (Cybernews)

La deuxième force est la transparence. Les petits modèles open-source - 7 à 13 milliards de paramètres, quantifiés, élagués et ajustés - deviennent "suffisamment bons" pour une grande partie du triage, de la génération de PoC et de l'aide à l'écriture de scripts, tout en restant vérifiables au niveau du poids et du modèle d'invite. Si l'on ajoute à cela un coût marginal par exécution proche de zéro et une latence locale inférieure à la seconde sur les GPU de base, on obtient une boucle d'expérimentation à la fois plus rapide et plus facile à gérer qu'un point de terminaison distant de type boîte noire. La voie locale d'abord minimise également le rayon d'action des pannes en amont et des changements de politique qui, autrement, bloqueraient une fenêtre de test. Pourtant, "local" n'est pas automatiquement "sûr" : des analyses récentes ont trouvé des centaines de points d'extrémité LLM auto-hébergés, y compris Ollama, exposés sur l'internet public, ce qui nous rappelle que le contrôle d'accès de base et l'isolation du réseau sont toujours importants. (TechRadar)

Sources : Cybernews sur la prévalence et les risques de l'IA de l'ombre ; TechRadar et Cisco Talos sur les serveurs Ollama exposés. (TechRadar)

Définir pentestai en pratique

pentestai est la définition de travail de Penligent pour les tests de pénétration assistés par l'IA : une méthode et un flux de travail où de petits LLM locaux et open-source orchestrent votre chaîne d'outils existante - Burp, SQLMap, Nuclei, GHunt - tout en capturant les commandes, les paramètres, les artefacts et les étapes de reproduction comme une piste de preuve permanente. Le modèle n'est pas l'"acteur" ; c'est le collaborateur qui propose des commandes, synthétise des PoC et raisonne sur les résultats des scanners sous supervision humaine. Dans une posture hybride, les tâches de raisonnement à longue chaîne ou de contexte ultra-long peuvent être confiées à des modèles en nuage, mais la vérification et la collecte de preuves initiales restent sur le matériel que vous contrôlez.

Les arguments en faveur d'un "LLM local + ouvert de petite taille".

Une posture locale d'abord s'adapte parfaitement aux contrôles de confidentialité et de conformité car les données restent à l'intérieur des limites de l'appareil et de votre système d'audit d'enregistrement. Cette approche s'aligne sur les familles de contrôle bien connues des responsables de la sécurité - application des règles d'accès, audit et minimisation des données - codifiées dans des cadres tels que NIST SP 800-53. En outre, les poids ouverts permettent un examen externe, une vérification de la chaîne d'approvisionnement et une reproduction déterministe des résultats entre les équipes et dans le temps. Lorsque le nuage s'étrangle, tombe en panne ou change de conditions, votre équipe rouge ne s'éteint pas ; elle continue sur le poste de travail à côté de vous. Mise en garde : traitez votre modèle d'exécution local comme un service sensible - authentifiez-le, segmentez-le et ne l'exposez jamais directement à l'internet. (Centre de ressources en sécurité informatique du NIST)

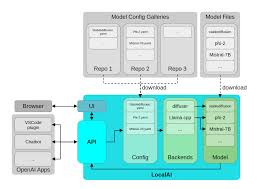

Une pile de référence pour pentestai

Local ne signifie pas monolithique. Il s'agit d'une capacité échelonnée de manière réfléchie, où chaque échelon a un rôle de test spécifique et où l'ensemble de l'échelle peut être transféré dans le nuage pour des raisons de complexité, d'échelle ou de fenêtre contextuelle lorsque cela est justifié.

| Niveau | Matériel typique | Modèle/temps d'exécution | Rôle principal | Notes |

|---|---|---|---|---|

| Prototype léger | Classe MacBook | Ollama fonctionnement des modèles quantifiés 7B-13B | Prompt→ synthèse des commandes, petites PoC, triage des logs | Portable, privé, à faible latence. (Ollama) |

| Laboratoire budgétaire | GTX 1070 / iGPU | GGUF avec llama.cpp ou LM Studio | Perceuses à air comprimé, automatisation hors ligne | Stable même sur les anciens GPU/iGPU. (huggingface.co) |

| Poste de travail haut de gamme | RTX 4090 (24GB) | Orchestration multi-agents + boucles fuzz | Grandes séries d'actifs, validation parallèle | Concurrence élevée, cycles de rétroaction courts. (NVIDIA) |

| Bordure et mobile | Appareils Apple + ML de base | Inférence sur l'appareil | Échantillonnage sur le terrain dans les sites réglementés | Exposition zéro au nuage pour les PHI/PII. (Développeur Apple) |

Dans cette architecture, Ollama simplifie la gestion des modèles locaux et l'accès à l'API, GGUF fournit un format efficace et portable optimisé pour l'inférence CPU/GPU, RTX 4090 les systèmes de classe déverrouillent le flou agressif et les flux multi-agents, et ML de base conserve les données sensibles sur l'appareil tout en exploitant le moteur neuronal d'Apple. (Ollama)

Qu'est-ce qui change dans les tests quotidiens ?

Pour Web/API pentestai accélère la boucle entre l'OSINT et la découverte de paramètres, la génération d'hypothèses et les vérifications modélisées. Les IDOR candidats, les règles d'autorisation mal définies ou les contournements de limites de taux peuvent être transformés en modèles Nuclei vérifiables à l'aide d'invites et d'un petit échafaudage d'analyse, tandis que les risques liés au contrôle d'accès et à l'injection s'alignent proprement sur les modèles Nuclei et les règles de contrôle d'accès. Top 10 de l'OWASP et ASVS que vous utilisez déjà pour les rapports. (Fondation OWASP)

En pouvoirs et fédération les modèles aident à composer et à valider les plans d'essai pour le travail des OAuth 2.0 et OpenID Connect flux : l'état, le nonce, l'audience et la durée de vie des jetons cessent d'être des connaissances tribales et deviennent des éléments de la liste de contrôle auxquels sont attachés des scripts. L'avantage n'est pas un "exploit magique", mais un moyen rigoureux et reproductible de vérifier les hypothèses, d'enregistrer chaque tentative et de préserver les artefacts pour examen. (datatracker.ietf.org)

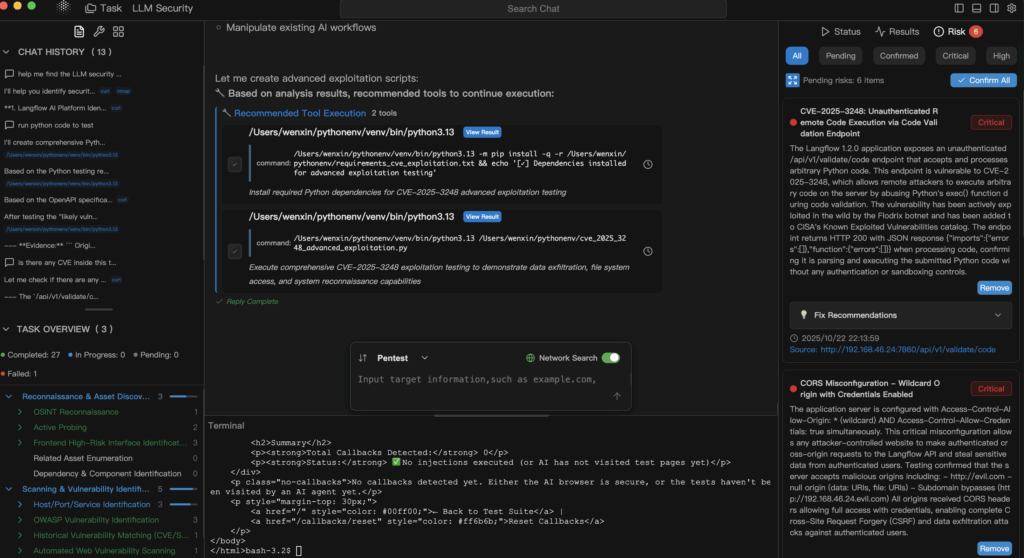

Pour LLM sécurité-Les modèles locaux sont doublement utiles : ils simulent les intrants adverses et raisonnent sur la défense en profondeur sans envoyer vos messages, instructions système ou corpus nettoyés en dehors de votre périmètre. Il s'agit là d'une victoire en termes de gouvernance des données et de rapidité. En attendant, les points d'extrémité LLM mal configurés de l'industrie sont une mise en garde : si vous vous hébergez vous-même, verrouillez votre système. (TechRadar)

Une chaîne locale minimale : vérification des noyaux à l'aide d'un modèle

# Utiliser un modèle local 7B-13B via Ollama pour synthétiser un modèle Nuclei+commande.

prompt='Generate a Nuclei template to probe for a basic IDOR at /api/v1/user?id=... .

Ne renvoyer que du YAML valide et une commande Nuclei d'une ligne pour l'exécuter.'

curl -s http://localhost:11434/api/generate \N

-d '{"model" : "llama3.1:8b-instruct-q4", "prompt" :"'"$prompt"'", "stream" : false}' \N - jq -r '.response".

| jq -r '.response' > gen.txt

# Extraire YAML et l'exécuter, puis hacher les artefacts dans un journal d'audit.

awk '/^id : /,/^$/' gen.txt > templates/idor.yaml

nuclei -t templates/idor.yaml -u https://target.example.com -o evidence/idor.out

sha256sum templates/idor.yaml evidence/idor.out >> audit.log

Il ne s'agit pas de "laisser le modèle pirater". C'est dirigé par l'homme l'automatisation avec un champ d'application restreint, des preuves capturées et une reproduction déterministe.

Une gouvernance qui résiste aux audits

La priorité au niveau local n'excuse pas la faiblesse du processus. Traitez les invites comme des actifs versionnés, exécutez des tests unitaires pour la sécurité et le déterminisme, et appliquez le RBAC à votre couche d'orchestration. Faites correspondre vos contrôles aux NIST SP 800-53 Les familles d'outils doivent être identifiées par vos réviseurs : contrôle d'accès (AC), audit et responsabilité (AU), gestion de la configuration (CM) et intégrité du système et de l'information (SI). Conservez l'exécution du modèle dans un segment privé, exigez une authentification et enregistrez toutes les invocations, y compris le texte d'invite, les appels d'outils et les hachages des artefacts générés. Et parce que la plupart des résultats de l'interface Web/API finissent par se retrouver dans les rapports de la direction, liez votre langage et votre sévérité aux éléments suivants OWASP pour minimiser les cycles de réécriture avec AppSec et la conformité. (Centre de ressources en sécurité informatique du NIST)

Quand passer à l'informatique dématérialisée et pourquoi l'hybride est honnête

Il existe des raisons légitimes d'utiliser des modèles hébergés : contextes extrêmement longs, raisonnement en plusieurs étapes sur des corpus hétérogènes ou accords de niveau de service rigoureux pour les pipelines de production. Une politique défendable est "locale pour la vérification, dans le nuage pour l'échelle", avec des règles explicites de traitement des données et de rédaction intégrées. Elle tient compte du fait que certains problèmes dépassent les limites pratiques du matériel local, tout en maintenant le cœur sensible de vos tests à l'intérieur de votre périmètre d'audit.

Où se situe Penligent si vous avez besoin d'un chemin productif

Penligent opérationnalise pentestai dans un flux de travail axé sur les preuves : les instructions en langage naturel sont transformées en chaînes d'outils exécutables ; les résultats sont validés et enregistrés avec des paramètres et des artefacts ; et les rapports s'alignent sur les cadres auxquels vos parties prenantes font déjà confiance, tels que Top 10 de l'OWASP et NIST SP 800-53. Soutien aux déploiements Ollama pour la gestion locale, GGUF des modèles pour une inférence efficace, et ML de base pour les tests sur les appareils lorsque l'absence d'exposition au cloud est une exigence de conformité. Le résultat est un dispositif d'équipe rouge "toujours actif" qui survit aux limites de taux des fournisseurs, aux changements de politique et aux partitions du réseau sans perdre sa capacité d'audit. (Ollama)

Lecture pratique et points d'ancrage déjà utilisés par votre équipe

Si vos tests portent sur l'authentification et l'identité, conservez la section OAuth 2.0 et OpenID Connect Si vous passez à l'échelon supérieur, assurez-vous que vos preuves sont toujours rattachées à la même colonne vertébrale. Pour encadrer les risques liés au web, indiquez aux chefs de produit et aux responsables de l'ingénierie les points suivants Top 10 de l'OWASP afin que les cycles de remédiation soient plus courts et moins conflictuels. Et si vous optez pour les postes de travail, établissez le profil d'un RTX 4090 pour le fuzzing parallèle et l'orchestration d'agents ; si vous restez mobile ou dans la clinique, utilisez ML de base et sa chaîne d'outils pour conserver les données réglementées sur l'appareil. (datatracker.ietf.org)

Sources d'information

- Shadow-AI prevalence and workplace risk (Cybernews ; TechRadar summary of the same survey). (Cybernews)

- Points d'extrémité LLM locaux exposés, y compris Ollama (TechRadar ; Cisco Talos blog). (TechRadar)

- OWASP Top 10 (officiel). (Fondation OWASP)

- NIST SP 800-53 Rev. 5 (HTML et PDF officiels). (Centre de ressources en sécurité informatique du NIST)

- OAuth 2.0 (RFC 6749) et OpenID Connect Core 1.0. (datatracker.ietf.org)

- Références Ollama et GGUF ; documentation Core ML ; page produit NVIDIA RTX 4090. (Ollama)

Liens d'autorité à garder à portée de main :

Top 10 de l'OWASP - NIST SP 800-53 Rév. 5 - RFC 6749 OAuth 2.0 - OpenID Connect Core 1.0 - Ollama - Vue d'ensemble du GGUF - Documentation de base sur la ML - GeForce RTX 4090