重心が地元に移りつつある理由

クラウドLLMは依然として注目に値するが、レッドチームの現実は容赦がない。契約途中で料金の上限がやってきたり、価格設定の変更で計画モデルが崩れたり、地域政策の転換で証拠収集が混乱したりする。再現性、フォレンジック、きれいな監査証跡を生きがいにしているチームにとって、こうした不確実性はニュアンスではなく、業務上のリスクである。これと並行して、医療、金融、公共部門などの規制環境では、機密データについて、次のような対応を求める傾向が強まっている。 決して その結果、モデルの実行はラップトップ、ワークステーション、プライベート・クラスタへと移行している。このシフトはオープンな場でも目にすることができる。レポートでは「シャドーAI」の台頭を追跡しており、従業員の多くがデータ漏洩のリスクを伴う無許可のAI利用を認めている。(サイバーニュース)

第二の力は透明性である。7Bから13Bのパラメータを量子化し、刈り込み、チューニングしたオープンソースの小規模モデルは、トリアージ、PoC生成、スクリプト作成支援の大部分にとって「十分」なものになりつつある。これを、コモディティGPUでの実行あたりの限界コストと秒以下のローカルレイテンシと組み合わせることで、リモートのブラックボックス・エンドポイントよりも高速で管理しやすい実験ループを得ることができる。また、ローカルファーストのルートは、テストウィンドウを停止させるような上流の停止やポリシー変更の影響範囲を最小限に抑えます。しかし、"ローカル "が自動的に "安全 "というわけではない。最近のスキャンで、Ollamaを含む何百ものセルフホストLLMエンドポイントが公衆インターネット上に露出していることが判明した。(テックレーダー)

情報源 CybernewsがシャドーAIの普及とリスクについて、TechRadarとCisco Talosが暴露されたOllamaサーバーについて。(テックレーダー)

定義 ペンテスタイ 実際に

ペンテスタイ これは、ローカルのオープンソース小型LLMが、既存のツールチェーン(Burp、SQLMap、Nuclei、GHunt)をオーケストレーションし、コマンド、パラメータ、成果物、再現ステップを永続的な証跡としてキャプチャする方法とワークフローです。モデルは「アクター」ではない。 協力者 これは、コマンドを提案し、PoCを合成し、人間の監視下でスキャナ出力を推論する。ハイブリッド態勢では、ロングチェーンの推論や超ロングコンテキストのタスクはクラウドモデルにエスカレーションできるが、検証や最初の証拠収集はコントロールするハードウェアに留まる。

"ローカル+オープンな小規模LLM "のケース

ローカル・ファーストの態勢は、データがデバイスのバウンダリと監査システムの記録内に残るため、プライバシーとコンプライアンスのコントロールに明確にマッピングされます。このアプローチは、以下のようなフレームワークで体系化されている、セキュリティ・リーダーにとって馴染み深いコントロール・ファミリー(アクセスの強制、監査、データの最小化)に合致しています。 NIST SP 800-53.さらに、オープン・ウェイトは、外部からのレビュー、サプライチェーンでの検証、チームや時間を超えた調査結果の確定的な再現を可能にする。クラウドが速度を落としたり、失敗したり、条件を変更したりしても、レッドチームは暗くなることはない。注意点:ローカルのモデル・ランタイムを機密性の高いサービスとして扱い、認証し、セグメント化し、決してインターネットに直接公開しないこと。(NISTコンピュータセキュリティリソースセンター)

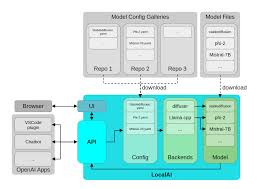

リファレンス・スタック ペンテスタイ

ローカルとはモノリシックという意味ではない。それは、各階層が特定のテストの役割を担い、複雑さやスケール、コンテキストのウィンドウが必要な場合は、はしご全体がクラウドに引き渡されるような、思慮深く段階化されたキャパシティを意味する。

| ティア | 典型的なハードウェア | モデル/ランタイム | 主な役割 | 備考 |

|---|---|---|---|---|

| 軽量プロトタイプ | MacBookクラス | オーラマ 7B-13B量子化モデルの走行 | プロンプト→コマンド合成、小規模PoC、ログトリアージ | ポータブル、プライベート、低遅延。(オーラマ) |

| 予算ラボ | GTX 1070 / iGPU | GGUF llama.cppまたはLM Studioを使用します。 | エアギャップドリル、オフラインオートメーション | 古いGPU/iGPUでも安定。(ハギングフェイス) |

| ハイエンド・ワークステーション | RTX 4090 (24GB) | マルチエージェント・オーケストレーション+ファズ・ループ | 大規模な資産セット、並列検証 | 高い並行性、短いフィードバックサイクル。(エヌビディア) |

| エッジ&モバイル | アップル製品 コアML | オンデバイス推論 | 規制サイトでのフィールド・サンプリング | PHI/PIIのクラウド暴露ゼロ。(アップル開発者) |

この建築では、 オーラマ は、ローカルモデルの管理とAPIアクセスを簡素化します、 GGUF は、CPU/GPU推論用に最適化された、効率的でポータブルなフォーマットを提供する、 RTX 4090 アグレッシブなファジングとマルチエージェントフローのロックを解除するクラスシステム。 コアML は、AppleのNeural Engineを活用しながら、機密データをデバイス上に保持します。(オーラマ)

日々のテストで何が変わるか

について ウェブ/API ペンテスタイは、OSINTとパラメータの発見から、仮説生成とテンプレート化されたチェックまでのループを加速する。候補となるIDOR、誤ったスコープの認可ルール、またはレート制限のバイパスは、プロンプトと小さな構文解析の足場によって検証可能なNucleiテンプレートに変えることができる。 OWASPトップ10 そして エーエスブイエス すでに報告書に使用しているガイダンス(OWASP財団)

で クレデンシャルとフェデレーション のテスト計画を作成し、検証するのに役立ちます。 OAuth 2.0 そして OpenID Connect フロー:ステート、nonce、オーディエンス、トークンのライフタイムは、部族の知識ではなくなり、スクリプトが添付されたチェックリスト項目になる。その利点は、「魔法のエクスプロイト」ではなく、仮定を監査し、各試行をログに記録し、レビューのために成果物を保存する厳密で反復可能な方法である。(datatracker.ietf.org)

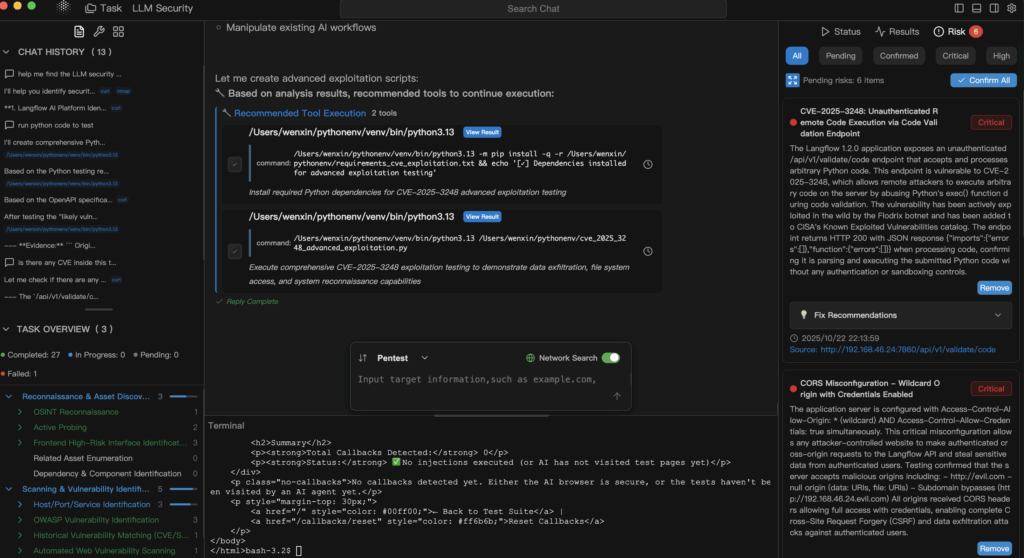

について LLMセキュリティ-プロンプト・インジェクション、流出、ジェイルブレイク、ポリシー・バイパスなど、ローカル・モデルは二重の意味で有用である。敵対的な入力をシミュレートし、プロンプト、システム指示、サニタイズされたコーパスを外部に送信することなく、深層防衛を推論することができる。これは、データ・ガバナンスとスピードの両方の利点がある。一方、業界の誤った設定のLLMエンドポイントは警告の物語である。(テックレーダー)

最小のローカルチェーン:モデルアシストによる核検証

# Ollama経由でローカルの7B-13Bモデルを使用して、Nucleiテンプレート+コマンドを合成する。

prompt='/api/v1/user?id=...で基本的なIDORをプローブするNucleiテンプレートを生成する。

有効なYAMLとそれを実行するための1行のnucleiコマンドのみを返す'

curl -s http://localhost:11434/api/generate

-d '{"model": "llama3.1:8b-instruct-q4", "prompt":"'"$prompt"'", "stream": false}' ¦.

| jq -r '.response' > gen.txt

# YAMLを抽出して実行し、アーティファクトを監査ログにハッシュする。

awk '/^id:/,/^$/' gen.txt > templates/idor.yaml

nuclei -t templates/idor.yaml -u https://target.example.com -o evidence/idor.out

sha256sum templates/idor.yaml evidence/idor.out >> audit.log

これは "モデルにハッキングさせる "ことではない。これは 人間主導 狭いスコープ、捕捉された証拠、決定論的な再現性を持つ自動化。

監査に耐えうるガバナンス

ローカルファーストは、脆弱なプロセスを許すものではない。プロンプトをバージョン管理された資産として扱い、安全性と決定性のためにユニットレベルのテストを実行し、オーケストレーションレイヤーにRBACを適用する。コントロールを NIST SP 800-53 アクセス制御(AC)、監査と説明責任(AU)、構成管理(CM)、システムと情報の完全性(SI)である。モデルのランタイムをプライベートセグメントに保持し、認証を要求し、プロンプトテキスト、ツールの呼び出し、生成された成果物のハッシュを含むすべての起動をログに記録する。また、Web/APIで発見されたことのほとんどは、最終的に経営陣の報告書に記載されることになるため、言語と重大度を次のように結びつけます。 オワスプ AppSecとコンプライアンスで書き換えサイクルを最小化する。(NISTコンピュータセキュリティリソースセンター)

クラウドへの移行時期とハイブリッドが誠実な理由

ホストされたモデルを使用する正当な理由がある:非常に長いコンテキスト、異種コーパスにわたる多段階推論、あるいは本番パイプラインの厳しい可用性SLAなどである。検証はローカルで、スケールはクラウドで」というのが、明確なデータ処理ルールと再編集を組み込んだ、正当なポリシーである。ローカルのハードウェアの実用的な限界を超える問題もあるという現実を認識しつつ、機密性の高いテストの核心を監査境界内に保つことができる。

製品化されたパスが必要な場合、Penligentが適合する場所

ペンリジェントの運用 ペンテスタイ 自然言語による指示は実行可能なツールチェーンに変換され、調査結果はパラメータと成果物で検証され、記録されます。 OWASPトップ10 そして NIST SP 800-53.デプロイのサポート オーラマ 現地管理のために、 GGUF 効率的な推論のためのモデル コアML は、クラウドへの露出をゼロにすることがコンプライアンス要件であるオンデバイス・テスト向けに開発されました。その結果、監査可能性を失うことなく、ベンダーのレート制限、ポリシーの変更、ネットワーク・パーティションに耐える「常時オン」のレッドチーム態勢が実現します。(オーラマ)

チームがすでに使用している実践的なリーディングとアンカー

テストが認証とIDにまたがる場合は OAuth 2.0 そして OpenID Connect クラウドにエスカレーションする場合は、エビデンスが同じレポーティングスパインにマッピングされていることを確認する。ウェブリスクの枠組みについては、プロダクトマネジャーとエンジニアリングリーダーに以下を示す。 OWASPトップ10 プライマーを使用することで、修復サイクルを短縮し、敵対関係を少なくすることができる。また、ワークステーションを使うのであれば RTX 4090 並列ファジングとエージェント・オーケストレーションのためのクラス・システム。 コアML およびそのツールチェーンは、規制されたデータをデバイス上に保持する。(datatracker.ietf.org)

情報源

- シャドーAIの普及と職場のリスク(Cybernews、TechRadarによる同調査の要約)。(サイバーニュース)

- Ollamaを含む、公開されたローカルLLMエンドポイント(TechRadar; Cisco Talos blog)。(テックレーダー)

- OWASPトップ10(公式)。(OWASP財団)

- NIST SP 800-53 Rev. 5 (公式 HTML および PDF)。(NISTコンピュータセキュリティリソースセンター)

- OAuth 2.0 (RFC 6749) と OpenID Connect Core 1.0.(datatracker.ietf.org)

- OllamaとGGUFのリファレンス; Core MLのドキュメント; NVIDIA RTX 4090の製品ページ。(オーラマ)

手元に置いておきたい権威あるリンク

OWASPトップ10 - NIST SP 800-53 Rev. 5 - RFC 6749 OAuth 2.0 - OpenID Connect Core 1.0 - オーラマ - GGUFの概要 - コアMLドキュメント - GeForce RTX 4090